הוספה של AI גנרטיבי לאפליקציה יכולה להביא יתרונות וערך אדיר המשתמשים, אבל הם גם דורשים תשומת לב רבה כדי לשמור על הבטיחות והפרטיות שהמשתמשים מצפים לקבל.

תכנון בטוח

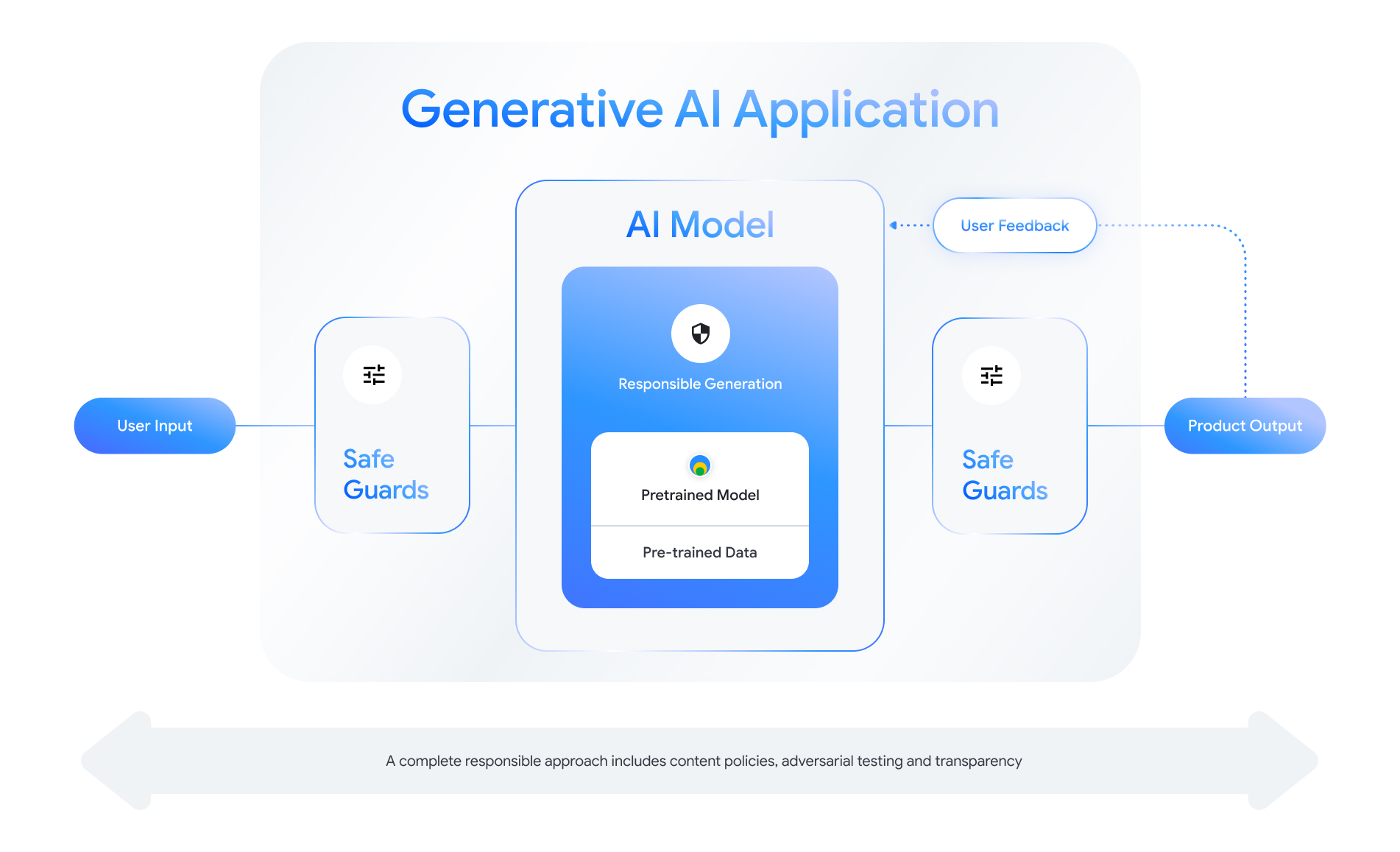

כל תכונה שמופעלת על ידי AI גנרטיבי מציעה הזדמנויות לעצב שכבות בטיחות. בתור שמוצגת באיור הבא, אחת הדרכים שבאמצעותן אפשר לחשוב על בטיחות היא מודל AI שמאפשר להפעיל את התכונה הזו במרכז. המודל צריך להיות:

- מיושר לביצוע המשימה שהוקצתה לו;

- מוגנים באמצעות אמצעי הגנה כדי להבטיח שגבולות אל קלט ופלט נדחים. וגם

- הערכה כוללת כדי להעריך את האופן שבו המודל מגיבים לאינטראקציות שמשפיעות על הבטיחות.

כדאי לעיין "יצירת מוצרי AI אחראיים" סשן מ- Google I/O 2024 כדי ללמוד עוד על שיקולי עיצוב, תרגילי מחשבה, ושיטות ליצירת אב טיפוס שיכולות לעזור להאיץ את הפיתוח האחראי שיטות עבודה מומלצות.

בנוסף, אפשר ללמוד שיטות מומלצות ולראות דוגמאות של:

- הגדרת המדיניות שתקבע את אופן הפעולה של AI הבקשה שלך,

- יצירת ארטיפקטים של שקיפות לצורך תקשורת הגישה האחראית כלפי המשתמשים שלכם. וגם

- אבטחת האפליקציה מפני שימוש זדוני.

מעל הכול, חשוב לזכור שגישה נכונה לבטיחות ולאחריות שמשקף את עצמו ומסתגל לנושאים טכניים, תרבותיים ולתהליכי אתגרים חדשים. עוררו עניין בקרב הצוות בבדיקות סדירות ושוטפות של המודעות כדי להבטיח את התוצאות הטובות ביותר.

הגדרת כללי מדיניות ברמת המערכת

במדיניות בנושא בטיחות התוכן מוגדרים סוגים של תוכן פוגעני שאסור לפרסם בפלטפורמה באינטרנט. יכול להיות שאתם מכירים את מדיניות התוכן של הפלטפורמות כמו YouTube או Google Play. תוכן לגבי יישומים של בינה מלאכותית גנרטיבית דומה: הם מגדירים תוכן שהאפליקציה לא אמורה ליצור, והוא מנחה את האופן שבו מכווננים מודלים ואילו אמצעי הגנה מתאימים להוסיף.

המדיניות צריכה לשקף את התרחיש לדוגמה של האפליקציה שלכם. לדוגמה, להשתמש במוצר של בינה מלאכותית גנרטיבית שמטרתו להציע רעיונות לפעילויות לכל המשפחה הצעות מהקהילה עשויות להיות מדיניות שאוסרת על יצירת תוכן אלים מטבעו, כי הוא עלול להזיק למשתמשים. לעומת זאת, אפליקציה שמסכמת רעיונות לסיפורי מדע בדיוני שמשתמשים מציעים, אני רוצה לאפשר יצירה של אלימות, כי זה נושא בסיפורים רבים הז'אנר הזה.

מדיניות הבטיחות שלך צריכה לאסור על יצירת תוכן פוגעני למשתמשים או לא חוקי, וצריך לציין אילו סוגי תוכן שנוצר מתאימים של האפליקציה. כדאי גם לשקול לכלול חריגים לתוכן חינוכי, תיעודי, מדעי או אומנותי, עלולים להיחשב מזיקים.

הגדרת מדיניות ברורה ברמת פירוט גבוהה, כולל החריגות מהמדיניות הזו, באמצעות דוגמאות, הן הבסיס ליצירת המוצר. אנחנו משתמשים במדיניות שלכם בכל שלב בפיתוח המודל. לנתונים ניקוי או תיוג בצורה מדויקת, אי-דיוקים עלולים להוביל לתיוג שגוי של נתונים, להסרת יתר או בהסרת נתונים, שתשפיע על תגובות הבטיחות של המודל שלכם. עבור למטרות הערכה, מדיניות מוגדרת באופן שגוי תוביל שונות, ולכן קשה יותר לדעת אם המודל עומד רגילים.

כללי מדיניות היפותטיים (להמחשה בלבד)

הנה כמה דוגמאות לכללי מדיניות שכדאי להשתמש בהם עבור בתנאי שהם תואמים לתרחיש לדוגמה שלכם.

| קטגוריית מדיניות | מדיניות |

|---|---|

| פרטים אישיים מזהים בעלי רגישות גבוהה (SPII) | האפליקציה לא תקרא תוכן רגיש או פרטים אישיים מזהים פרטי (למשל: אימייל, מספר כרטיס אשראי מספר תעודת זהות של אדם פרטי). |

| דברי שטנה | האפליקציה לא תיצור תוכן שלילי או פוגעני טירגוט של זהות ו/או מאפיינים מוגנים (למשל, השמצות גזעניות, קידום אפליה, קריאה לאלימות נגד קבוצות). |

| הטרדה | האפליקציה לא תיצור תוכנה זדונית, מפחידה, בריונות, או תוכן פוגעני שמופנה כלפי אדם אחר (למשל, תוכן פיזי איומים, הכחשת אירועים טרגיים, זלזול בקורבנות אלימות). |

| תוכן מסוכן | האפליקציה לא תיצור הוראות או ייעוץ לגבי פגיעה עצמי ו/או אחרים (למשל: גישה לנשק חם או בניית כלי נשק חם מטעני נפץ, קידום טרור, הוראות או התאבדות). |

| תוכן מיני בוטה | האפליקציה לא תיצור תוכן שמכיל הפניות ל- מעשים מיניים או תוכן גס אחר (למשל: תוכן מיני גרפי תיאורים, תוכן שמטרתו לגרום לעוררות מינית). |

| מתן גישה למוצרים ושירותים מזיקים | האפליקציה לא תיצור תוכן שמקדם או מאפשר גישה לפעילויות, לשירותים ולמוצרים שעלולים להזיק (למשל, סיוע בגישה לקידום הימורים, תרופות, זיקוקים או שירותי מין). |

| תוכן זדוני | האפליקציה לא תפיק הוראות לביצוע לא חוקי או פעילויות מטעות (למשל, יצירת תרמיות פישינג, ספאם או תוכן שמטרתו לבצע שידול המוני או שיטות לפריצת Jailbreak). |

ארטיפקטים של שקיפות

תיעוד הוא שיטת מפתח להשגת שקיפות למפתחים, רשויות ממשלתיות, גורמי מדיניות ומשתמשי קצה של המוצר. תנאי כזה עשוי לכלול להפיק דוחות טכניים מפורטים או מודלים, נתונים וכרטיסי מערכת יפרסם באופן הולם מידע שחיוני לציבור על סמך בטיחות ומודל אחר ואת ההערכות שלו. ארטיפקטים של שקיפות הם יותר מכלי תקשורת. הם וגם לספק הדרכה לחוקרים של AI, לפריסה ולמפתחים במורד הזרם (downstream) לשימוש אחראי במודל. המידע שימושי למשתמשי קצה של כדי להבין פרטים על המודל.

כמה הנחיות שקיפות שכדאי להביא בחשבון:

- היה ברור למשתמשים כשהם משתמשים בניסוי ניסיוני על טכנולוגיית בינה מלאכותית גנרטיבית, ולהדגיש את האפשרות ליצירת מודל לא צפוי או התנהגות המשתמשים.

- לספק מסמכים מפורטים לגבי השירות או המוצר של AI גנרטיבי עובדת בשפה מובנת. מומלץ לפרסם תוכן מובנה ארטיפקטים שמבוססים על שקיפות, כמו כרטיסי מודלים. הכרטיסים האלה מספקים את הפרטים הבאים לשימוש המיועד של המודל ותסכם הערכות במהלך פיתוח המודל.

- מראים לאנשים איך הם יכולים לתת משוב ואיך הם שולטים, למשל

כ:

- אספקת מנגנונים שיעזרו למשתמשים לאמת שאלות המבוססות על עובדות

- סמלי 'לייק' ו'דיסלייק' למשוב ממשתמשים

- קישורים לדיווח על בעיות והצעות לתמיכה בתגובה מהירה במקרים הבאים משוב מהמשתמשים

- בקרת משתמש לאחסון או למחיקה של פעילות משתמשים

מערכות AI מאובטחות

אפליקציות שתומכות ב-AI גנרטיבי קיימות פלטפורמות מתקפה מורכבות שמחייבות מיטיגציות מגוונות יותר מאשר אפליקציות קונבנציונליות. המסגרת Secure AI Framework (SAIF) של Google מספקת פתרון מקיף שתשקלו איך לעצב אפליקציה מבוססת-AI גנרטיבי לשימושים מאובטחים. המסגרת הזו יכולה לעזור לכם להעריך איך להפעיל התאמה, הערכה זדונית, וגם מגנים בצורה יעילה כדי לאבטח את האפליקציה שלכם, עם זאת, זכרו שאלה רק ההתחלה. שינויים נוספים ב- סביר להניח שיהיה צורך בנהלים של הארגון, מעקב והתראות להשיג את יעדי האבטחה שלכם בהתאם לתרחיש לדוגמה ולהקשר הספציפי.

משאבים למפתחים

דוגמאות למדיניות בנושא AI גנרטיבי:

- Cloud Gemini API ו-PaLM API מספקים רשימה של מאפייני בטיחות שיכולים לשמש כבסיס ליצירת .

- דוגמה למדיניות שכלולה עדכון לגבי ההתקדמות בעקרונות ה-AI של Google לשנת 2023.

- איגוד MLCommons, קונסורציום הנדסי המבוסס על פילוסופיה של שיתוף פעולה פתוח לשיפור מערכות AI, שלפיהם הם מעריכים מודלים של בטיחות ב-AI נקודת השוואה לבטיחות באמצעות AI.

אין תבנית אחת לכל פריטי המידע שנוצרו בנושא שקיפות בתחום, אבל כרטיסי מודלים קיימים יכולים לשמש כנקודת התחלה. כדי ליצור רשימה כזו:

- כרטיס המודל של Gemma

- תבנית של כרטיס מודל מנייר המודל המקורי

- כרטיסי מודלים מ-Google Cloud APIs