Agregar IA generativa a tu aplicación puede aportar mucho poder y valor a tu a los usuarios, pero también requiere de una mirada atenta para mantener la seguridad y la privacidad que que esperan tus usuarios.

Diseño para la seguridad

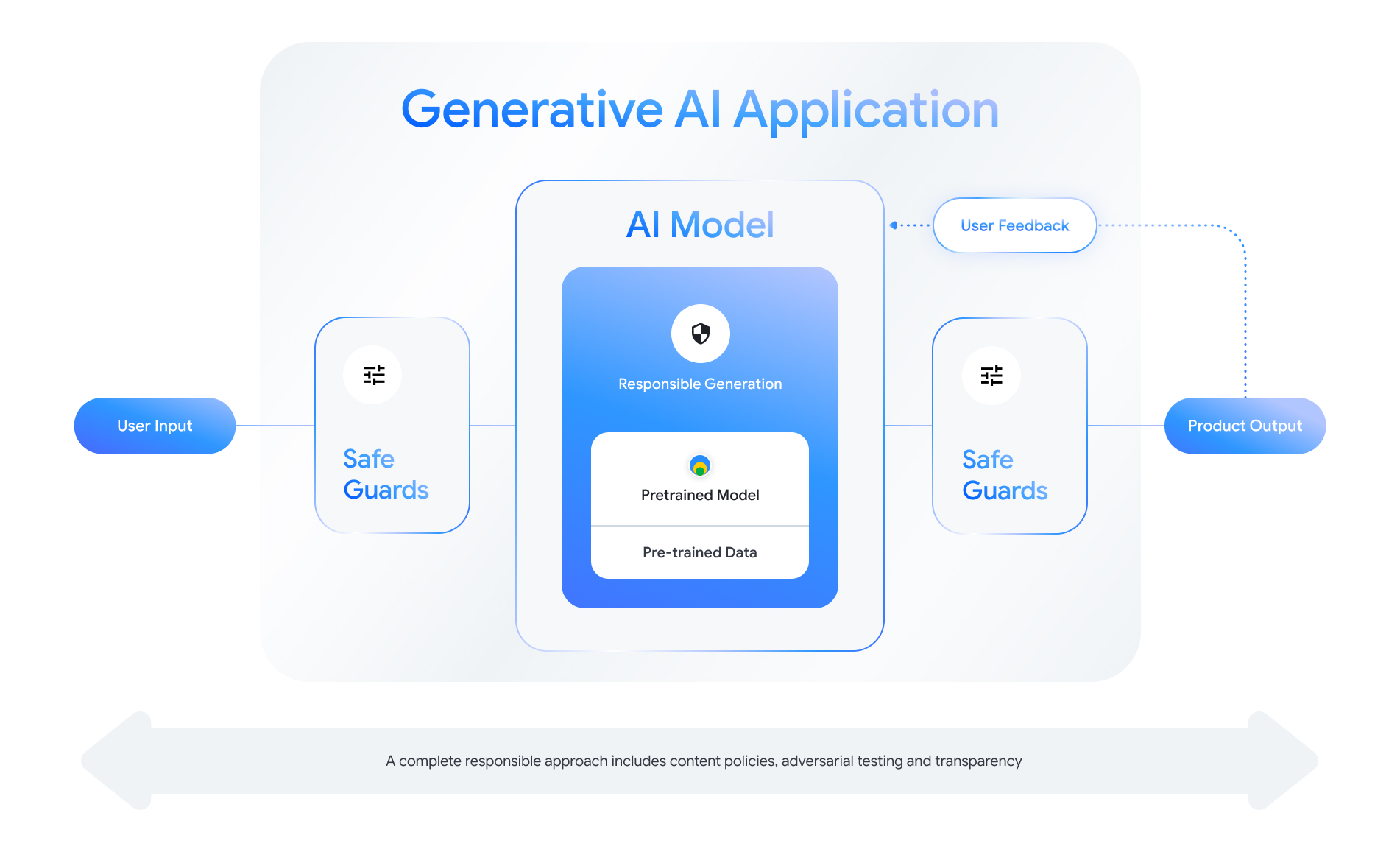

Cada función que habilita la IA generativa presenta oportunidades para diseñar capas de seguridad. Como como se muestra en la siguiente figura, una forma de considerar la seguridad es colocar los de Vertex AI que habilita esta función en el centro. Este modelo debe tener las siguientes características:

- Alineados para realizar la tarea asignada

- Protegido con protecciones para garantizar que fuera de los límites se rechazan las entradas y salidas. y

- Se evalúan de manera integral para evaluar cómo el modelo y de seguridad responde a las interacciones que afectan la seguridad.

Consulta la “Crea productos de IA responsable” sesión desde Google I/O 2024 para obtener más información sobre consideraciones de diseño, ejercicios de pensamiento, y prototipado que pueden ayudarte a acelerar tu desarrollo responsable prácticas recomendadas.

Además, puedes conocer las prácticas recomendadas y ver ejemplos de lo siguiente:

- Definición de las políticas que regirán el comportamiento de la IA tu aplicación;

- Crear artefactos de transparencia para comunicarse el enfoque responsable con los usuarios; y

- Protege tu aplicación del uso malicioso.

Sobre todo, recuerda que un enfoque sólido en cuanto a la seguridad y la responsabilidad es una que sea autorreflexivo y se adapte a las actividades técnicas, culturales y de procesos desafíos de aprendizaje automático. Haz participar a ti mismo y a tu equipo en revisiones periódicas de los de seguridad para garantizar los mejores resultados.

Define políticas a nivel del sistema

Las políticas de seguridad del contenido definen qué tipos de contenido dañino no se permiten en una plataforma en línea. Es posible que conozcas las políticas de contenido de las plataformas como YouTube o Google Play. Contenido las políticas para las aplicaciones de IA generativa son similares: definen contenido que tu aplicación no debería generar y te guían para ajustar modelos y qué medidas de protección debes agregar.

Tus políticas deben reflejar el caso de uso de tu aplicación. Por ejemplo, un producto de IA generativa destinado a ofrecer ideas para actividades familiares basadas en podrían tener una política que prohíba generar contenido violento por naturaleza, ya que podría ser perjudicial para los usuarios Por el contrario, una aplicación que resume ideas de historias de ciencia ficción propuestas por los usuarios puede que queremos permitir la generación de violencia, ya que es tema de muchas historias este género.

Tus políticas de seguridad deben prohibir la generación de contenido dañino a los usuarios o ilegal, y debe especificar qué tipos de contenido generado esa barra para tu aplicación. También puedes considerar incluir excepciones para el contenido educativo, documental, científico o artístico que de otro modo podría considerarse perjudicial.

Definir políticas claras con un nivel de detalle muy detallado, lo que incluye excepciones a la política con ejemplos, es fundamental para crear un entorno producto. Tus políticas se usan en cada paso del desarrollo del modelo. Para datos la limpieza o el etiquetado, la imprecisión puede llevar a que los datos estén mal etiquetados, la eliminación excesiva o la baja eliminación de los datos, lo que afectará las respuestas de seguridad del modelo. Para para la evaluación, las políticas mal definidas darán lugar a un alto nivel variable, lo que hace que sea más difícil saber si tu modelo cumple con con los estándares necesarios.

Políticas hipotéticas (solo a modo de ilustración)

Estos son algunos ejemplos de políticas que podrías usar para tu siempre que coincidan con tu caso de uso.

| Categoría de la política | Política |

|---|---|

| Información de identificación personal sensible (IIPS) | La postulación no incluirá información sensible ni datos de identificación personal información (p.ej., correo electrónico, número de tarjeta de crédito o número de seguridad social de una persona física). |

| Incitación al odio o a la violencia | La aplicación no generará contenido negativo o dañino. a la identidad o atributos protegidos (p.ej., insultos raciales, promoción de la discriminación, llamados a la violencia contra personas grupos). |

| Acoso | La aplicación no generará contenido malicioso, intimidante, o contenido abusivo dirigido a otra persona (p.ej., a personas físicas la negación de eventos trágicos, la denigración de víctimas de violencia). |

| Contenido peligroso | La aplicación no generará instrucciones ni consejos sobre daños a sí mismo o a otras personas (p.ej., acceder o fabricar armas de fuego y dispositivos explosivos, promoción del terrorismo, instrucciones para suicidio). |

| Sexualmente explícito | La aplicación no generará contenido que incluya referencias a actos sexuales u otro contenido lascivo (p.ej., sexualmente gráfico descripciones o contenido destinado a provocar excitación). |

| Facilitación del acceso a bienes y servicios nocivos | La aplicación no generará contenido que promocione o permita acceso a bienes, servicios y actividades potencialmente dañinos (p.ej., facilitar el acceso a la promoción de juegos de apuestas, productos farmacéuticos fuegos artificiales o servicios sexuales). |

| Contenido malicioso | La aplicación no generará instrucciones para realizar acciones o actividades engañosas (p.ej., generación de estafas de phishing, spam o contenido destinado a realizar solicitudes en masa o métodos para liberar jailbreak). |

Artefactos de transparencia

La documentación es un método clave para lograr transparencia para los desarrolladores gobiernos, agentes de políticas y usuarios finales de tu producto. Esto puede implicar lanzar informes técnicos detallados o tarjetas de modelos, datos y sistemas publicar información esencial de forma adecuada según la seguridad y otros modelos y evaluaciones. Los artefactos de transparencia son más que vehículos de comunicación. no también ofrece orientación para investigadores de IA, implementadores y desarrolladores intermedios el uso responsable del modelo. La información es útil para los usuarios finales de sobre tu producto, y que quieren comprender los detalles del modelo.

Estos son algunos lineamientos de transparencia que debes tener en cuenta:

- Sea claro con los usuarios cuando interactúen en un experimento la tecnología de IA generativa y destacar la posibilidad de un modelo de tu modelo.

- Ofrece documentación detallada sobre cómo el servicio o producto de IA generativa funciona con un lenguaje comprensible. Considera publicar contenido estructurado artefactos de transparencia, como las tarjetas de modelos. Estas tarjetas proporcionan la uso previsto de tu modelo y resumir las evaluaciones que se han durante el desarrollo del modelo.

- Muéstrales a las personas cómo pueden enviar comentarios y cómo tienen el control, como

como:

- Proporcionamos mecanismos para ayudar a los usuarios a validar preguntas basadas en hechos.

- Íconos de Me gusta y No me gusta para los comentarios de los usuarios

- Vínculos para informar problemas y ofrecer asistencia para una respuesta rápida a comentarios de los usuarios

- Control del usuario para almacenar o borrar su actividad

Sistemas de IA seguros

Las aplicaciones basadas en IA generativa presentan superficies de ataque complejas que requieren mitigaciones más diversas que las aplicaciones convencionales. El Secure AI Framework (SAIF) de Google proporciona un enfoque framework conceptual para considerar cómo diseñar tu aplicación basada en IA generativa para usos seguros. Este marco de trabajo puede ayudarte a evaluar cómo usar alineación, evaluación adversaria y protecciones eficaces para proteger tu aplicación, pero recuerda que estos son solo los bloques de inicio. Cambios adicionales en es probable que se requieran prácticas de la organización, supervisión y alertas para a lograr sus objetivos de seguridad para su contexto y caso de uso específicos.

Recursos para desarrolladores

Ejemplos de políticas de IA generativa:

- La API de Gemini de Cloud y la API de PaLM brindan de atributos de seguridad que pueden servir de base para crear y políticas de seguridad.

- Ejemplo de políticas incluidas en el Actualización de 2023 sobre el progreso de los principios de la IA de Google.

- La MLCommons Association, un consorcio de ingeniería construido sobre una filosofía de colaboración abierta para mejorar los sistemas de IA; referencias 6 de riesgos en los que evalúan modelos de seguridad de la IA como parte de su Comparativa de seguridad de la IA.

No hay una única plantilla para los artefactos de transparencia en toda la industria, pero las tarjetas de modelos existentes pueden servir como punto de partida para crear uno propio:

- Tarjeta de modelo de Gemma

- Plantilla de tarjeta de modelo del papel de tarjeta de modelo original

- Tarjetas de modelos de las APIs de Google Cloud

Referencias adicionales

- Tarjetas de modelos para los informes de modelos

- Tarjetas de modelos

- Data Cards: Documentación de conjuntos de datos transparente y con propósito para la IA responsable

- Guía de tarjetas de datos

- Bard con la tarjeta del sistema de Gemini Pro adaptada específicamente

- Recursos del Foro de modelos Frontier sobre la formación de equipos de emergencia