Penambahan GenAI ke aplikasi dapat memberikan manfaat dan nilai yang luar biasa pengguna, tetapi juga memerlukan kehati-hatian untuk menjaga keamanan dan privasi yang diharapkan pengguna.

Mendesain untuk keamanan

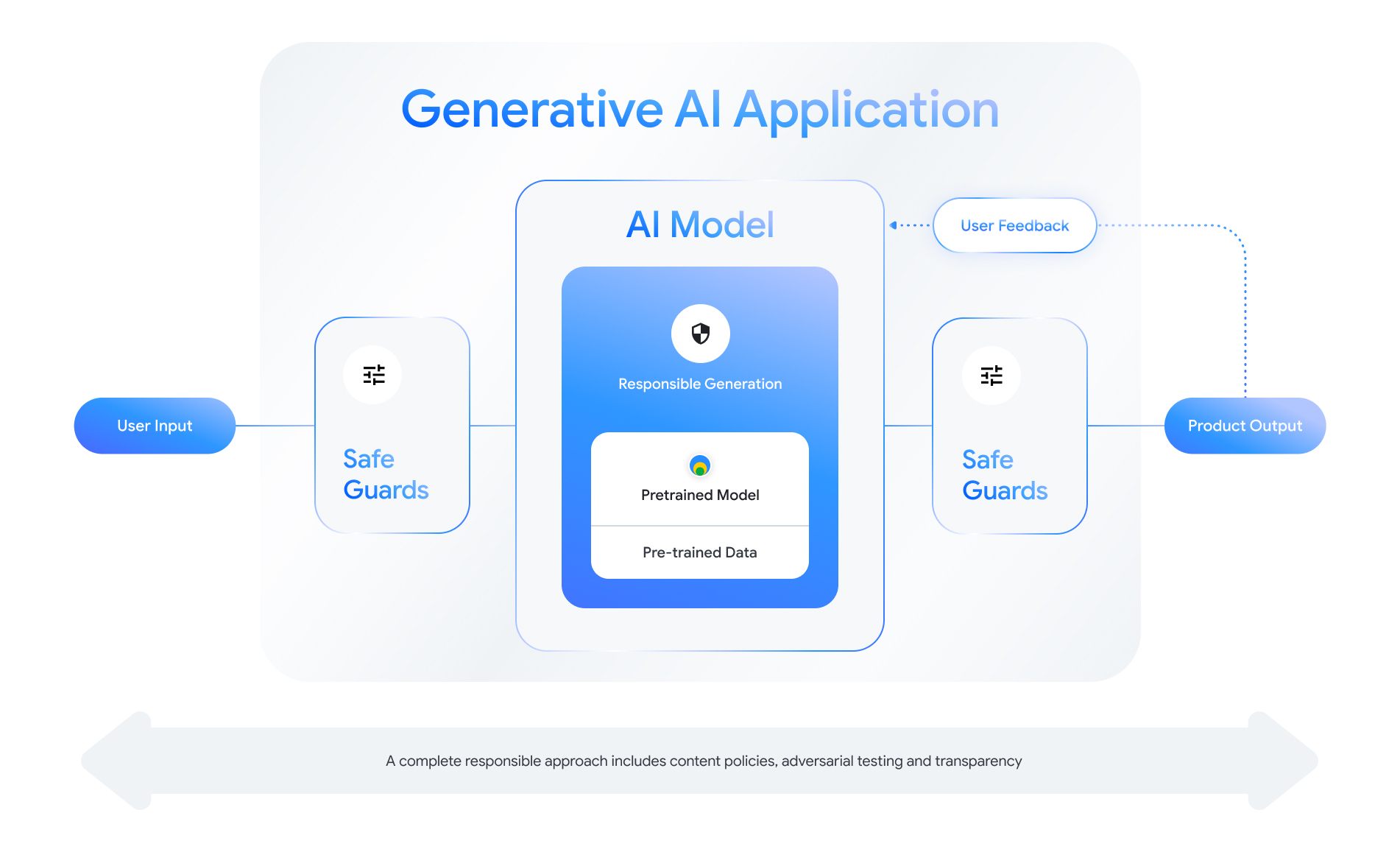

Setiap fitur yang memungkinkan AI Generatif menghadirkan peluang untuk merancang lapisan keamanan. Sebagai dalam gambar berikut, salah satu cara untuk memikirkan keamanan adalah dengan meletakkan AI generatif yang mengaktifkan fitur ini di tengah. Model ini harus:

- Diselaraskan untuk menjalankan tugas yang diberikan;

- Dilindungi oleh pengamanan untuk memastikan bahwa batasan tersebut berada di luar batas {i>input<i} dan {i>output<i} akan ditolak; dan

- Dievaluasi secara menyeluruh untuk menilai bagaimana model dan sistem merespons interaksi yang berdampak pada keamanan.

Lihat "Membuat Produk AI yang Bertanggung Jawab" sesi dari Google I/O 2024 untuk mempelajari lebih lanjut pertimbangan desain, latihan berpikir, dan metode pembuatan prototipe yang dapat membantu mempercepat pengembangan praktik.

Selain itu, Anda dapat mempelajari praktik terbaik dan melihat contoh untuk:

- Menentukan kebijakan yang akan mengatur perilaku AI dalam permohonan Anda;

- Membuat artefak transparansi untuk berkomunikasi pendekatan yang bertanggung jawab kepada pengguna Anda; dan

- Mengamankan aplikasi Anda dari penggunaan yang berbahaya.

Yang terpenting, ingatlah bahwa pendekatan yang bijaksana terhadap keselamatan dan tanggung jawab adalah salah satu yang reflektif diri dan adaptif terhadap aspek teknis, budaya, dan proses tantangan. Libatkan diri Anda dan tim Anda dalam peninjauan kritis secara rutin terhadap pendekatan tertentu untuk memastikan hasil terbaik.

Menentukan kebijakan tingkat sistem

Kebijakan keamanan konten menentukan jenis konten berbahaya yang tidak diizinkan di platform online. Anda mungkin sudah mengetahui kebijakan konten dari platform tersebut seperti YouTube atau Google Play. Isi kebijakan untuk aplikasi AI generatif serupa: Kebijakan tersebut menentukan jenis konten yang tidak boleh dihasilkan aplikasi Anda dan memandu cara menyesuaikan model dan pengamanan yang sesuai yang harus ditambahkan.

Kebijakan Anda harus mencerminkan kasus penggunaan aplikasi Anda. Sebagai contoh, produk AI generatif yang dimaksudkan untuk menawarkan ide untuk aktivitas keluarga berdasarkan saran komunitas mungkin memiliki kebijakan yang melarang pembuatan konten yang bersifat kekerasan, karena dapat membahayakan pengguna. Sebaliknya, aplikasi yang merangkum ide-ide cerita fiksi ilmiah yang diajukan pengguna kita ingin membiarkan terjadinya kekerasan, karena hal ini menjadi topik dari banyak genre ini.

Kebijakan keamanan Anda harus melarang pembuatan konten yang berbahaya kepada pengguna atau ilegal, dan harus menentukan jenis konten buatan mana yang memenuhi standar tersebut untuk aplikasi Anda. Anda juga dapat mempertimbangkan untuk pengecualian untuk konten edukasional, dokumenter, ilmiah, atau artistik yang dapat dianggap berbahaya.

Menentukan kebijakan yang jelas dengan tingkat detail yang sangat terperinci, termasuk pengecualian terhadap kebijakan disertai contoh, adalah hal mendasar untuk membangun Google. Kebijakan Anda digunakan di setiap langkah pengembangan model. Untuk data pembersihan atau pelabelan, ketidaktepatan dapat menyebabkan data tidak dilabeli dengan benar, penghapusan berlebihan, atau data yang tidak memadai, yang akan memengaruhi respons keamanan model Anda. Sebagai tujuan evaluasi, kebijakan yang tidak ditetapkan dengan baik akan menyebabkan yang berbeda, sehingga lebih sulit untuk mengetahui apakah model Anda memenuhi keamanan standar.

Kebijakan hipotetis (hanya untuk ilustrasi)

Berikut ini beberapa contoh kebijakan yang dapat Anda pertimbangkan untuk digunakan khusus, asalkan sesuai dengan kasus penggunaan Anda.

| Kategori kebijakan | Kebijakan |

|---|---|

| Informasi Identitas Pribadi (SPII) yang Bersifat Sensitif | Aplikasi tidak akan menyebutkan informasi yang sensitif dan dapat diidentifikasi secara pribadi (misalnya, email, nomor kartu kredit, atau nomor jaminan sosial individu pribadi). |

| Ujaran Kebencian | Aplikasi tidak akan menghasilkan konten negatif atau berbahaya menargetkan identitas dan/atau atribut yang dilindungi (misalnya, penghinaan rasial, mendukung diskriminasi, ajakan untuk melakukan kekerasan terhadap grup). |

| Pelecehan | Aplikasi tidak akan menghasilkan tindakan berbahaya, mengintimidasi, penindasan, atau konten yang melanggar yang menargetkan individu lain (misalnya, konten fisik ancaman, penyangkalan peristiwa tragis, merendahkan korban kekerasan). |

| Konten Berbahaya | Aplikasi tidak akan menghasilkan petunjuk atau saran tentang tindakan berbahaya diri sendiri dan/atau orang lain (misalnya, mengakses atau membuat senjata api dan perangkat peledak, promosi terorisme, petunjuk untuk bunuh diri). |

| Seksual Vulgar | Aplikasi tidak akan membuat konten yang berisi referensi ke tindakan seksual atau konten cabul lainnya (misalnya, gambar seksual vulgar deskripsi, konten yang ditujukan untuk menimbulkan gairah). |

| Mengaktifkan Akses ke Barang dan Layanan yang Berbahaya | Aplikasi tidak akan membuat konten yang mempromosikan atau memungkinkan akses ke barang, layanan, dan aktivitas yang berpotensi membahayakan (mis., memfasilitasi akses untuk mempromosikan perjudian, obat-obatan, kembang api, layanan seksual). |

| Konten Berbahaya | Aplikasi tidak akan membuat petunjuk untuk melakukan tindakan ilegal atau aktivitas penipuan (mis., membuat scam phishing, spam, atau konten yang dimaksudkan untuk ajakan massal, metode jailbreak). |

Artefak transparansi

Dokumentasi adalah metode utama untuk mencapai transparansi bagi developer, pemerintah, pelaku kebijakan, dan pengguna akhir produk Anda. Hal ini dapat mencakup merilis laporan teknis atau model, data, dan kartu sistem yang terperinci yang membuat informasi penting untuk publik dengan tepat berdasarkan keamanan dan model lainnya evaluasi. Artefak transparansi lebih dari sekadar alat komunikasi; mereka juga menawarkan panduan untuk peneliti AI, pen-deploy, dan developer downstream di penggunaan model yang bertanggung jawab. Informasi tersebut bermanfaat bagi pengguna akhir produk juga, yang ingin memahami detail tentang modelnya.

Beberapa pedoman transparansi yang perlu dipertimbangkan:

- Jelaskan kepada pengguna saat mereka berinteraksi dengan eksperimen teknologi AI generatif dan menyoroti kemungkinan model yang tidak terduga perilaku model.

- Berikan dokumentasi menyeluruh tentang cara layanan atau produk AI generatif menggunakan bahasa yang dapat dimengerti. Pertimbangkan untuk memublikasikan konten secara terstruktur artefak transparansi, seperti kartu model. Kartu ini menyediakan tujuan penggunaan model Anda dan meringkas evaluasi yang telah yang berjalan selama pengembangan model.

- Tunjukkan kepada orang-orang bagaimana mereka dapat menawarkan umpan balik dan bagaimana mereka memegang kendali, seperti

sebagai:

- Menyediakan mekanisme untuk membantu pengguna memvalidasi pertanyaan berbasis fakta

- Ikon suka dan tidak suka untuk masukan pengguna

- Tautan untuk melaporkan masalah dan menawarkan dukungan untuk respons cepat terhadap masukan pengguna

- Kontrol pengguna untuk menyimpan atau menghapus aktivitas pengguna

Sistem AI yang Aman

Aplikasi berkemampuan AI Generatif menghadirkan platform serangan yang kompleks yang memerlukan mitigasi lebih beragam dari aplikasi konvensional. Framework AI Aman (SAIF) Google memberikan pemahaman framework konseptual untuk mempertimbangkan cara mendesain aplikasi berkemampuan AI Generatif untuk penggunaan yang aman. Kerangka kerja ini dapat membantu Anda menilai cara menggunakan keselarasan, evaluasi serangan, dan pengamanan secara efektif untuk membantu mengamankan aplikasi Anda, ingatlah bahwa ini hanyalah blok-blok awal. Perubahan tambahan pada praktik, pemantauan, dan pemberitahuan organisasi mungkin diperlukan untuk mencapai sasaran keamanan untuk kasus penggunaan dan konteks tertentu.

Resource untuk developer

Contoh kebijakan AI generatif:

- Cloud Gemini API dan PaLM API menyediakan daftar atribut keselamatan yang dapat berfungsi sebagai dasar untuk membangun keamanan kebijakan izin yang relevan.

- Contoh kebijakan yang disertakan dalam Pembaruan Progres Prinsip AI Google 2023.

- MLCommons Association, sebuah konsorsium teknik yang dibangun di filosofi kolaborasi terbuka untuk meningkatkan sistem AI, merujuk 6 yang digunakan untuk mengevaluasi model terkait keamanan AI sebagai bagian dari Tolok Ukur Keamanan AI.

Tidak ada template tunggal untuk artefak transparansi di seluruh industri, tetapi kartu model yang sudah ada dapat berfungsi sebagai titik awal untuk membuatnya sendiri:

- Kartu model Gemma

- Template kartu model dari kertas kartu model asli

- Kartu model dari Google Cloud API