เรียกใช้ใน Google Colab เรียกใช้ใน Google Colab

|

ดูแหล่งข้อมูลใน GitHub ดูแหล่งข้อมูลใน GitHub

|

ภาพรวม

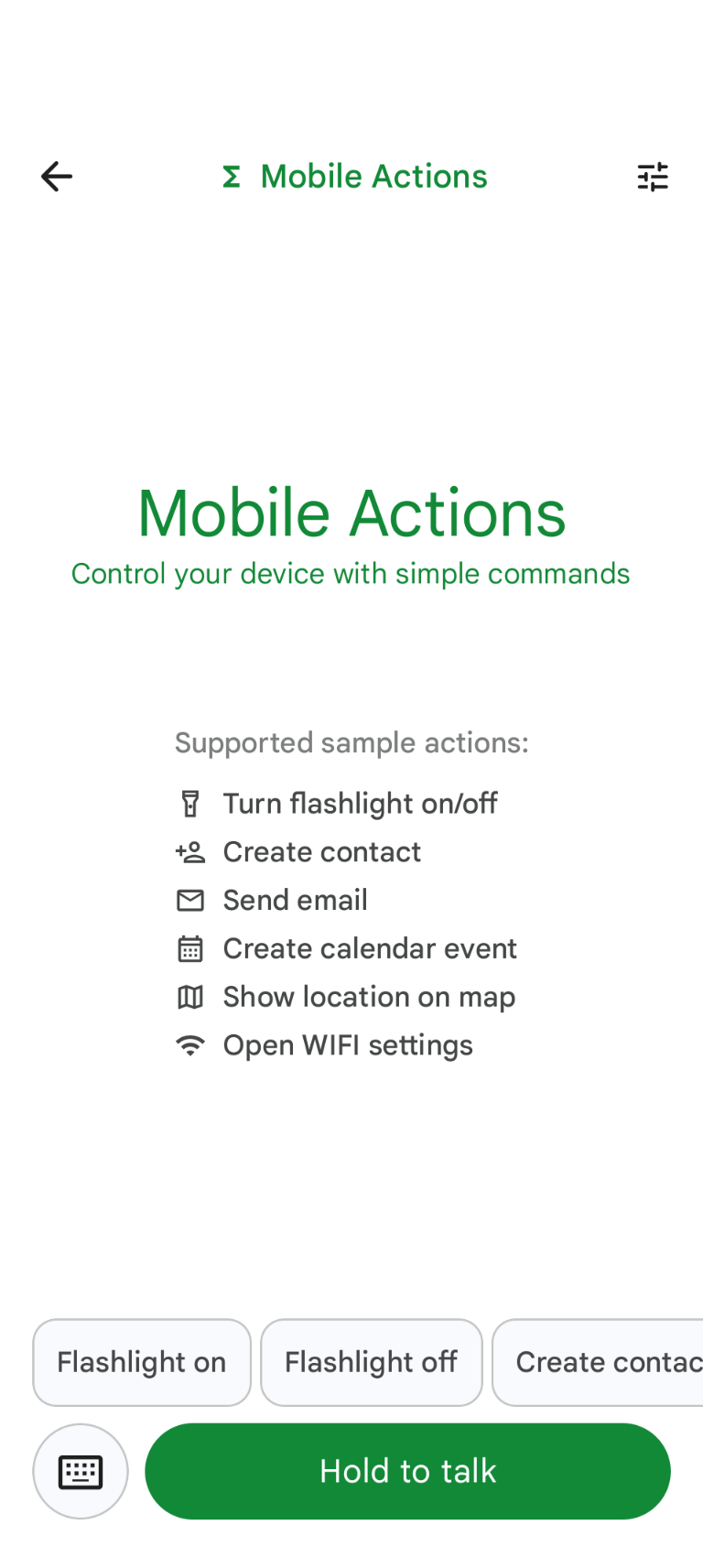

Mobile Actions เป็นแอปเดโมที่ผู้ใช้สามารถเรียกใช้การดำเนินการในอุปกรณ์ จากการป้อนข้อมูลด้วยเสียงหรือข้อความ โดยจะปรับปรุงการโต้ตอบกับ Assistant ให้เป็นความสามารถแบบออฟไลน์อย่างเต็มรูปแบบ ไม่ว่าจะเป็น "สร้างกิจกรรมในปฏิทินสำหรับมื้อเที่ยงพรุ่งนี้" "เพิ่มจอห์น ลงในรายชื่อติดต่อ" หรือ "เปิดไฟฉาย" โมเดลจะแยกวิเคราะห์ภาษาธรรมชาติ และระบุเครื่องมือของระบบปฏิบัติการที่ถูกต้องเพื่อดำเนินการตามคำสั่ง

คู่มือนี้แสดงวิธีการต่อไปนี้

- การปรับแต่งโมเดล FunctionGemma 270M โดยใช้ชุดข้อมูลการดำเนินการบนอุปกรณ์เคลื่อนที่

- การติดตั้งใช้งานโมเดลที่ปรับแต่งแล้วใน Google AI Edge Gallery

คุณจะได้เรียนรู้ตั้งแต่ต้นจนจบ ตั้งแต่การปรับแต่งโมเดลไปจนถึงการนำไปใช้งานในอุปกรณ์

ขั้นตอนที่ 1: ปรับแต่ง FunctionGemma โดยใช้ชุดข้อมูลการดำเนินการบนอุปกรณ์เคลื่อนที่

FunctionGemma เป็นโมเดลที่มีพารามิเตอร์ 270 ล้านรายการซึ่งอิงตามสถาปัตยกรรม Gemma 3 โมเดลนี้ได้รับการฝึกมา โดยเฉพาะสำหรับการเรียกใช้ฟังก์ชัน ซึ่งช่วยให้สามารถแปลคำขอภาษาธรรมชาติ เป็นการเรียกใช้ฟังก์ชันได้

โมเดลนี้มีขนาดเล็กและมีประสิทธิภาพเพียงพอที่จะทำงานบนโทรศัพท์มือถือได้ แต่เช่นเดียวกับโมเดลขนาดนี้ ทั่วไป โมเดลนี้ต้องมีการปรับแต่งเพื่อทำให้เหมาะกับงานที่จะดำเนินการ

เราใช้ชุดข้อมูลการดำเนินการบนอุปกรณ์เคลื่อนที่เพื่อปรับแต่ง FunctionGemma ซึ่ง พร้อมให้บริการแก่สาธารณะบน Hugging Face แต่ละรายการในชุดข้อมูลนี้จะระบุข้อมูลต่อไปนี้

- ชุดเครื่องมือ (ฟังก์ชัน) ที่โมเดลใช้ได้มีดังนี้

- เปิดไฟฉาย

- ปิดไฟฉาย

- สร้างรายชื่อติดต่อในข้อมูลรายชื่อติดต่อของโทรศัพท์

- ส่งอีเมล

- แสดงตำแหน่งบนแผนที่

- เปิดการตั้งค่า Wi-Fi

- สร้างกิจกรรมใหม่ในปฏิทิน

- พรอมต์ของระบบที่ให้บริบท เช่น วันที่และเวลาปัจจุบัน

- พรอมต์ของผู้ใช้ เช่น

turn on the flashlight - คำตอบของโมเดลที่คาดไว้ รวมถึงการเรียกใช้ฟังก์ชันที่เหมาะสม

ฟังก์ชันแสดงแผนที่จะมีลักษณะดังนี้

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

สมุดบันทึก Colab ครอบคลุมขั้นตอนที่จำเป็นทั้งหมด ซึ่งรวมถึง

- การตั้งค่าสภาพแวดล้อม

- การโหลดและการประมวลผลล่วงหน้าของชุดข้อมูลการดำเนินการบนอุปกรณ์เคลื่อนที่

- การปรับแต่งโมเดลโดยใช้ TRL ของ Hugging Face

- แปลงโมเดลเป็นรูปแบบ

.litertlmเพื่อการติดตั้งใช้งาน

ขั้นตอนที่ 2: การติดตั้งใช้งานใน Google AI Edge Gallery

ข้อกำหนดเบื้องต้น: คุณต้องใช้บัญชี Google เดียวกันกับที่ใช้บันทึกไฟล์ .litertlm ในขั้นตอนที่ 1 และลงชื่อเข้าใช้บัญชีดังกล่าวในโทรศัพท์ Android

หลังจากปรับแต่งแล้ว เราจะแปลงและหาปริมาณน้ำหนักของโมเดลเป็นรูปแบบ .litertlm

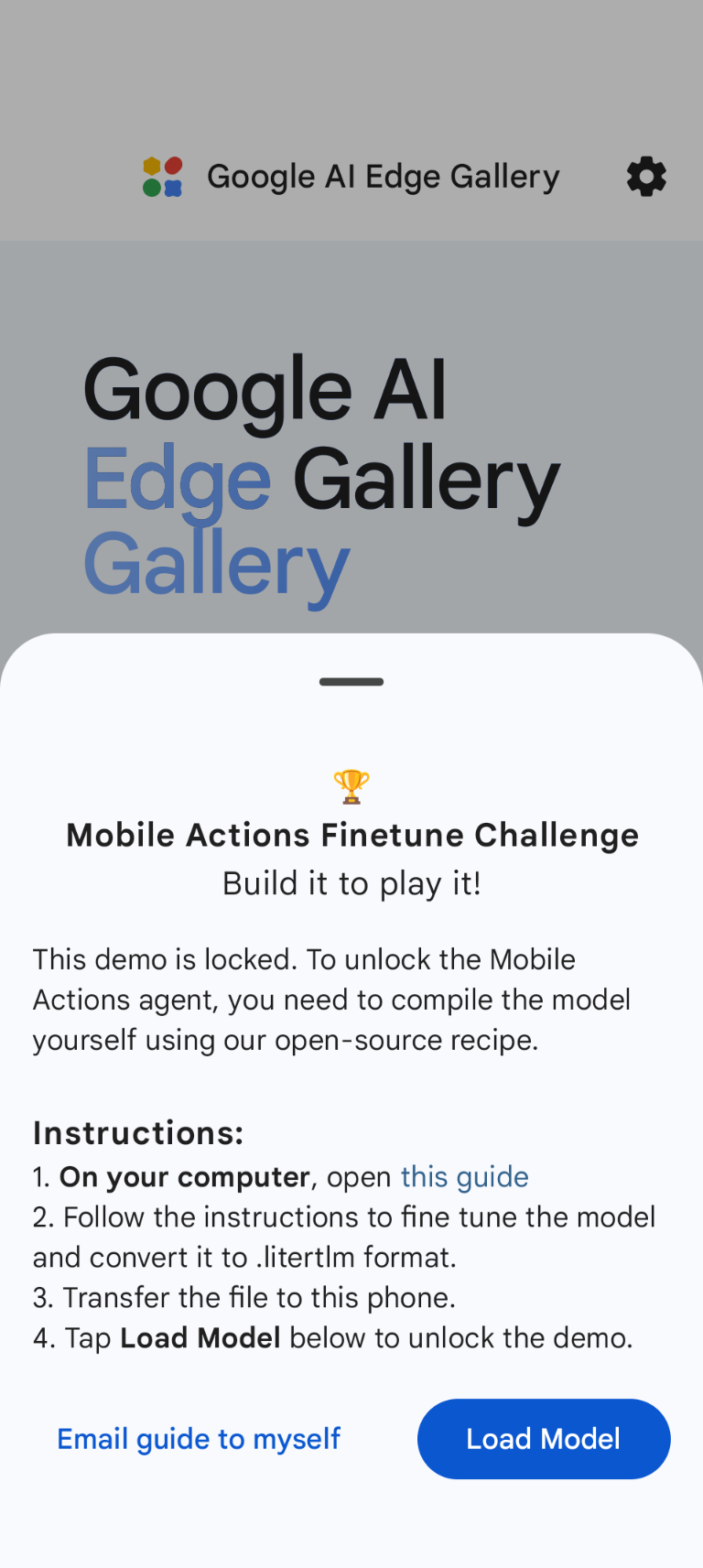

คุณสามารถติดตั้งใช้งานโมเดลในตัวเลือก Google AI Edge Gallery - Mobile Actions

ได้โดยเลือก Load Model แล้วเลือกจาก Google ไดรฟ์ (หรือวิธีการเผยแพร่ทางเลือก

) Google AI Edge Gallery พร้อมให้บริการใน Google Play Store

ตอนนี้คุณสามารถลองใช้คำสั่งเสียงหรือพิมพ์ในแอปเพื่อดูว่าโมเดลที่ปรับแต่งใหม่ของคุณเรียกใช้ฟังก์ชันที่มีอยู่ได้ดีเพียงใด

ขั้นตอนถัดไป

ยินดีด้วย ตอนนี้คุณรู้วิธีปรับแต่งโมเดลด้วย Hugging Face และ นำไปใช้ในอุปกรณ์ด้วย LiteRT-LM แล้ว