Executar no Google Colab Executar no Google Colab

|

Ver código-fonte no GitHub Ver código-fonte no GitHub

|

Visão geral

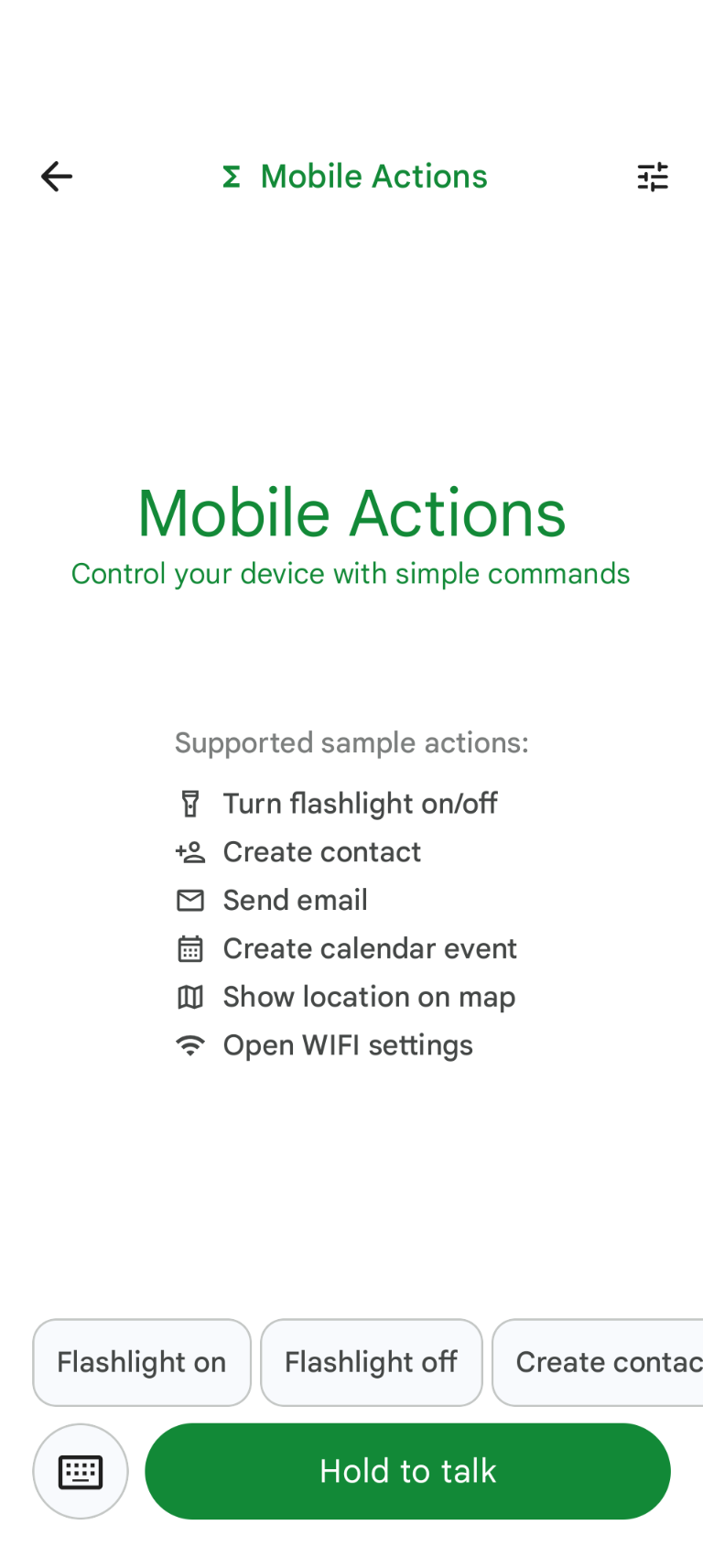

O Mobile Actions é um app de demonstração em que os usuários podem acionar ações no dispositivo com entrada de voz ou texto. Ela reformula a interação com o Google Assistente como uma capacidade totalmente off-line. Seja "Criar um evento de agenda para o almoço de amanhã", "Adicionar João aos meus contatos" ou "Ativar a lanterna", o modelo analisa a linguagem natural e identifica a ferramenta correta do SO para executar o comando.

Neste guia, mostramos como:

- Ajustar o modelo FunctionGemma 270M usando o conjunto de dados Mobile Actions

- Como implantar o modelo personalizado na Galeria do Google AI Edge

Você vai aprender todo o processo, desde o ajuste de um modelo até a implantação dele em um dispositivo.

Etapa 1: ajuste fino da FunctionGemma com o conjunto de dados de ações para dispositivos móveis

O FunctionGemma é um modelo de 270 milhões de parâmetros baseado na arquitetura do Gemma 3. Ele foi treinado especificamente para chamadas de função, o que permite traduzir solicitações em linguagem natural para chamadas de função.

Esse modelo é pequeno e eficiente o suficiente para ser executado em um smartphone, mas, como é comum em modelos desse tamanho, ele precisa de ajuste fino para se especializar na tarefa que vai realizar.

Para ajustar o FunctionGemma, usamos o conjunto de dados de ações para dispositivos móveis, que está disponível publicamente no Hugging Face. Cada entrada neste conjunto de dados fornece:

- O conjunto de ferramentas (funções) que o modelo pode usar:

- Liga a lanterna

- Desliga a lanterna

- Cria um contato na lista de contatos do smartphone.

- Enviar um e-mail

- Mostra um local no mapa

- Abre as configurações de Wi-Fi

- Cria um evento na agenda.

- O comando do sistema que fornece o contexto, como data e hora atuais

- O comando do usuário, como

turn on the flashlight. - A resposta esperada do modelo, incluindo as chamadas de função adequadas.

Confira como a função de mostrar mapa aparece:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

O bloco de notas do Colab abrange todas as etapas necessárias, incluindo:

- Como configurar o ambiente

- Como carregar e pré-processar o conjunto de dados de ações em dispositivos móveis

- Ajustar o modelo usando o TRL do Hugging Face

- Converter o modelo para o formato

.litertlmpara implantação

Etapa 2: implantação na Google AI Edge Gallery

Pré-requisito: você precisa da mesma Conta do Google usada para salvar o arquivo

.litertlm na etapa 1 e fazer login com ela no smartphone Android.

Após o ajuste fino, convertemos e quantizamos os pesos do modelo para o formato .litertlm.

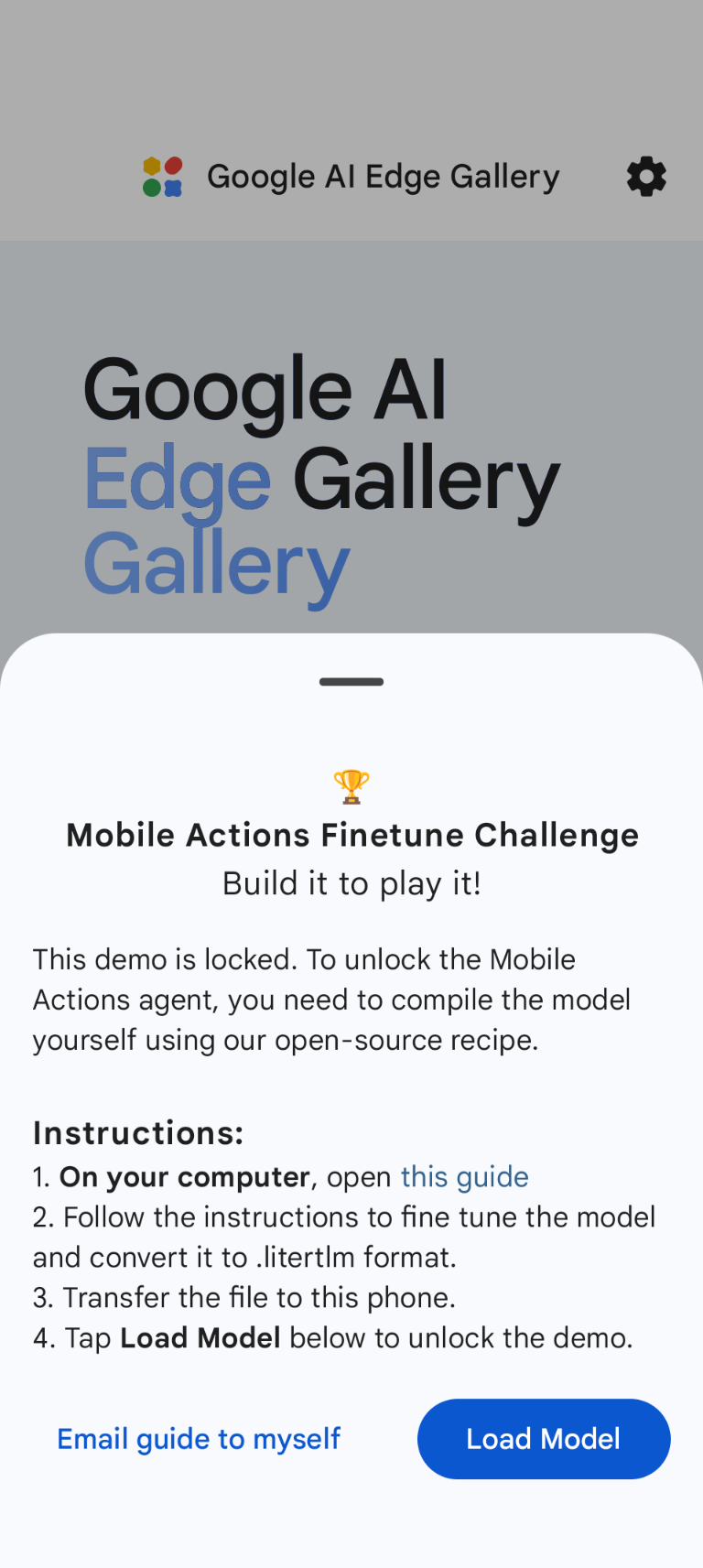

Para implantar o modelo na opção "Google AI Edge Gallery - Mobile Actions", escolha Load Model e selecione no Google Drive (ou outro método de distribuição). A Galeria do Google AI Edge está disponível na Google Play Store.

Agora, tente dar um comando de voz ou digitar no app para ver como o novo modelo refinado se sai ao chamar as funções disponíveis.

Próximas etapas

Parabéns! Agora você sabe como ajustar um modelo com o Hugging Face e implantá-lo no dispositivo com o LiteRT-LM.