نماذج الذكاء الاصطناعي التوليدي هي أدوات فعّالة، ولكنّها تتضمّن بعض القيود. وقد تؤدي تنوّع استخداماتها وإمكانية تطبيقها إلى نتائج غير متوقّعة أحيانًا، مثل نتائج غير دقيقة أو متحيزة أو مسيئة. وتُعدّ المعالجة اللاحقة والتقييم اليدوي الدقيق أمرَين ضروريَين للحدّ من خطر الضرر الناتج عن هذه المخرجات.

يمكن استخدام النماذج التي توفّرها Gemini API في مجموعة متنوعة من تطبيقات الذكاء الاصطناعي التوليدي ومعالجة اللغة الطبيعية. لا يمكن استخدام هذه الوظائف إلا من خلال Gemini API أو تطبيق الويب Google AI Studio، ويخضع استخدامك لواجهة Gemini API أيضًا لسياسة الاستخدام المحظور للذكاء الاصطناعي التوليدي وبنود خدمة Gemini API.

من الأسباب التي تجعل النماذج اللغوية الكبيرة (LLM) مفيدة جدًا أنّها أدوات إبداعية يمكنها معالجة العديد من المهام اللغوية المختلفة. ولكن، يعني ذلك أيضًا أنّ النماذج اللغوية الكبيرة يمكن أن تنشئ ردودًا غير متوقّعة، بما في ذلك نصوص مسيئة أو غير مراعية أو غير صحيحة من الناحية الواقعية. بالإضافة إلى ذلك، إنّ التنوّع المذهل لهذه النماذج هو أيضًا ما يجعل من الصعب التنبؤ بأنواع النتائج غير المرغوب فيها التي قد تنتجها. على الرغم من أنّ واجهة برمجة التطبيقات Gemini API مصمَّمة مع مراعاة مبادئ الذكاء الاصطناعي في Google، تقع مسؤولية تطبيق هذه النماذج بشكل مسؤول على المطوّرين. لمساعدة المطوّرين في إنشاء تطبيقات آمنة ومسؤولة، تتضمّن Gemini API بعض ميزات فلترة المحتوى المدمَجة بالإضافة إلى إعدادات أمان قابلة للتعديل ضمن 4 جوانب من الضرر. لمزيد من المعلومات، يُرجى الرجوع إلى دليل إعدادات الأمان. توفّر أيضًا ميزة Grounding مع تفعيل "بحث Google" لتحسين دقة المعلومات، ولكن يمكن إيقاف هذه الميزة للمطوّرين الذين تتسم حالات استخدامهم بطابع إبداعي أكثر ولا تهدف إلى البحث عن المعلومات.

يهدف هذا المستند إلى تعريفك ببعض مخاطر السلامة التي يمكن أن تنشأ عند استخدام النماذج اللغوية الكبيرة، واقتراح توصيات ناشئة بشأن تصميم السلامة وتطويرها. (يُرجى العِلم أنّ القوانين واللوائح التنظيمية قد تفرض أيضًا قيودًا، ولكنّ هذه الاعتبارات خارج نطاق هذا الدليل).

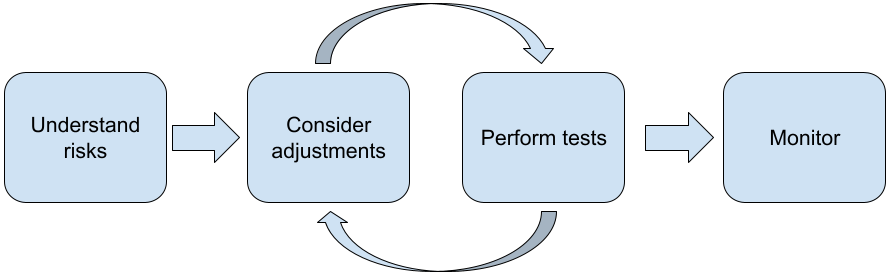

يُنصح باتّباع الخطوات التالية عند إنشاء تطبيقات باستخدام نماذج اللغات الكبيرة:

- فهم مخاطر الأمان في تطبيقك

- مراعاة إجراء تعديلات للحدّ من مخاطر السلامة

- إجراء اختبارات السلامة المناسبة لحالة الاستخدام

- طلب ملاحظات من المستخدمين وتتبُّع الاستخدام

يجب أن تكون مرحلتا التعديل والاختبار متكرّرتين إلى أن تصل إلى مستوى أداء مناسب لتطبيقك.

فهم مخاطر الأمان في تطبيقك

في هذا السياق، يتم تعريف الأمان على أنّه قدرة نموذج لغوي كبير على تجنُّب التسبّب في ضرر للمستخدمين، مثلاً من خلال إنشاء لغة سامة أو محتوى يروّج للصورة النمطية. تم تصميم النماذج المتاحة من خلال Gemini API مع مراعاة مبادئ الذكاء الاصطناعي من Google، ويخضع استخدامك لها لسياسة الاستخدام المحظور للذكاء الاصطناعي التوليدي. توفر واجهة برمجة التطبيقات فلاتر أمان مضمّنة للمساعدة في معالجة بعض المشاكل الشائعة في النماذج اللغوية، مثل اللغة المسيئة وخطاب الكراهية، والسعي إلى تحقيق الشمولية وتجنُّب الصور النمطية. ومع ذلك، يمكن أن يشكّل كل تطبيق مجموعة مختلفة من المخاطر على مستخدميه. لذلك، بصفتك مالك التطبيق، تقع على عاتقك مسؤولية معرفة المستخدمين والأضرار المحتملة التي قد يتسبب بها تطبيقك، وضمان استخدام تطبيقك للنماذج اللغوية الكبيرة (LLM) بأمان ومسؤولية.

وكجزء من هذا التقييم، يجب مراعاة احتمالية حدوث ضرر وتحديد مدى خطورته وخطوات الحدّ منه. على سبيل المثال، يجب أن يكون التطبيق الذي ينشئ مقالات استنادًا إلى أحداث واقعية أكثر حذرًا بشأن تجنُّب المعلومات الخاطئة، مقارنةً بالتطبيق الذي ينشئ قصصًا خيالية بغرض الترفيه. من الطرق الجيدة لبدء استكشاف المخاطر المحتملة على السلامة إجراء بحث عن المستخدمين النهائيين وغيرهم من الأشخاص الذين قد يتأثرون بنتائج تطبيقك. ويمكن أن يتخذ ذلك أشكالاً عديدة، بما في ذلك البحث عن أحدث الدراسات في مجال تطبيقك، أو مراقبة كيفية استخدام الأشخاص لتطبيقات مشابهة، أو إجراء دراسة أو استطلاع للمستخدمين أو إجراء مقابلات غير رسمية مع المستخدمين المحتملين.

نصائح متقدمة

- تحدَّث مع مجموعة متنوعة من المستخدمين المحتملين ضمن الجمهور المستهدَف بشأن تطبيقك والغرض المقصود منه، وذلك للحصول على منظور أوسع بشأن المخاطر المحتملة وتعديل معايير التنوّع حسب الحاجة.

- يقدّم إطار عمل إدارة مخاطر الذكاء الاصطناعي الذي أصدره المعهد الوطني للمعايير والتكنولوجيا (NIST) التابع للحكومة الأمريكية إرشادات أكثر تفصيلاً ومراجع تعليمية إضافية بشأن إدارة مخاطر الذكاء الاصطناعي.

- تصف ورقة DeepMind المنشورة حول المخاطر الأخلاقية والاجتماعية للضرر الناتج عن النماذج اللغوية بالتفصيل الطرق التي يمكن أن تتسبّب بها تطبيقات النماذج اللغوية في إلحاق الضرر.

التفكير في إجراء تعديلات للحدّ من المخاطر المتعلّقة بالأمان والدقة

بعد أن فهمت المخاطر، يمكنك تحديد كيفية التخفيف من حدّتها. يُعدّ تحديد المخاطر التي يجب منحها الأولوية والمقدار الذي يجب بذله لمحاولة تجنُّبها قرارًا مهمًا، تمامًا مثل تحديد أولويات الأخطاء في مشروع برمجي. بعد تحديد الأولويات، يمكنك البدء في التفكير في أنواع إجراءات التخفيف التي ستكون الأنسب. في كثير من الأحيان، يمكن أن تحدث تغييرات بسيطة فرقًا وتحدّ من المخاطر.

على سبيل المثال، عند تصميم تطبيق، يجب مراعاة ما يلي:

- ضبط نتائج النموذج لتعكس بشكل أفضل ما هو مقبول في سياق تطبيقك يمكن أن يؤدي الضبط إلى جعل ناتج النموذج أكثر قابلية للتوقّع واتساقًا، وبالتالي يمكن أن يساعد في الحدّ من مخاطر معيّنة.

- توفير طريقة إدخال تسهّل الحصول على نتائج أكثر أمانًا يمكن أن يؤثر الإدخال الدقيق الذي تقدّمه إلى نموذج لغوي كبير في جودة الناتج. ننصحك بتجربة طلبات الإدخال للعثور على ما يناسب حالة الاستخدام بأمان، لأنّ ذلك سيساعدك في توفير تجربة مستخدم تسهّل ذلك. على سبيل المثال، يمكنك حصر خيارات المستخدمين في قائمة منسدلة تتضمّن طلبات إدخال، أو تقديم اقتراحات منبثقة تتضمّن عبارات وصفية تبيّن أنّها آمنة في سياق تطبيقك.

حظر المدخلات غير الآمنة وفلترة المخرجات قبل عرضها على المستخدم في الحالات البسيطة، يمكن استخدام قوائم الحظر لتحديد الكلمات أو العبارات غير الآمنة وحظرها في الطلبات أو الردود، أو مطالبة المراجعين بتعديل هذا المحتوى أو حظره يدويًا.

استخدام مصنّفات مدرَّبة لتصنيف كل طلب استنادًا إلى الأضرار المحتملة أو الإشارات العدائية ويمكن بعد ذلك اتّباع استراتيجيات مختلفة بشأن كيفية التعامل مع الطلب استنادًا إلى نوع الضرر الذي تم رصده. على سبيل المثال، إذا كان الإدخال عدائيًا أو مسيئًا بشكل واضح، قد يتم حظره وعرض ردّ مكتوب مسبقًا بدلاً منه.

نصيحة متقدّمة

-

إذا أشارت الإشارات إلى أنّ الناتج ضار، يمكن للتطبيق استخدام الخيارات التالية:

- قدِّم رسالة خطأ أو ناتجًا مكتوبًا مسبقًا.

- يُرجى إعادة إدخال الطلب، فقد يتم إنشاء نتيجة آمنة بديلة، لأنّ الطلب نفسه قد يؤدي أحيانًا إلى نتائج مختلفة.

-

إذا أشارت الإشارات إلى أنّ الناتج ضار، يمكن للتطبيق استخدام الخيارات التالية:

وضع ضمانات للحماية من إساءة الاستخدام المتعمد، مثل تخصيص معرّف فريد لكل مستخدم وفرض حدّ على عدد طلبات البحث التي يمكن للمستخدم إرسالها خلال فترة زمنية محدّدة إجراء وقائي آخر هو محاولة الحماية من عمليات حقن الطلبات المحتملة. إنّ هجوم حقن الطلبات، مثل هجوم حقن SQL، هو طريقة يستخدمها المستخدمون الضارون لتصميم طلب إدخال يتلاعب بنتيجة النموذج، مثلاً عن طريق إرسال طلب إدخال يطلب من النموذج تجاهل أي أمثلة سابقة. يُرجى الاطّلاع على سياسة الاستخدام المحظور للذكاء الاصطناعي التوليدي للحصول على تفاصيل حول إساءة الاستخدام المتعمدة.

تعديل الوظائف إلى شيء أقل خطورة بطبيعته أما المهام التي تكون محدودة النطاق (مثل استخراج الكلمات الرئيسية من فقرات نصية) أو التي تتطلّب إشرافًا بشريًا أكبر (مثل إنشاء محتوى قصير ستتم مراجعته من قِبل شخص)، فغالبًا ما تشكّل خطرًا أقل. على سبيل المثال، بدلاً من إنشاء تطبيق لكتابة ردّ على رسالة إلكترونية من البداية، يمكنك بدلاً من ذلك حصر استخدامه في توسيع مخطط أو اقتراح صياغات بديلة.

تعديل إعدادات أمان المحتوى الضار لتقليل احتمال ظهور ردود قد تكون ضارة توفّر Gemini API إعدادات أمان يمكنك تعديلها خلال مرحلة إنشاء النموذج الأولي لتحديد ما إذا كان تطبيقك يتطلّب إعدادات أمان أكثر أو أقل تقييدًا. يمكنك تعديل هذه الإعدادات ضمن خمس فئات فلاتر لتقييد أنواع معيّنة من المحتوى أو السماح بها. راجِع دليل إعدادات الأمان للتعرّف على إعدادات الأمان القابلة للتعديل المتاحة من خلال Gemini API.

الحدّ من الأخطاء المحتملة في الوقائع أو الهلوسات من خلال تفعيل ميزة الاستناد إلى معلومات من "بحث Google" يُرجى العِلم أنّ العديد من نماذج الذكاء الاصطناعي لا تزال في مرحلة تجريبية، وقد تقدّم معلومات غير دقيقة من الناحية الواقعية أو تهلوس أو تقدّم نتائج أخرى غير ملائمة. تربط ميزة "تحديد مصدر المعلومات الخاصة بـ "بحث Google"" نموذج Gemini بمحتوى الويب في الوقت الفعلي، وتعمل مع جميع اللغات المتاحة. يتيح ذلك لـ Gemini تقديم إجابات أكثر دقة والاستشهاد بمصادر يمكن التحقّق منها تتجاوز تاريخ آخر تحديث للنموذج.

إجراء اختبارات السلامة المناسبة لحالة الاستخدام

يُعدّ الاختبار جزءًا أساسيًا من عملية إنشاء تطبيقات قوية وآمنة، ولكن سيختلف مدى الاختبار ونطاقه واستراتيجياته. على سبيل المثال، من المرجّح أن يشكّل مولّد قصائد الهايكو الذي يهدف إلى الترفيه مخاطر أقل حدة من تطبيق مصمّم لاستخدامه من قِبل شركات المحاماة لتلخيص المستندات القانونية والمساعدة في صياغة العقود. لكن قد يستخدم أداة إنشاء قصائد الهايكو مجموعة أكبر من المستخدمين، ما يعني أنّ احتمال حدوث محاولات معادية أو حتى إدخالات ضارة غير مقصودة قد يكون أكبر. يُعدّ سياق التنفيذ مهمًا أيضًا. على سبيل المثال، قد يُعتبَر تطبيق تتم مراجعة نتائجه من قِبل خبراء بشريين قبل اتخاذ أي إجراء أقل عرضة لإنتاج نتائج ضارة من التطبيق المطابق الذي لا يخضع لمثل هذه الرقابة.

من الشائع إجراء عدة تكرارات لإجراء التغييرات والاختبار قبل الشعور بالثقة بأنّك جاهز لإطلاق التطبيق، حتى بالنسبة إلى التطبيقات التي تنطوي على مخاطر منخفضة نسبيًا. هناك نوعان من الاختبارات مفيدان بشكل خاص لتطبيقات الذكاء الاصطناعي، وهما:

تتضمّن مقاييس الأمان تصميم مقاييس أمان تعكس الطرق التي يمكن أن يكون بها تطبيقك غير آمن في سياق كيفية استخدامه على الأرجح، ثم اختبار مدى جودة أداء تطبيقك في المقاييس باستخدام مجموعات بيانات التقييم. من الممارسات الجيدة التفكير في الحد الأدنى المقبول لمستويات مقاييس السلامة قبل إجراء الاختبار، وذلك حتى تتمكّن من 1) تقييم نتائج الاختبار مقارنةً بهذه التوقعات، و2) جمع مجموعة بيانات التقييم استنادًا إلى الاختبارات التي تقيّم المقاييس التي تهمّك أكثر.

نصائح متقدمة

- يجب الحذر من الاعتماد بشكل مفرط على الأساليب الجاهزة، لأنّه من المحتمل أن تحتاج إلى إنشاء مجموعات بيانات اختبار خاصة بك باستخدام مقيّمين بشريين لتناسب سياق تطبيقك بشكل كامل.

- إذا كان لديك أكثر من مقياس واحد، عليك تحديد كيفية الموازنة بينها إذا أدّى تغيير إلى تحسين أحد المقاييس على حساب مقياس آخر. كما هو الحال مع هندسة الأداء الأخرى، قد تحتاج إلى التركيز على أسوأ أداء في مجموعة التقييم بدلاً من متوسط الأداء.

يتضمّن الاختبار الخصومي محاولة إيقاف تطبيقك بشكل استباقي. والهدف من ذلك هو تحديد نقاط الضعف حتى تتمكّن من اتخاذ الخطوات المناسبة لمعالجتها. قد يستغرق اختبار التنافس وقتًا وجهدًا كبيرَين من المقيمين الخبراء في تطبيقك، ولكن كلما أجريت المزيد من الاختبارات، زادت فرصتك في رصد المشاكل، خاصةً تلك التي تحدث نادرًا أو بعد تشغيل التطبيق بشكل متكرر.

- الاختبار الخصومي هو طريقة لتقييم نموذج تعلّم آلي بشكل منهجي بهدف معرفة سلوكه عند تزويده بمدخلات ضارة أو مؤذية عن غير قصد:

- قد يكون الإدخال ضارًا عندما يكون مصمّمًا بشكل واضح لإنتاج ناتج غير آمن أو مؤذٍ، مثل الطلب من نموذج لإنشاء النصوص أن ينشئ نصًا يتضمّن عبارات كراهية حول دين معيّن.

- يكون الإدخال ضارًا عن غير قصد عندما يكون الإدخال نفسه غير مؤذٍ، ولكنّه ينتج عنه مخرجات ضارة، مثل الطلب من نموذج لإنشاء النصوص وصف شخص من عرق معيّن وتلقّي مخرجات عنصرية.

- ما يميّز الاختبار الخصومي عن التقييم العادي هو تركيبة البيانات المستخدَمة في الاختبار. بالنسبة إلى الاختبارات الخصومية، اختَر بيانات الاختبار التي من المرجّح أن تؤدي إلى إخراج إشكالي من النموذج. ويعني ذلك اختبار سلوك النموذج لرصد جميع أنواع الأضرار المحتملة، بما في ذلك الأمثلة النادرة أو غير العادية والحالات الحدّية ذات الصلة بسياسات الأمان. ويجب أن يشمل أيضًا تنوّعًا في الأبعاد المختلفة للجملة، مثل البنية والمعنى والطول. يمكنك الرجوع إلى ممارسات الذكاء الاصطناعي المسؤول في Google

في ما يتعلق

بالإنصاف

للاطّلاع على مزيد من التفاصيل حول الاعتبارات التي يجب أخذها في الحسبان عند إنشاء مجموعة بيانات اختبارية.

نصائح متقدمة

- استخدِم الاختبار الآلي بدلاً من الطريقة التقليدية المتمثلة في الاستعانة بفِرق اختبارية لمحاولة إيقاف تطبيقك. في الاختبارات الآلية، يكون "الفريق الأحمر" نموذج لغة آخر يعثر على نص إدخال يؤدي إلى إخراج نتائج ضارة من النموذج الذي يتم اختباره.

- الاختبار الخصومي هو طريقة لتقييم نموذج تعلّم آلي بشكل منهجي بهدف معرفة سلوكه عند تزويده بمدخلات ضارة أو مؤذية عن غير قصد:

مراقبة المشاكل

مهما أجريت من اختبارات وخفّفت من المشاكل، لا يمكنك ضمان عدم حدوثها، لذا عليك التخطيط مسبقًا لكيفية رصد المشاكل التي قد تحدث والتعامل معها. تشمل الأساليب الشائعة إعداد قناة خاضعة للمراقبة ليشارك المستخدمون ملاحظاتهم (مثل التقييم بنعم أو لا) وإجراء دراسة حول سلوك المستخدمين للحصول على ملاحظات بشكل استباقي من مجموعة متنوعة من المستخدمين، وهو أمر مفيد بشكل خاص إذا كانت أنماط الاستخدام مختلفة عن التوقعات.

نصائح متقدمة

- عندما يقدّم المستخدمون ملاحظات حول منتجات الذكاء الاصطناعي، يمكن أن يؤدي ذلك إلى تحسين أداء الذكاء الاصطناعي وتجربة المستخدم بشكل كبير بمرور الوقت، مثلاً، من خلال مساعدتك في اختيار أمثلة أفضل لتحسين الطلبات. يقدّم فصل "الملاحظات والتحكّم" في دليل "الأشخاص والذكاء الاصطناعي" من Google اعتبارات أساسية يجب أخذها في الحسبان عند تصميم آليات تلقّي الملاحظات.

الخطوات التالية

- راجِع دليل إعدادات الأمان للتعرّف على إعدادات الأمان القابلة للتعديل والمتاحة من خلال Gemini API.

- راجِع مقدمة حول كتابة الطلبات للبدء في كتابة طلباتك الأولى.