In Google Colab ausführen In Google Colab ausführen

|

Quelle auf GitHub ansehen Quelle auf GitHub ansehen

|

Übersicht

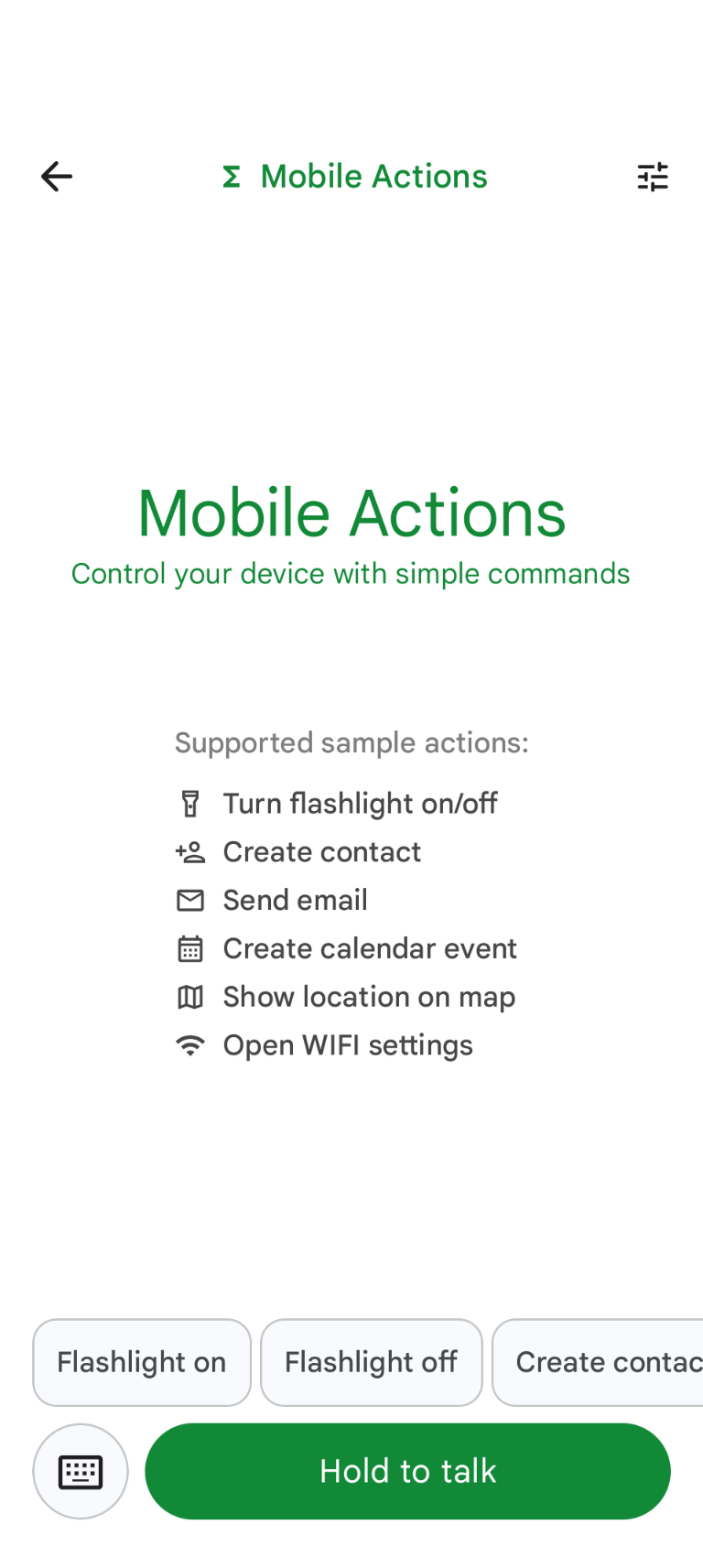

Mobile Actions ist eine Demo-App, mit der Nutzer Aktionen auf ihrem Gerät per Sprach- oder Texteingabe auslösen können. Die Interaktion mit dem Assistenten wird als reine Offline-Funktion neu konzipiert. Ob „Erstelle einen Kalendertermin für das Mittagessen morgen“, „Füge John zu meinen Kontakten hinzu“ oder „Schalte die Taschenlampe ein“ – das Modell analysiert die natürliche Sprache und ermittelt das richtige Betriebssystemtool, um den Befehl auszuführen.

In diesem Leitfaden erfahren Sie, wie Sie:

- FunctionGemma 270M-Modell mit dem Mobile Actions-Dataset abstimmen

- Bereitstellung des angepassten Modells in der Google AI Edge-Galerie

Sie können den gesamten Prozess von der Feinabstimmung eines Modells bis zur Bereitstellung auf einem Gerät kennenlernen.

Schritt 1: FunctionGemma mit dem Mobile Actions Dataset abstimmen

FunctionGemma ist ein Modell mit 270 Millionen Parametern, das auf der Gemma 3-Architektur basiert. Das Modell wurde speziell für Funktionsaufrufe trainiert und kann Anfragen in natürlicher Sprache in Funktionsaufrufe umwandeln.

Dieses Modell ist klein und effizient genug, um auf einem Smartphone ausgeführt zu werden. Wie bei Modellen dieser Größe üblich, muss es jedoch feinabgestimmt werden, um es für die jeweilige Aufgabe zu optimieren.

Zum Feinabstimmen von FunctionGemma verwenden wir das Mobile Actions-Dataset, das auf Hugging Face öffentlich verfügbar ist. Jeder Eintrag in diesem Dataset enthält Folgendes:

- Die Tools (Funktionen), die das Modell verwenden kann:

- Schaltet die Taschenlampe ein

- Schaltet die Taschenlampe aus

- Erstellt einen Kontakt in der Kontaktliste des Smartphones

- Eine E‑Mail wird gesendet

- Zeigt einen Ort auf der Karte an

- Öffnet die WLAN-Einstellungen

- Einen neuen Kalendertermin erstellen

- Der Systemprompt, der den Kontext wie das aktuelle Datum und die aktuelle Uhrzeit enthält

- Der Nutzer-Prompt, z. B.

turn on the flashlight. - Die erwartete Modellantwort, einschließlich der entsprechenden Funktionsaufrufe.

So sieht die Funktion „Karte anzeigen“ aus:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

Das Colab-Notebook enthält alle erforderlichen Schritte, darunter:

- Umgebung einrichten

- Mobile Actions-Dataset laden und vorverarbeiten

- Modell mit Hugging Face TRL abstimmen

- Modell für die Bereitstellung in das

.litertlm-Format konvertieren

Schritt 2: Bereitstellung in der Google AI Edge-Galerie

Voraussetzung: Sie benötigen das Google-Konto, mit dem Sie die Datei .litertlm in Schritt 1 gespeichert haben, und müssen damit auf Ihrem Android-Smartphone angemeldet sein.

Nach dem Fine-Tuning konvertieren und quantisieren wir die Modellgewichte in das .litertlm-Format.

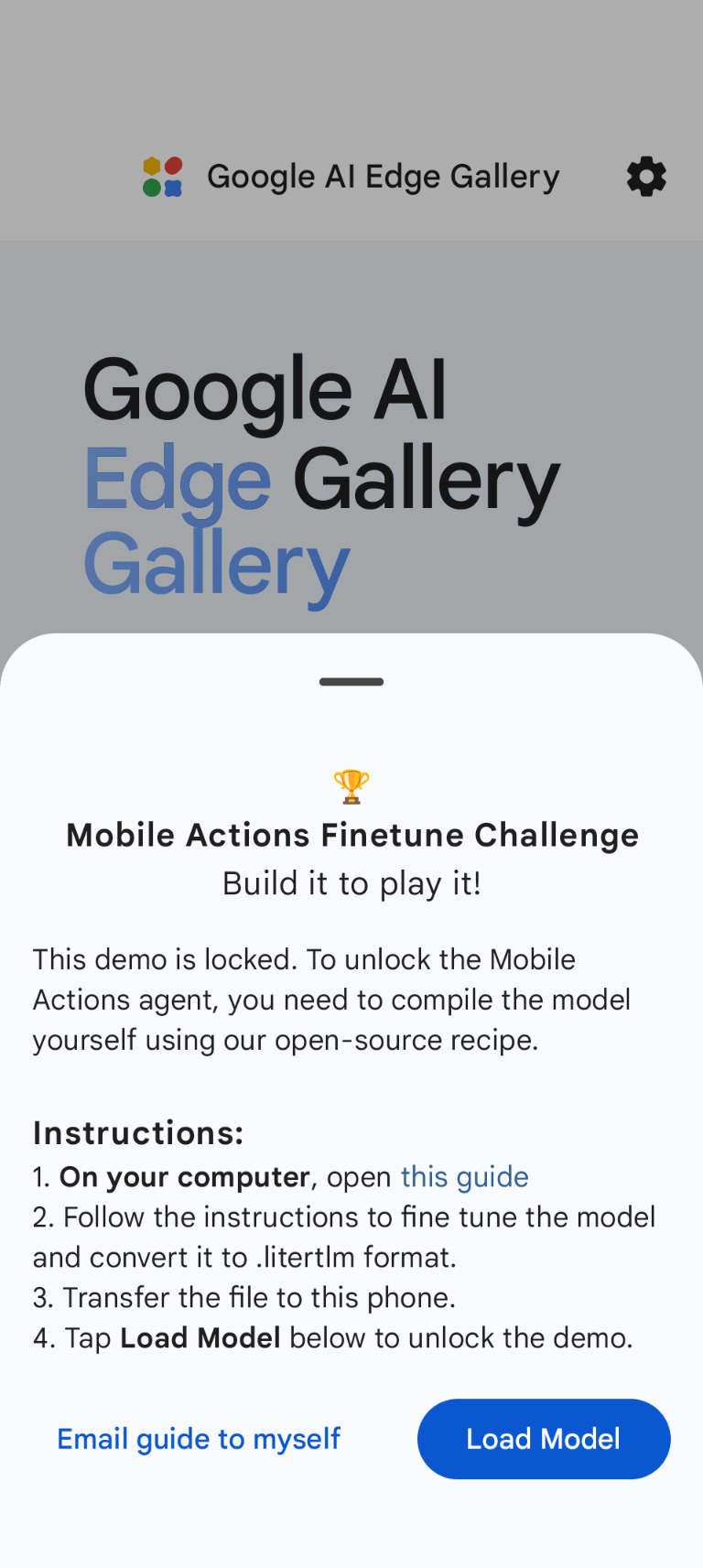

Sie können das Modell in der Google AI Edge Gallery-Option „Mobile Actions“ bereitstellen, indem Sie Load Model auswählen und das Modell aus Google Drive (oder einer alternativen Verteilungsmethode) auswählen. Die Google AI Edge-Galerie ist im Google Play Store verfügbar.

Sie können jetzt einen Sprachbefehl geben oder in der App tippen, um zu sehen, wie gut Ihr neues, feinabgestimmtes Modell die ihm zur Verfügung stehenden Funktionen aufruft.

Nächste Schritte

Glückwunsch! Sie wissen jetzt, wie Sie ein Modell mit Hugging Face optimieren und mit LiteRT-LM auf dem Gerät bereitstellen.