Ejecutar en Google Colab Ejecutar en Google Colab

|

Ver el código fuente en GitHub Ver el código fuente en GitHub

|

Descripción general

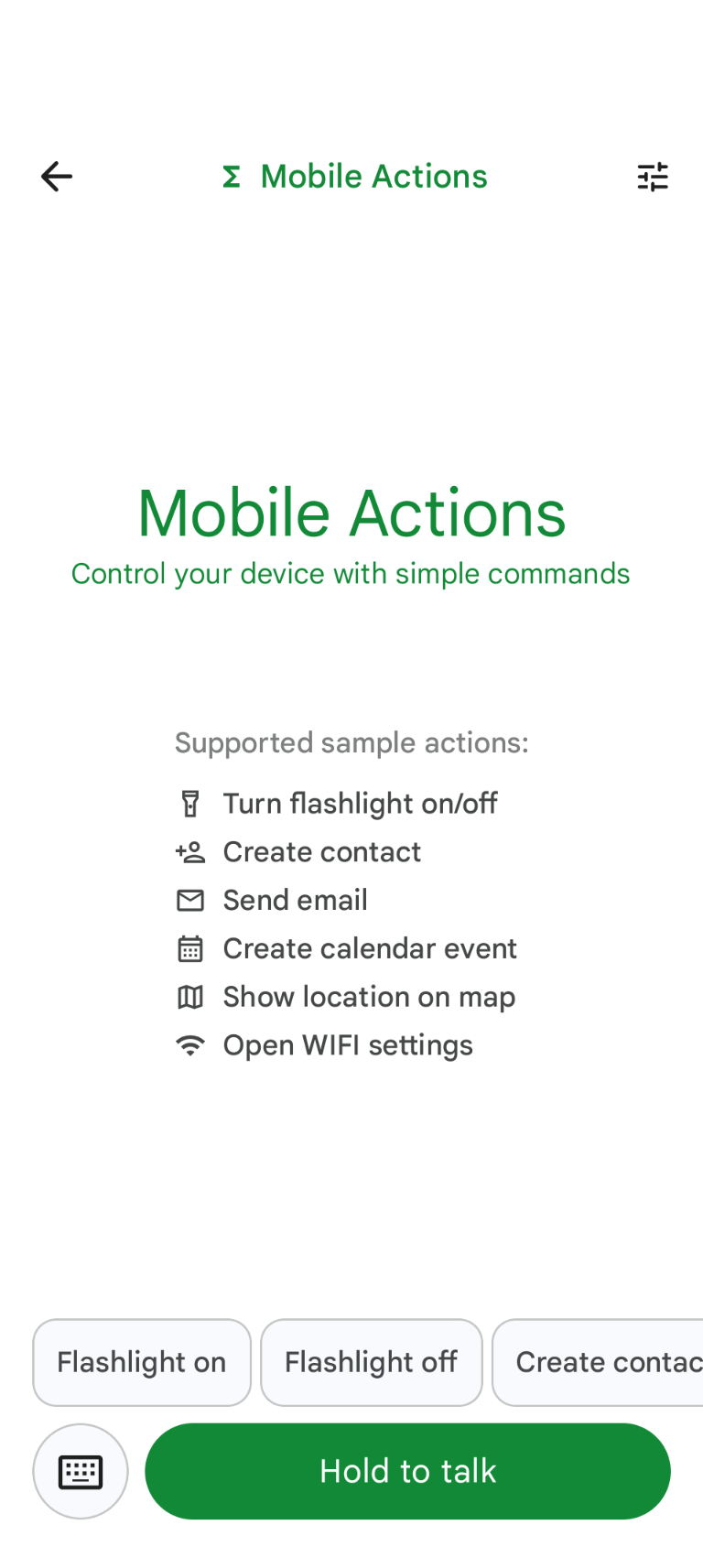

Mobile Actions es una app de demostración en la que los usuarios pueden activar acciones en su dispositivo a partir de entradas de voz o texto. Reimagina la interacción con el asistente como una capacidad completamente sin conexión. Ya sea "Crea un evento de calendario para el almuerzo de mañana", "Agrega a Juan a mis contactos" o "Enciende la linterna", el modelo analiza el lenguaje natural y, luego, identifica la herramienta del SO correcta para ejecutar el comando.

En esta guía, se indica cómo realizar las siguientes acciones:

- Ajuste del modelo FunctionGemma 270M con el conjunto de datos de Mobile Actions

- Implementación del modelo personalizado en la Galería de Google AI Edge

Podrás aprender de extremo a extremo, desde el ajuste detallado de un modelo hasta su implementación en el dispositivo.

Paso 1: Ajusta FunctionGemma con el conjunto de datos de Mobile Actions

FunctionGemma es un modelo de 270 millones de parámetros basado en la arquitectura de Gemma 3. Se entrenó específicamente para las llamadas a funciones, lo que le permite traducir solicitudes en lenguaje natural a llamadas a funciones.

Este modelo es lo suficientemente pequeño y eficiente como para ejecutarse en un teléfono celular, pero, como es común en los modelos de este tamaño, requiere un ajuste para especializarlo en la tarea que realizará.

Para ajustar FunctionGemma, usamos el conjunto de datos de Mobile Actions, que está disponible públicamente en Hugging Face. Cada entrada de este conjunto de datos proporciona lo siguiente:

- Conjunto de herramientas (funciones) que puede usar el modelo:

- Enciende la linterna.

- Apaga la linterna.

- Crea un contacto en la lista de contactos del teléfono.

- Envía un correo electrónico

- Muestra una ubicación en el mapa

- Abre la configuración de Wi-Fi.

- Crea un evento de calendario nuevo

- La instrucción del sistema que proporciona el contexto, como la fecha y la hora actuales

- Es la instrucción del usuario, como

turn on the flashlight. - La respuesta esperada del modelo, incluidas las llamadas a función adecuadas.

Así se ve la función para mostrar el mapa:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

El notebook de Colab abarca todos los pasos necesarios, incluidos los siguientes:

- Configura el entorno

- Carga y procesamiento previo del conjunto de datos de Mobile Actions

- Ajuste del modelo con Hugging Face TRL

- Cómo convertir el modelo al formato

.litertlmpara la implementación

Paso 2: Implementación en Google AI Edge Gallery

Requisito previo: Necesitas la misma Cuenta de Google que usaste para guardar el archivo .litertlm en el paso 1 y acceder a ella en tu teléfono Android.

Después del ajuste, convertimos y cuantificamos los pesos del modelo al formato .litertlm.

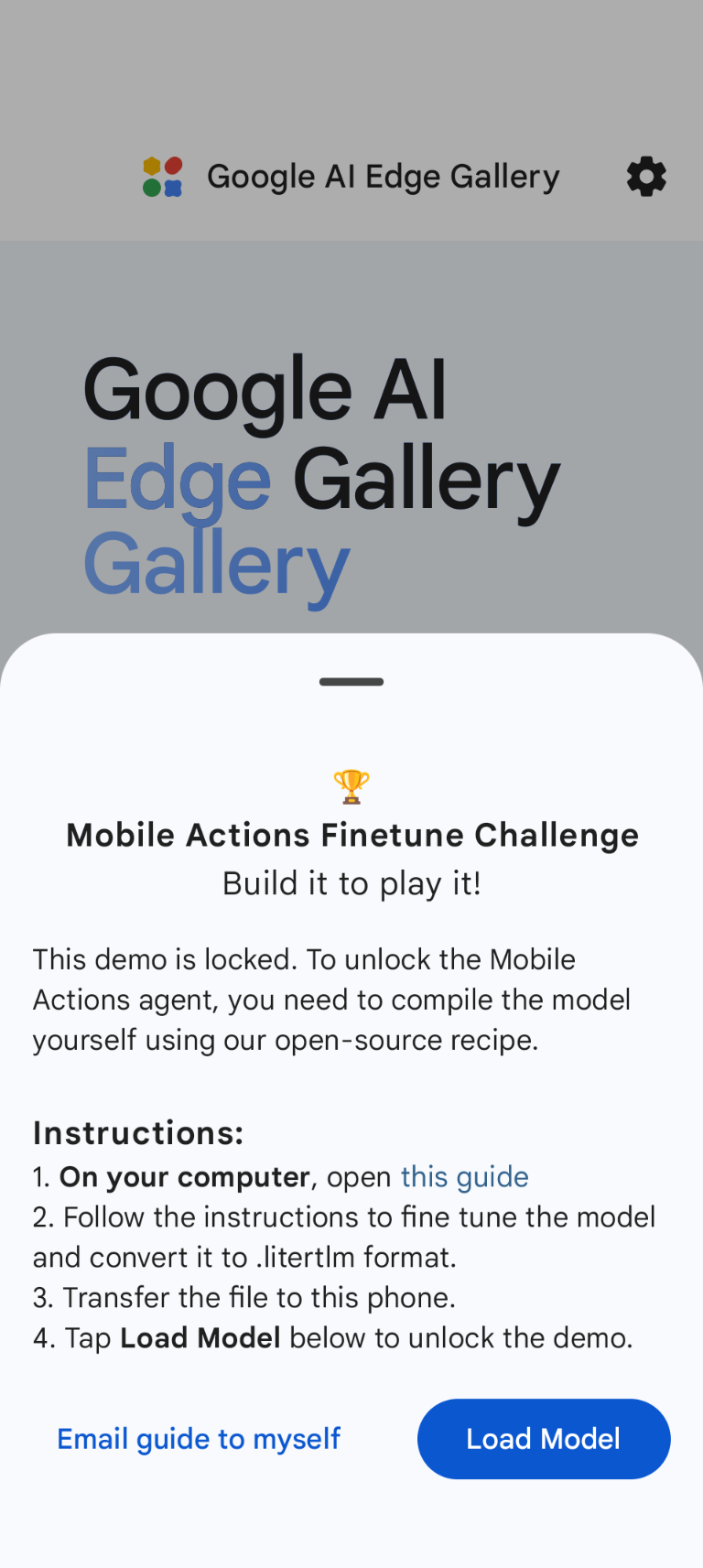

Para implementar el modelo en la opción Google AI Edge Gallery - Mobile Actions, elige Load Model y selecciónalo desde tu unidad de Google Drive (o cualquier otro método de distribución). La Galería de Google AI Edge está disponible en Google Play Store.

Ahora, puedes intentar dar un comando de voz o escribir en la app para ver qué tan bien funciona tu nuevo modelo ajustado cuando llama a las funciones disponibles.

Próximos pasos

¡Felicitaciones! Ahora sabes cómo ajustar un modelo con Hugging Face y, luego, implementarlo en el dispositivo con LiteRT-LM.