Jalankan di Google Colab Jalankan di Google Colab

|

Lihat sumber di GitHub Lihat sumber di GitHub

|

Ringkasan

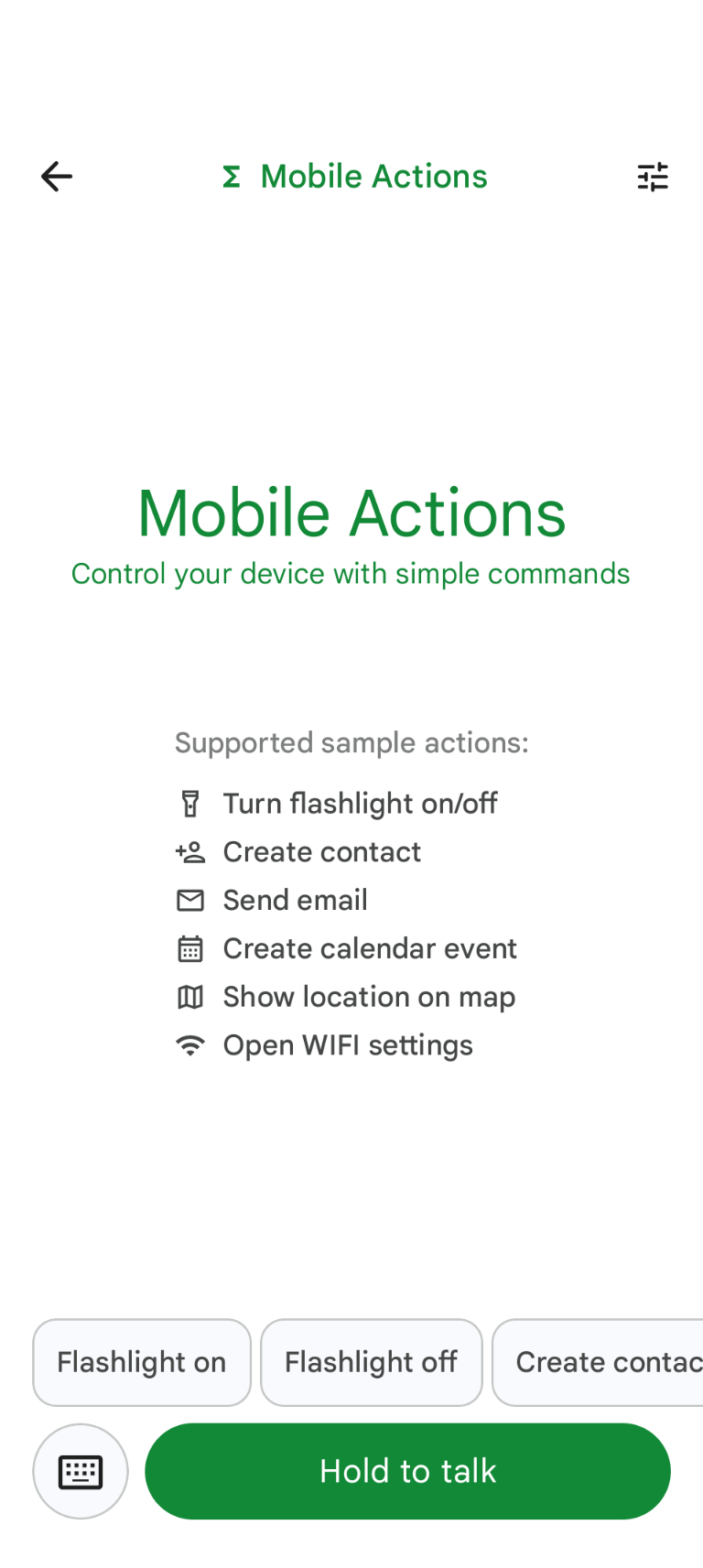

Mobile Actions adalah aplikasi demo tempat pengguna dapat memicu tindakan di perangkat mereka dari input suara atau teks. Fitur ini membayangkan ulang interaksi asisten sebagai kemampuan yang sepenuhnya offline. Baik itu "Buat acara kalender untuk makan siang besok", "Tambahkan John ke kontak saya", atau "Aktifkan senter", model akan mengurai bahasa alami dan mengidentifikasi alat OS yang tepat untuk menjalankan perintah.

Panduan ini menunjukkan cara:

- Menyesuaikan model FunctionGemma 270M menggunakan set data Mobile Actions

- Men-deploy model yang disesuaikan ke Google AI Edge Gallery

Anda akan dapat mempelajari proses end-to-end mulai dari melakukan fine-tuning model hingga men-deploy-nya di perangkat.

Langkah 1: Menyesuaikan FunctionGemma dengan Dataset Tindakan Seluler

FunctionGemma adalah model parameter 270 juta berdasarkan arsitektur Gemma 3. Model ini telah dilatih secara khusus untuk panggilan fungsi, sehingga dapat menerjemahkan permintaan bahasa alami menjadi panggilan fungsi.

Model ini cukup kecil dan efisien untuk dijalankan di ponsel, tetapi seperti model berukuran serupa, model ini memerlukan penyesuaian untuk mengkhususkannya bagi tugas yang akan dilakukannya.

Untuk menyempurnakan FunctionGemma, kami menggunakan dataset Mobile Actions, yang tersedia secara publik di Hugging Face. Setiap entri dalam set data ini memberikan:

- Kumpulan alat (fungsi) yang dapat digunakan model:

- Menyalakan senter

- Mematikan senter

- Membuat kontak di daftar kontak ponsel

- Mengirim email

- Menampilkan lokasi di peta

- Membuka setelan Wi-Fi

- Membuat acara kalender baru

- Perintah sistem yang memberikan konteks seperti tanggal dan waktu saat ini

- Perintah pengguna, seperti

turn on the flashlight. - Respons model yang diharapkan, termasuk panggilan fungsi yang sesuai.

Berikut tampilan fungsi show map:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

Notebook Colab mencakup semua langkah yang diperlukan, termasuk:

- Menyiapkan lingkungan

- Memuat dan melakukan prapemrosesan set data Tindakan Seluler

- Menyesuaikan model menggunakan TRL Hugging Face

- Mengonversi model ke format

.litertlmuntuk deployment

Langkah 2: Men-deploy di Google AI Edge Gallery

Prasyarat: Anda memerlukan Akun Google yang sama dengan yang Anda gunakan untuk menyimpan file

.litertlm pada langkah 1 dan untuk login dengannya di ponsel Android Anda.

Setelah melakukan penyesuaian, kita akan mengonversi dan menguantisasi bobot model ke format .litertlm.

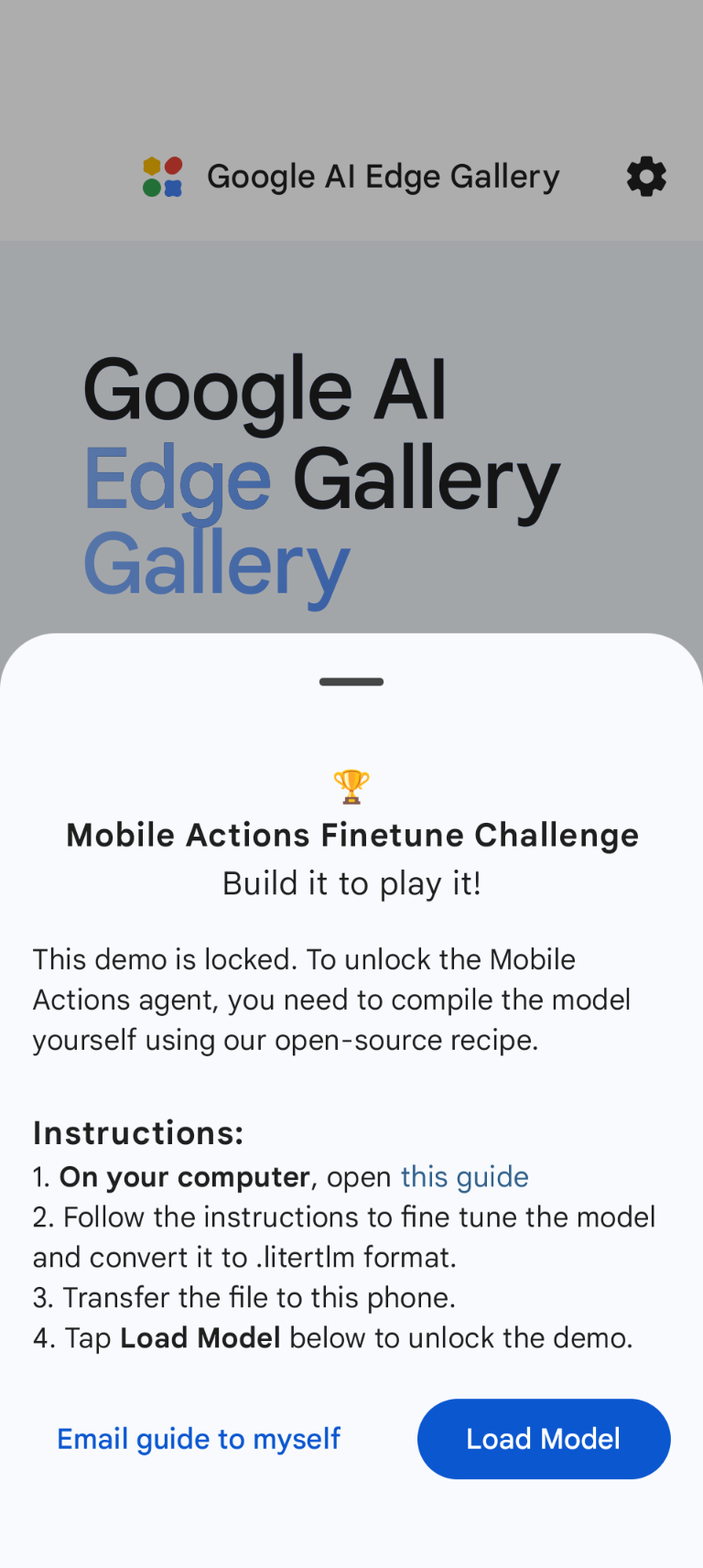

Anda dapat men-deploy model ke opsi Google AI Edge Gallery - Mobile Actions

dengan memilih Load Model dan memilihnya dari Google Drive Anda (atau metode distribusi

alternatif). Google AI Edge Gallery tersedia di Google Play Store.

Sekarang, Anda dapat mencoba memberikan perintah suara atau mengetik di aplikasi untuk melihat seberapa baik model baru yang di-fine-tune memanggil fungsi yang tersedia untuknya.

Langkah Berikutnya

Selamat! Sekarang Anda tahu cara menyesuaikan model dengan Hugging Face dan men-deploy-nya di perangkat dengan LiteRT-LM.