Leistungsstarkes maschinelles Lernen und Bereitstellung von generativer KI auf Edge-Plattformen

Effiziente Konvertierung, Laufzeit und Optimierung für On-Device-Machine-Learning.

Basierend auf der bewährten Grundlage von TensorFlow Lite

LiteRT ist nicht nur neu, sondern die nächste Generation der weltweit am häufigsten eingesetzten Laufzeitumgebung für maschinelles Lernen. Sie ist die Grundlage für die Apps, die Sie täglich verwenden, und bietet auf Milliarden von Geräten eine niedrige Latenz und einen hohen Datenschutz.

Wird von den wichtigsten Google-Apps verwendet

Über 100.000 Apps, Milliarden von Nutzern weltweit

LiteRT-Highlights

Plattformübergreifend

Generative KI nutzen

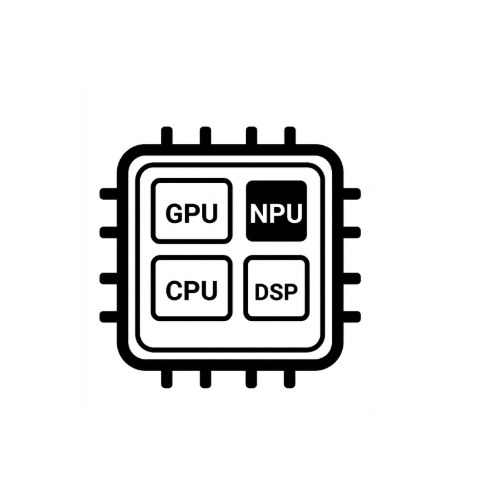

Vereinfachte Hardwarebeschleunigung

Unterstützung mehrerer Frameworks

Über LiteRT bereitstellen

Modell abrufen

Vortrainierte .tflite-Modelle verwenden oder PyTorch-, JAX- oder TensorFlow-Modelle in .tflite konvertieren

Modell optimieren

Optional: Modell quantisieren

Ausführen

Gewünschten Beschleuniger auswählen und in LiteRT ausführen

Beispiele, Modelle und Demo

Beispiel-App ansehen

In Anleitungen wird anhand von vollständigen End-to-End-Beispielen gezeigt, wie Sie LiteRT verwenden.

Generative KI-Modelle ansehen

Vortrainierte, sofort einsatzbereite Modelle für generative KI.

Demos ansehen – Google AI Edge-Galerie App

Eine Galerie mit Anwendungsfällen für On-Device-ML/GenAI