Implantação de ML de alto desempenho e IA generativa em plataformas de borda

Conversão, tempo de execução e otimização eficientes para machine learning no dispositivo.

Criado com base no TensorFlow Lite, que já foi testado em batalha

O LiteRT não é apenas novo, ele é a próxima geração do runtime de aprendizado de máquina mais usado do mundo. Ele alimenta os apps que você usa todos os dias, oferecendo baixa latência e alta privacidade em bilhões de dispositivos.

Usado pelos apps mais importantes do Google

Mais de 100 mil aplicativos, bilhões de usuários no mundo todo

Destaques do LiteRT

Pronto para várias plataformas

Libere a IA generativa

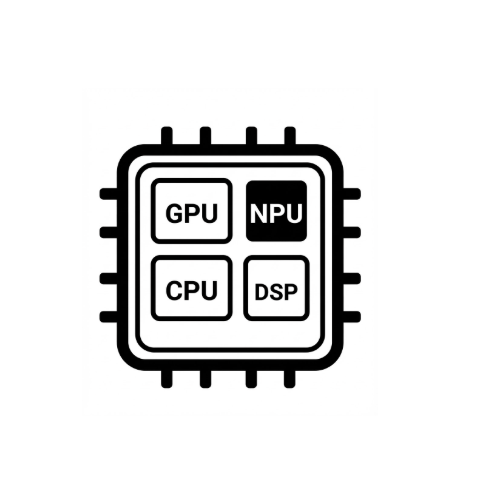

Aceleração de hardware simplificada

Suporte a vários frameworks

Implantar via LiteRT

Receber um modelo

Usar modelos pré-treinados .tflite ou converter modelos do PyTorch, JAX ou TensorFlow para .tflite

Otimizar o modelo

Quantizar o modelo (opcional)

Execução

Escolha o acelerador desejado e execute no LiteRT

Exemplos, modelos e demonstração

Confira um app de exemplo

Os tutoriais ensinam a usar o LiteRT com exemplos completos.

Consulte os modelos de IA generativa

Modelos de IA generativa pré-treinados e prontos para uso.

Confira as demonstrações: app da galeria do Google AI Edge

Uma galeria que mostra casos de uso de ML/IA generativa no dispositivo