在邊緣平台部署高效能機器學習和生成式 AI

有效轉換、執行階段和最佳化,適用於裝置端機器學習。

以 TensorFlow Lite 經過實戰考驗的基礎架構為基礎

LiteRT 不僅是新技術,更是全球部署最廣泛的機器學習執行階段的下一代技術。這項技術支援您每天使用的應用程式,在數十億部裝置上提供低延遲和高隱私權保障。

受最關鍵的 Google 應用程式信賴

超過 10 萬個應用程式,全球數十億使用者

LiteRT 重點

跨平台就緒

發揮生成式 AI 的力量

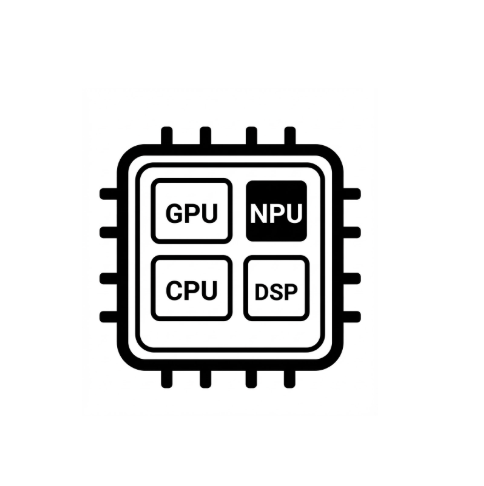

簡化硬體加速

支援多種架構

透過 LiteRT 部署

取得模型

使用 .tflite 預先訓練模型,或將 PyTorch、JAX 或 TensorFlow 模型轉換為 .tflite

將模型最佳化

選擇性量化模型

執行

選擇所需加速器,並在 LiteRT 上執行

範例、模型和試用版

查看範例應用程式

教學課程會示範如何使用 LiteRT,內容包含完整的端對端範例。

查看生成式 AI 模型

預先訓練且立即可用的生成式 AI 模型。

查看示範 - Google AI Edge Gallery 應用程式

展示裝置端機器學習/生成式 AI 用途的藝廊