הרצה ב-Google Colab הרצה ב-Google Colab

|

צפייה במקור ב-GitHub צפייה במקור ב-GitHub

|

סקירה כללית

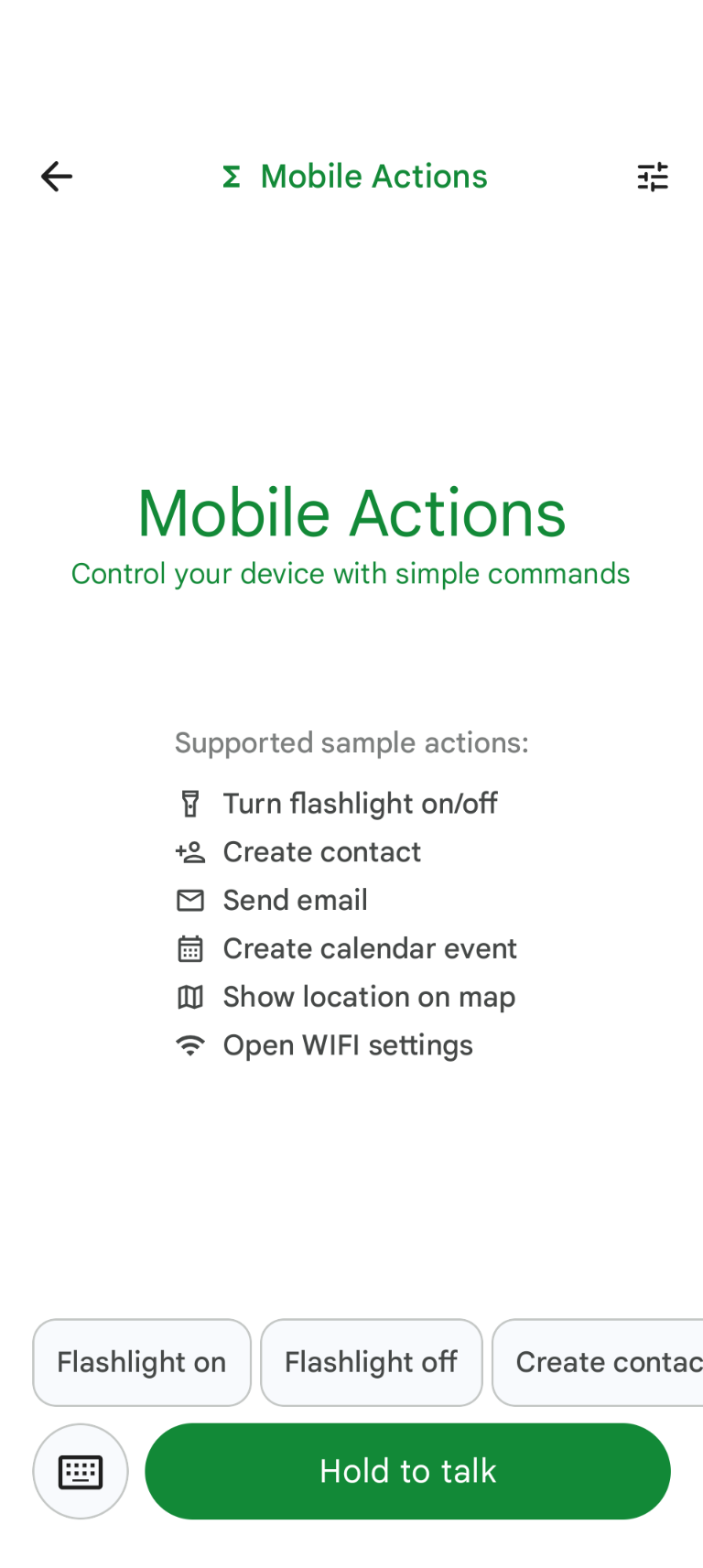

Mobile Actions היא אפליקציית הדגמה שבה משתמשים יכולים להפעיל פעולות במכשיר שלהם באמצעות קלט קולי או קלט טקסט. היא משנה את האינטראקציה עם העוזר הדיגיטלי ליכולת שפועלת באופן מלא אופליין. בין אם אומרים "צור אירוע ביומן לארוחת הצהריים מחר", "הוסף את יובל לאנשי הקשר שלי" או "הפעל את הפנס", המודל מנתח את השפה הטבעית ומזהה את הכלי הנכון במערכת ההפעלה כדי לבצע את הפקודה.

במדריך הזה נסביר איך:

- שיפור הביצועים של מודל FunctionGemma 270M באמצעות מערך הנתונים Mobile Actions

- פריסת המודל המותאם אישית בגלריית Google AI Edge

תוכלו ללמוד את כל התהליך, מכוונון עדין של מודל ועד לפריסה שלו במכשיר.

שלב 1: ביצוע התאמה עדינה של FunctionGemma באמצעות מערך הנתונים של פעולות בנייד

FunctionGemma הוא מודל עם 270 מיליון פרמטרים שמבוסס על ארכיטקטורת Gemma 3. הוא אומן במיוחד לשימוש בפונקציות, ולכן הוא יכול לתרגם בקשות בשפה טבעית לקריאות לפונקציות.

המודל הזה קטן ויעיל מספיק כדי לפעול בטלפון נייד, אבל כמו במודלים בגודל הזה, נדרש כוונון עדין כדי להתאים אותו למשימה שהוא יבצע.

כדי לבצע התאמה עדינה של FunctionGemma, אנחנו משתמשים במערך הנתונים Mobile Actions, שזמין לציבור ב-Hugging Face. כל רשומה במערך הנתונים הזה מספקת את הפרטים הבאים:

- קבוצת הכלים (הפונקציות) שהמודל יכול להשתמש בהם:

- הפעלת הפנס

- כיבוי הפנס

- יצירת איש קשר ברשימת אנשי הקשר בטלפון

- שליחת אימייל

- הצגת מיקום במפה

- פתיחה של הגדרות ה-Wi-Fi

- יצירת אירוע חדש ביומן

- ההנחיה למערכת שמספקת את ההקשר, כמו התאריך והשעה הנוכחיים

- ההנחיה של המשתמש, כמו

turn on the flashlight. - התשובה הצפויה של המודל, כולל הקריאות המתאימות לפונקציות.

כך נראית הפונקציה להצגת המפה:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

מחברת Colab כוללת את כל השלבים הנדרשים, כולל:

- הגדרת הסביבה

- טעינה ועיבוד מוקדם של מערך הנתונים Mobile Actions

- כוונון עדין של המודל באמצעות Hugging Face TRL

- המרת המודל לפורמט

.litertlmלצורך פריסה

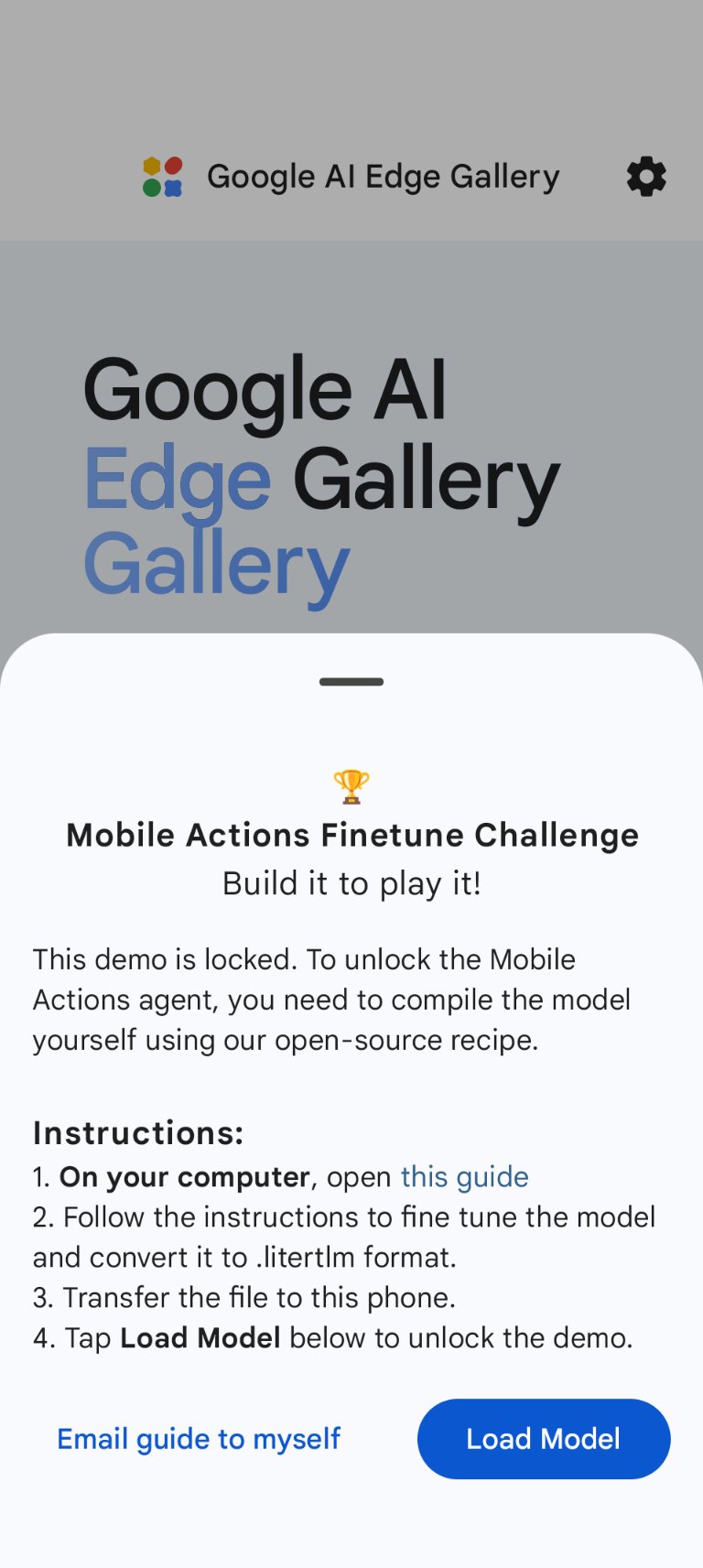

שלב 2: פריסה בגלריית Google AI Edge

דרישה מוקדמת: צריך להשתמש באותו חשבון Google שבו השתמשתם כדי לשמור את הקובץ .litertlm בשלב 1, ולהיכנס לחשבון בטלפון Android.

אחרי הכוונון העדין, אנחנו ממירים את משקלי המודל ומבצעים קוונטיזציה שלהם לפורמט .litertlm.

אפשר לפרוס את המודל בגלריית Google AI Edge – האפשרות 'פעולות בנייד' – על ידי בחירה באפשרות Load Model ובחירת המודל מ-Google Drive (או בשיטת הפצה חלופית). גלריית Google AI Edge API זמינה בחנות Google Play.

עכשיו אפשר לנסות לתת פקודה קולית או להקליד באפליקציה כדי לבדוק עד כמה המודל החדש שעבר כוונון עדין מצליח להפעיל את הפונקציות שזמינות לו.

השלבים הבאים

מעולה! עכשיו אתם יודעים איך לבצע כוונון עדין של מודל באמצעות Hugging Face ולפרוס אותו במכשיר באמצעות LiteRT-LM.