在 Google Colab 中執行 在 Google Colab 中執行

|

在 GitHub 上查看來源 在 GitHub 上查看來源

|

總覽

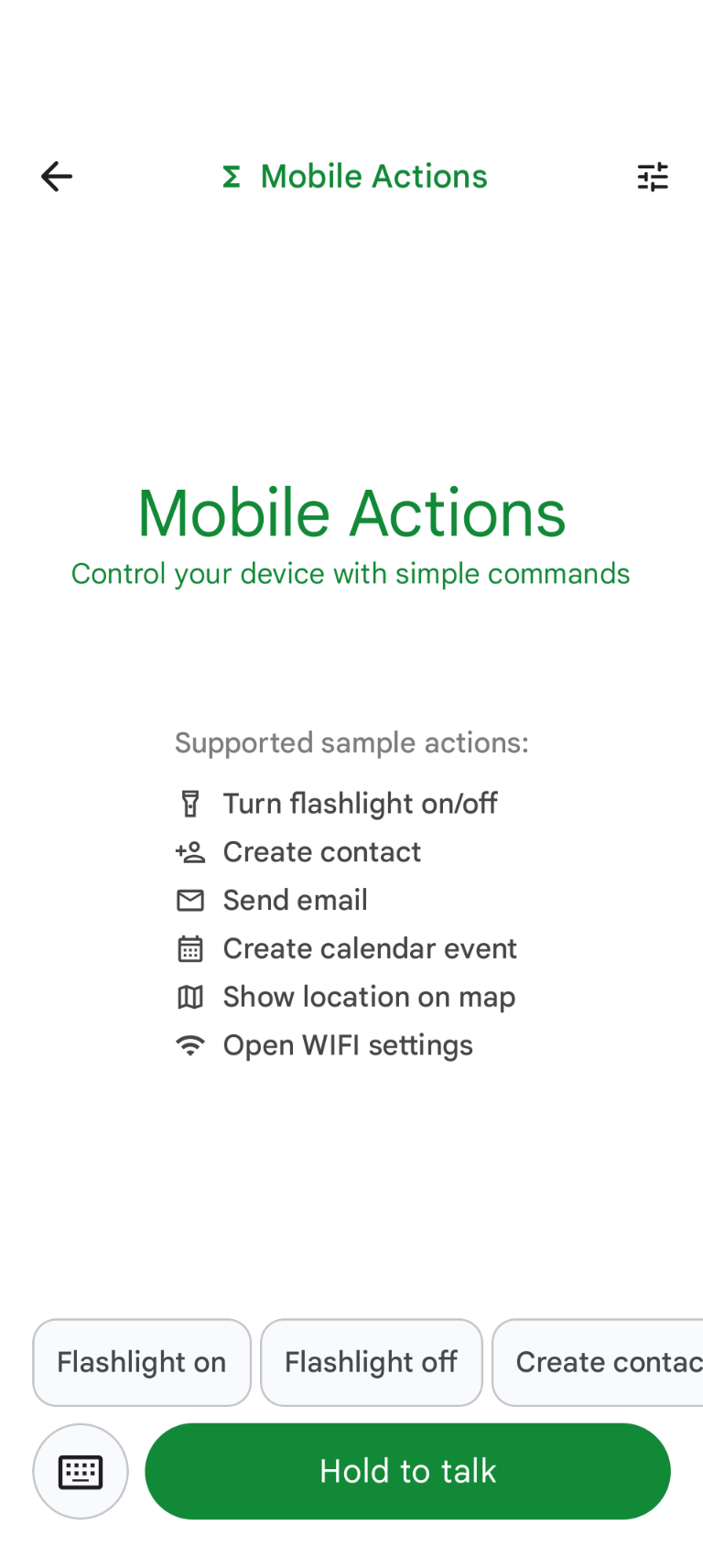

Mobile Actions 是一個示範應用程式,使用者可以透過語音或文字輸入,在裝置上觸發動作。這項功能可讓使用者完全離線與 Google 助理互動。無論是「明天建立午餐的日曆活動」、「將 John 新增至我的聯絡人」,還是「開啟手電筒」,模型都會剖析自然語言,並找出正確的 OS 工具來執行指令。

本指南說明如何:

- 使用 Mobile Actions 資料集微調 FunctionGemma 270M 模型

- 將自訂模型部署至 Google AI Edge Gallery

您將能從微調模型到在裝置上部署模型,學習端對端流程。

步驟 1:使用 Mobile Actions 資料集微調 FunctionGemma

FunctionGemma 是以 Gemma 3 架構為基礎的 2.7 億個參數模型。這項模型經過專門訓練,可執行函式呼叫,因此能將自然語言要求轉換為函式呼叫。

這個模型夠小也夠有效率,可以在手機上執行,但與這個大小的模型一樣,需要經過微調,才能專門執行特定工作。

如要微調 FunctionGemma,我們使用 Mobile Actions 資料集,這個資料集已在 Hugging Face 上公開發布。這個資料集中的每個項目都提供:

- 模型可使用的工具 (函式) 組合:

- 開啟手電筒

- 關閉手電筒

- 在手機的聯絡人清單中建立聯絡人

- 傳送電子郵件

- 在地圖上顯示位置

- 開啟 Wi-Fi 設定

- 建立新的日曆活動

- 提供脈絡資訊的系統提示,例如目前的日期和時間

- 使用者提示,例如

turn on the flashlight。 - 預期的模型回應,包括適當的函式呼叫。

顯示地圖函式如下所示:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

Colab 筆記本涵蓋所有必要步驟,包括:

- 設定環境

- 載入及預先處理 Mobile Actions 資料集

- 使用 Hugging Face TRL 微調模型

- 將模型轉換為

.litertlm格式以供部署

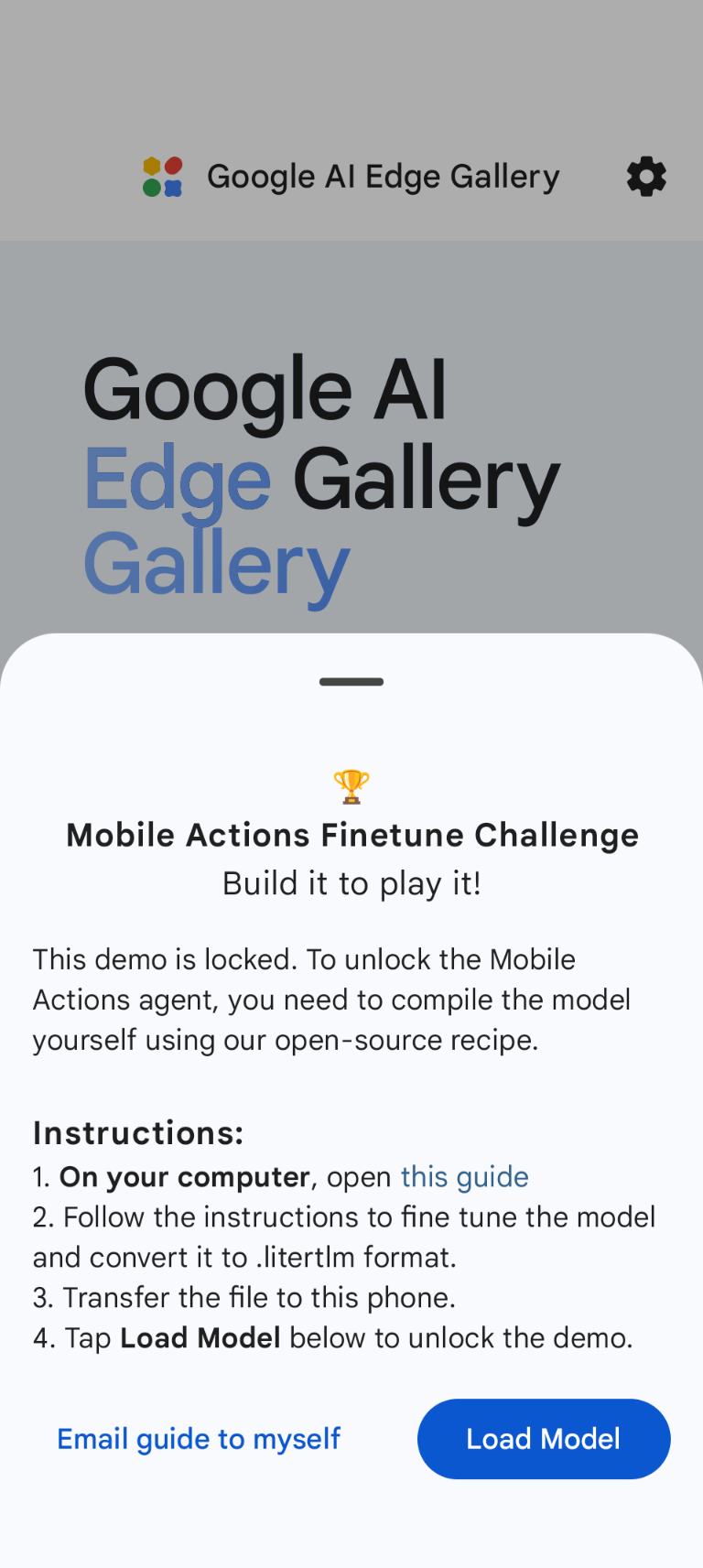

步驟 2:在 Google AI Edge Gallery 上部署

先決條件:您必須使用在步驟 1 中儲存 .litertlm 檔案時使用的 Google 帳戶,並在 Android 手機上登入該帳戶。

微調後,我們會將模型權重轉換並量化為 .litertlm 格式。

您可以選擇 Load Model,然後從 Google 雲端硬碟 (或替代發布方式) 選取模型,將模型部署至 Google AI Edge Gallery - Mobile Actions 選項。Google AI Edge Gallery 可在 Google Play 商店下載。

現在,您可以嘗試在應用程式中輸入或說出語音指令,看看新微調模型呼叫可用函式的效果。

後續步驟

恭喜!您現在已瞭解如何使用 Hugging Face 微調模型,並透過 LiteRT-LM 在裝置上部署模型。