تفعيل الذكاء الاصطناعي التوليدي وتعلُّم الآلة عالي الأداء على المنصات الطرفية

تحويل النماذج وتشغيلها وتحسينها بكفاءة لتعلُّم الآلة على الجهاز

استنادًا إلى الأساس الذي تم اختباره في TensorFlow Lite

إنّ LiteRT ليس مجرد إصدار جديد، بل هو الجيل التالي من وقت تشغيل تعلُّم الآلة الأكثر استخدامًا على نطاق واسع في العالم. وهي تتيح تشغيل التطبيقات التي تستخدمها كل يوم، وتوفّر معدل نقل بيانات منخفضًا ومستوى عاليًا من الخصوصية على مليارات الأجهزة.

موثوق بها من قِبل أهم تطبيقات Google

أكثر من 100 ألف تطبيق ومليارات المستخدمين حول العالم

أبرز ميزات LiteRT

جاهز للاستخدام على عدّة منصات

إطلاق العنان للذكاء الاصطناعي التوليدي

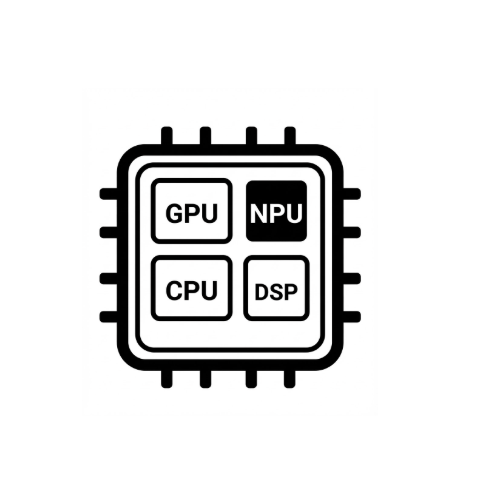

تبسيط ميزة "تسريع الأجهزة"

التوافق مع أُطر عمل متعددة

النشر من خلال LiteRT

الحصول على نموذج

استخدام نماذج .tflite مدرَّبة مسبقًا أو تحويل نماذج PyTorch أو JAX أو TensorFlow إلى .tflite

تحسين النموذج

تحديد الكمية بشكل اختياري

تشغيل

اختيار أداة التسريع المطلوبة وتشغيلها على LiteRT

العيّنات والنماذج والعروض التوضيحية

الاطّلاع على نموذج تطبيق

توضّح البرامج التعليمية كيفية استخدام LiteRT مع أمثلة كاملة وشاملة.

عرض نماذج الذكاء الاصطناعي التوليدي

نماذج الذكاء الاصطناعي التوليدي المدرَّبة مسبقًا والجاهزة للاستخدام

مشاهدة العروض التوضيحية - تطبيق "معرض Google AI Edge"

معرض يعرض حالات استخدام تعلُّم الآلة/الذكاء الاصطناعي التوليدي على الجهاز