Google Colab에서 실행 Google Colab에서 실행

|

GitHub에서 소스 보기 GitHub에서 소스 보기

|

개요

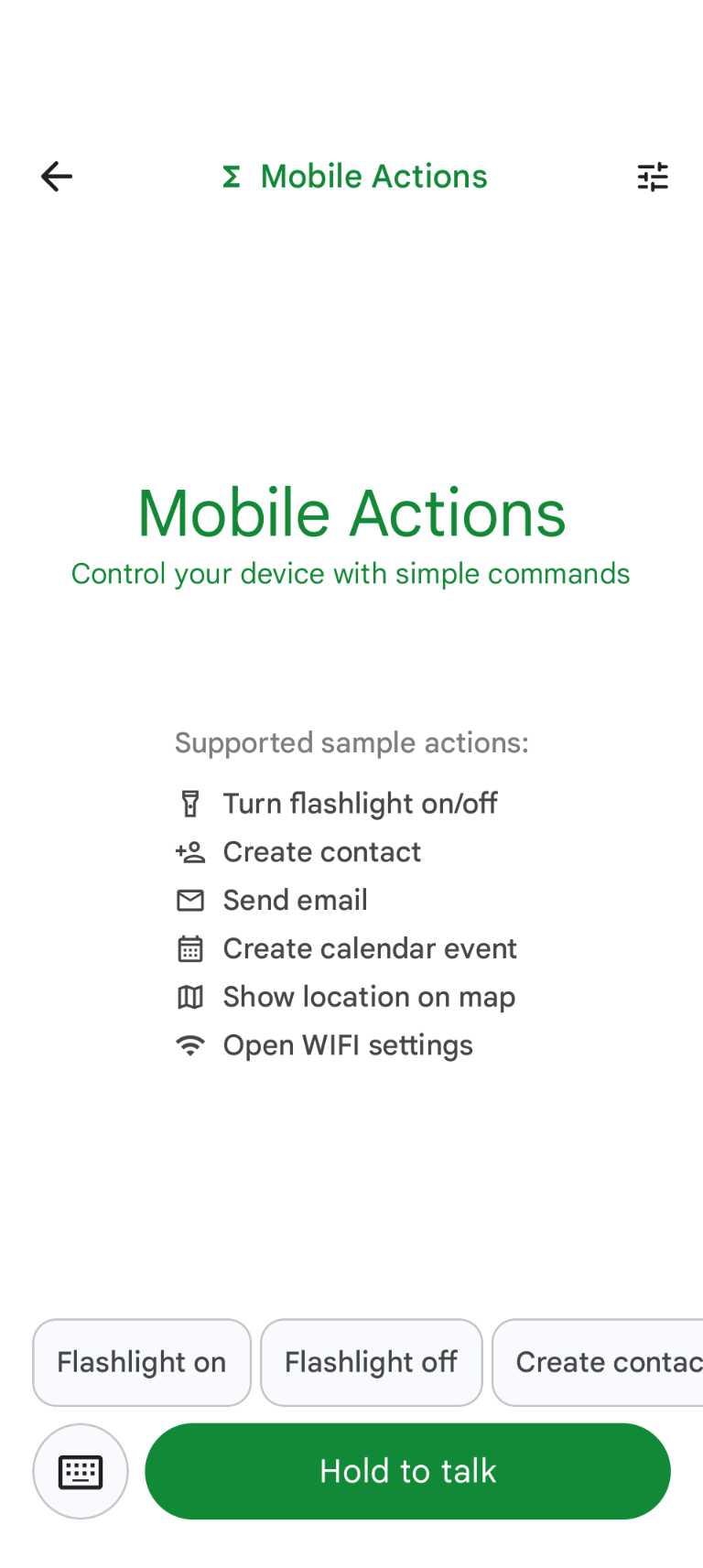

Mobile Actions는 사용자가 음성 또는 텍스트 입력에서 기기의 작업을 트리거할 수 있는 데모 앱입니다. 어시스턴트 상호작용을 완전한 오프라인 기능으로 재해석합니다. '내일 점심 식사 캘린더 일정 만들어 줘', '내 연락처에 존 추가해 줘', '손전등 켜 줘' 등 모델은 자연어를 파싱하고 명령을 실행할 올바른 OS 도구를 식별합니다.

이 가이드에서는 다음을 수행하는 방법을 설명합니다.

- Mobile Actions 데이터 세트를 사용하여 FunctionGemma 270M 모델 미세 조정

- 맞춤 모델을 Google AI Edge 갤러리에 배포

모델 미세 조정부터 기기에 배포까지 엔드 투 엔드로 학습할 수 있습니다.

1단계: 모바일 작업 데이터 세트로 FunctionGemma 미세 조정

FunctionGemma는 Gemma 3 아키텍처를 기반으로 하는 2억 7천만 개의 파라미터 모델입니다. 함수 호출을 위해 특별히 학습되었으며, 자연어 요청을 함수 호출로 변환할 수 있습니다.

이 모델은 휴대 전화에서 실행할 수 있을 만큼 작고 효율적이지만, 이 크기의 모델에 흔히 그렇듯이 실행할 작업에 맞게 특화하려면 미세 조정이 필요합니다.

FunctionGemma를 파인 튜닝하기 위해 Hugging Face에서 공개적으로 제공되는 Mobile Actions 데이터 세트를 사용합니다. 이 데이터 세트의 각 항목은 다음을 제공합니다.

- 모델이 사용할 수 있는 도구 (함수) 집합입니다.

- 손전등을 켭니다.

- 손전등을 끕니다.

- 휴대전화의 연락처 목록에 연락처를 만듭니다.

- 이메일을 전송합니다.

- 지도에 위치를 표시합니다.

- Wi-Fi 설정을 엽니다.

- 새 캘린더 일정을 만듭니다.

- 현재 날짜 및 시간과 같은 컨텍스트를 제공하는 시스템 프롬프트

- 사용자 프롬프트(예:

turn on the flashlight) - 적절한 함수 호출을 포함한 예상 모델 응답입니다.

지도 표시 기능은 다음과 같습니다.

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

Colab 노트북에서는 다음을 비롯한 모든 필수 단계를 다룹니다.

- 환경 설정

- 모바일 작업 데이터 세트 로드 및 전처리

- Hugging Face TRL을 사용하여 모델 미세 조정

- 배포를 위해 모델을

.litertlm형식으로 변환

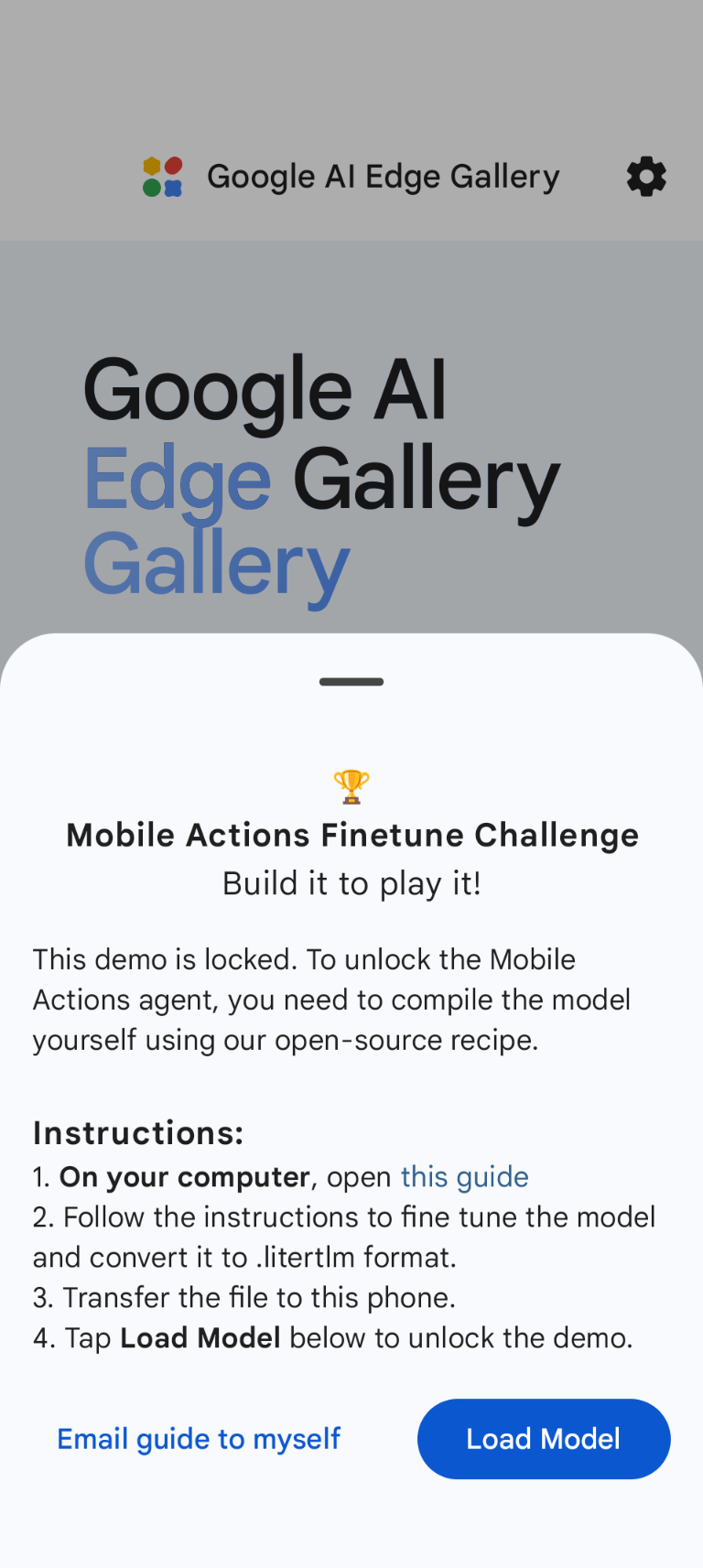

2단계: Google AI Edge Gallery에 배포

기본 요건: 1단계에서 .litertlm 파일을 저장할 때 사용한 Google 계정이 필요하며 Android 휴대전화에서 해당 계정으로 로그인해야 합니다.

미세 조정 후 모델 가중치를 .litertlm 형식으로 변환하고 양자화합니다.

Load Model를 선택하고 Google Drive (또는 대체 배포 방법)에서 선택하여 모델을 Google AI Edge Gallery - Mobile Actions 옵션에 배포할 수 있습니다. Google AI Edge 갤러리는 Google Play 스토어에서 사용할 수 있습니다.

이제 앱에서 음성 명령을 내리거나 텍스트를 입력하여 새로 미세 조정된 모델이 사용 가능한 함수를 얼마나 잘 호출하는지 확인할 수 있습니다.

다음 단계

축하합니다. 이제 Hugging Face로 모델을 파인 튜닝하고 LiteRT-LM으로 기기에 배포하는 방법을 알게 되었습니다.