Uruchom w Google Colab Uruchom w Google Colab

|

Wyświetl źródło na GitHubie Wyświetl źródło na GitHubie

|

Przegląd

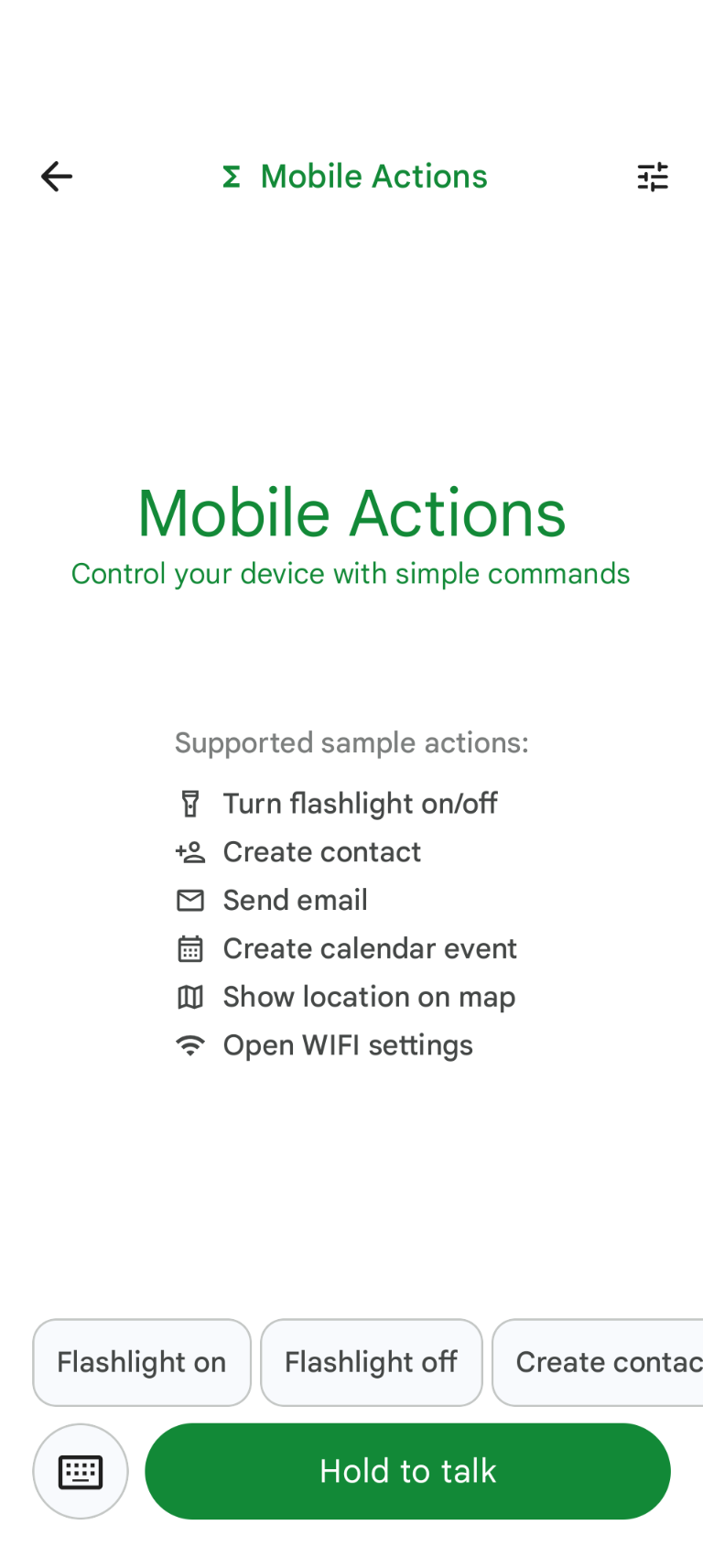

Mobile Actions to aplikacja demonstracyjna, w której użytkownicy mogą wywoływać działania na urządzeniu za pomocą poleceń głosowych lub tekstowych. Zmienia ona sposób interakcji z asystentem, który może działać w trybie offline. Niezależnie od tego, czy jest to „Utwórz wydarzenie w kalendarzu na jutrzejszy lunch”, „Dodaj Johna do moich kontaktów” czy „Włącz latarkę”, model analizuje język naturalny i identyfikuje odpowiednie narzędzie systemu operacyjnego do wykonania polecenia.

Z tego przewodnika dowiesz się, jak:

- Dostrajanie modelu FunctionGemma 270M za pomocą zbioru danych Mobile Actions

- Wdrażanie dostosowanego modelu w Galerii Google AI Edge

Dowiesz się wszystkiego, od dostrajania modelu po jego wdrażanie na urządzeniu.

Krok 1. Dostrajanie modelu FunctionGemma za pomocą zbioru danych Mobile Actions Dataset

FunctionGemma to model z 270 milionami parametrów oparty na architekturze Gemma 3. Został wytrenowany specjalnie pod kątem wywoływania funkcji, dzięki czemu może tłumaczyć żądania w języku naturalnym na wywołania funkcji.

Ten model jest wystarczająco mały i wydajny, aby można go było uruchomić na telefonie komórkowym, ale jak to zwykle bywa w przypadku modeli tej wielkości, wymaga dostrojenia, aby wyspecjalizować go w wykonywaniu określonego zadania.

Aby dostroić model FunctionGemma, używamy zbioru danych Mobile Actions, który jest publicznie dostępny na platformie Hugging Face. Każdy wpis w tym zbiorze danych zawiera:

- Zestaw narzędzi (funkcji), których może używać model:

- Włącza latarkę

- Wyłącza latarkę

- tworzy kontakt na liście kontaktów telefonu;

- wysyła e-maile;

- Wyświetla lokalizację na mapie.

- Otwiera ustawienia Wi-Fi

- Tworzy nowe wydarzenie w kalendarzu.

- prompt systemowy zawierający kontekst, np. bieżącą datę i godzinę;

- Prompt użytkownika, np.

turn on the flashlight. - Oczekiwana odpowiedź modelu, w tym odpowiednie wywołania funkcji.

Funkcja wyświetlania mapy wygląda tak:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

Notatnik Colab zawiera wszystkie niezbędne kroki, w tym:

- Konfigurowanie środowiska

- Wczytywanie i wstępne przetwarzanie zbioru danych Mobile Actions

- Dostrajanie modelu za pomocą Hugging Face TRL

- Konwertowanie modelu do formatu

.litertlmna potrzeby wdrożenia

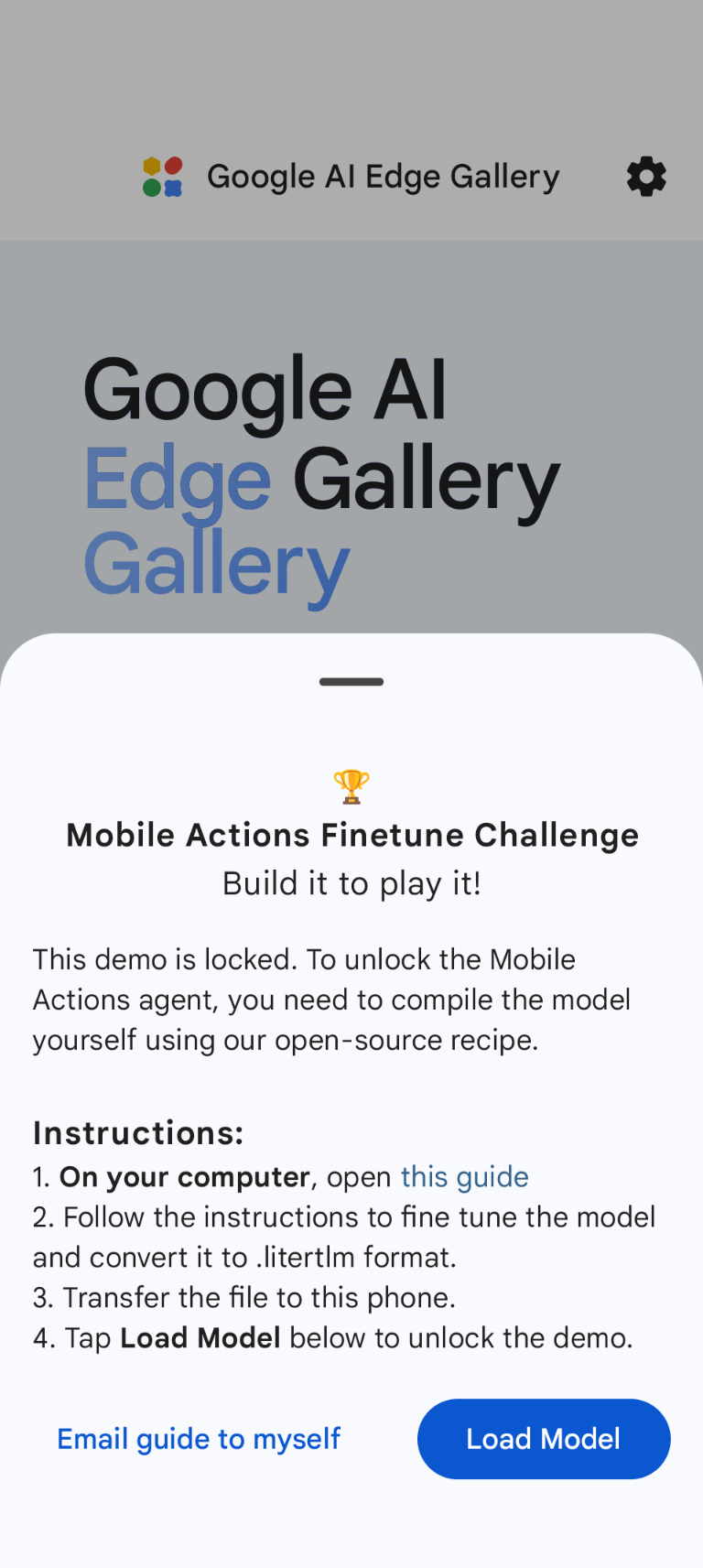

Krok 2. Wdrażanie w Galerii Google AI Edge

Wymaganie wstępne: musisz mieć to samo konto Google, którego użyto do zapisania pliku .litertlm w kroku 1, i musisz być na nim zalogowany(-a) na telefonie z Androidem.

Po dostrojeniu przekształcamy i kwantyzujemy wagi modelu do formatu .litertlm.

Model możesz wdrożyć w opcji Galeria AI Edge od Google – działania na urządzeniach mobilnych, wybierając Load Model i wybierając go z Dysku Google (lub korzystając z innej metody dystrybucji). Galeria Google AI Edge jest dostępna w Sklepie Google Play.

Teraz możesz wypróbować polecenie głosowe lub wpisać tekst w aplikacji, aby sprawdzić, jak dobrze nowy, dostrojony model wywołuje dostępne dla niego funkcje.

Następne kroki

Gratulacje! Wiesz już, jak dostroić model za pomocą Hugging Face i wdrożyć go na urządzeniu za pomocą LiteRT-LM.