Die parallele Bewertung hat sich als gängige Strategie zur Bewertung der Qualität und Sicherheit von Antworten von Large Language Models (LLMs) Mit einem direkten Vergleich können Sie zwischen zwei verschiedenen Modellen, zwei verschiedenen Prompts für dasselbe Modell oder sogar zwei verschiedenen Tunings eines Modells wählen. Die manuelle Analyse von Ergebnissen eines direkten Vergleichs kann jedoch mühsam und zeitaufwendig sein.

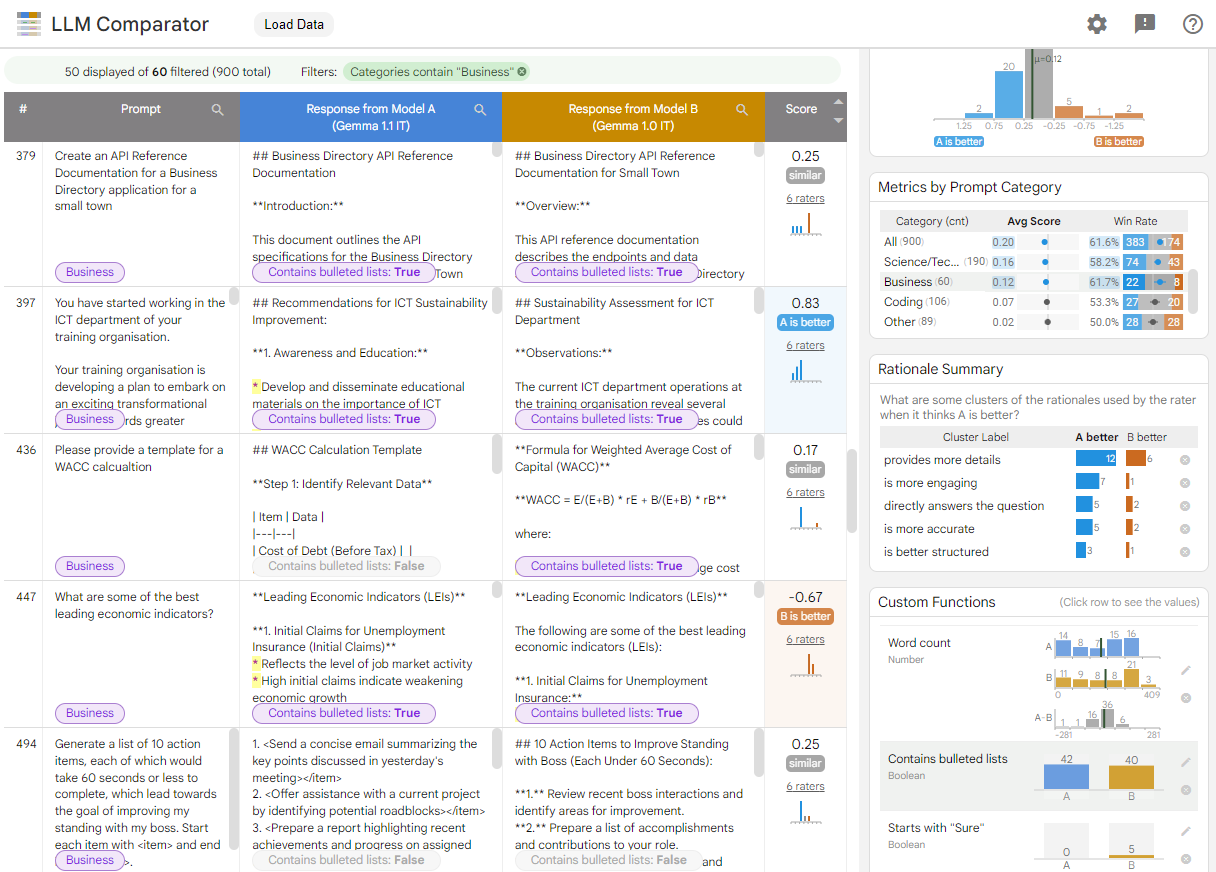

Der LLM-Vergleicher ist eine Web-App mit einer Companion-Anzeige. Python-Bibliothek für eine effektivere, skalierbare Analyse direkte Bewertungen mit interaktiven Visualisierungen. Der LLM-Vergleichstool bietet folgende Vorteile:

Sehen, wo sich die Modellleistung unterscheidet: Sie können die Antworten aufteilen. zur Identifizierung von Teilmengen der Evaluationsdaten, sich zwischen zwei Modellen unterscheiden.

Gründe für Unterschiede verstehen: Es ist üblich, Richtlinien gegen welche Modellleistung und Compliance bewertet wird. Die Parallele Bewertung hilft dabei, die Bewertung der Richtlinienkonformität zu automatisieren und liefert Begründungen dafür, welches Modell wahrscheinlich besser konform ist. Der LLM-Vergleicher fasst diese Gründe in mehreren Themen zusammen und hebt hervor, welches Modell besser zu jedem Thema passt.

Untersuchen, wie sich die Modellergebnisse unterscheiden: Mithilfe von integrierten und benutzerdefinierten Vergleichsfunktionen können Sie untersuchen, wie sich die Ergebnisse von zwei Modellen unterscheiden. Das Tool kann bestimmte Muster im von den Modellen generierten Text hervorheben und so einen klaren Bezugspunkt für die Unterschiede liefern.

Abbildung 1. LLM-Vergleichsoberfläche mit einem Vergleich des Gemma Instruct 7B-Modells der Version 1.1 mit der Version 1.0

Mit dem LLM-Vergleich können Sie Bewertungsergebnisse vergleichen. Es fasst die Modellleistung aus verschiedenen Blickwinkeln visuell zusammen. einzelne Modellausgaben interaktiv für ein tieferes Verständnis untersuchen.

LLM Comparator ausprobieren:

- In dieser Demo wird die Leistung von Gemma Instruct 7B v1.1 verglichen. gegen die Gemma Instruct 7B v1.0 auf der Dataset Chatbot Arena Conversations.

- In diesem Colab-Notebook wird mit der Python-Bibliothek eine kleine vergleichende Bewertung mit der Vertex AI API durchgeführt und die Ergebnisse in einer Zelle in die LLM-Vergleichs-App geladen.

Weitere Informationen zum LLM-Vergleich finden Sie im Forschungspapier und im GitHub-Repository.