Параллельная оценка стала общей стратегией оценки качества и безопасности ответов на основе больших языковых моделей (LLM). Параллельное сравнение можно использовать для выбора между двумя разными моделями, двумя разными подсказками для одной и той же модели или даже двумя разными настройками модели. Однако анализ результатов параллельного сравнения вручную может оказаться обременительным и утомительным.

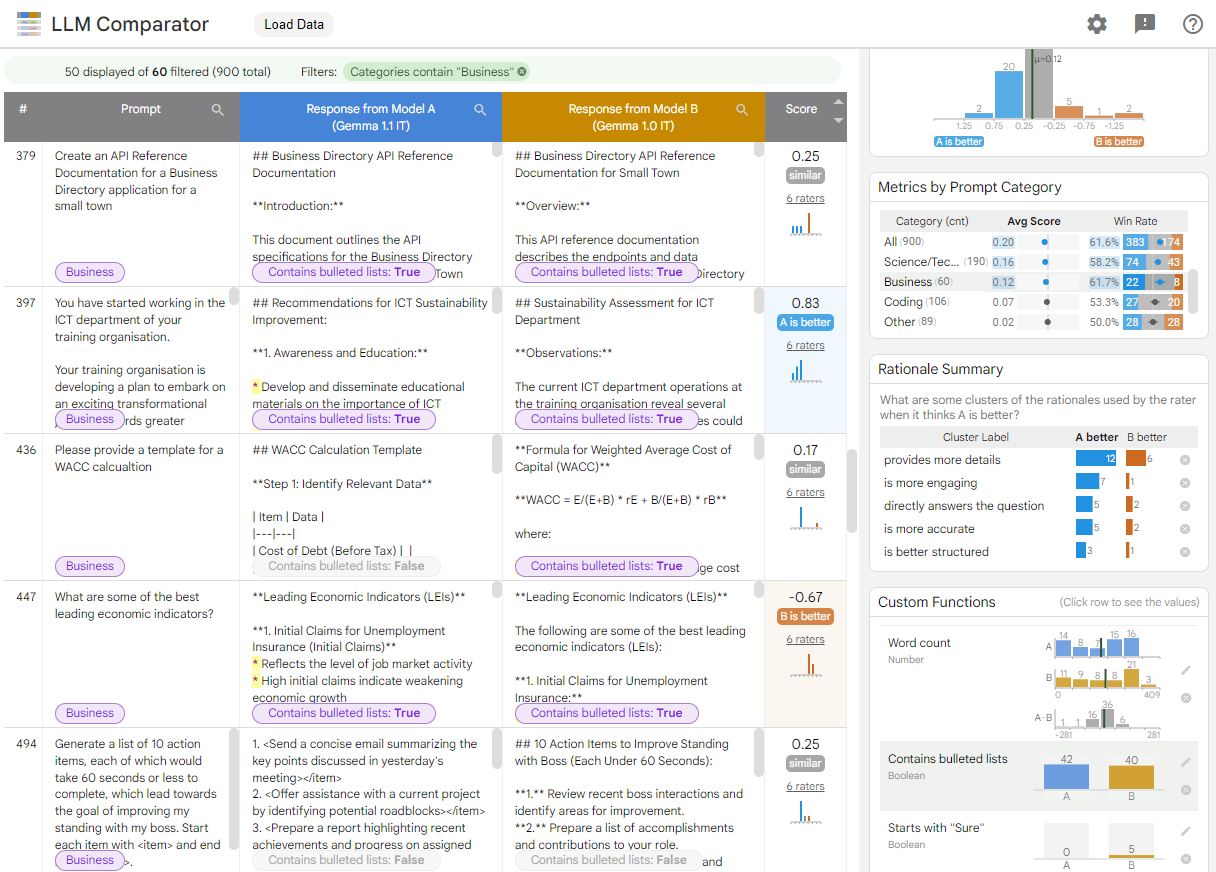

LLM Comparator — это веб-приложение с сопутствующей библиотекой Python , которое обеспечивает более эффективный и масштабируемый анализ параллельных оценок с помощью интерактивных визуализаций. LLM Comparator поможет вам:

Посмотрите , где различается производительность модели . Вы можете разделить ответы, чтобы определить подмножества оценочных данных, в которых выходные данные существенно различаются между двумя моделями.

Поймите, почему это отличается . Обычно существует политика, по которой оценивается производительность и соответствие модели. Параллельная оценка помогает автоматизировать оценку соответствия политике и дает обоснование того, какая модель, вероятно, более соответствует требованиям. LLM Comparator обобщает эти причины по нескольким темам и выделяет, какая модель лучше соответствует каждой теме.

Изучите , чем отличаются выходные данные модели . Вы можете дополнительно изучить, чем отличаются выходные данные двух моделей, с помощью встроенных и определяемых пользователем функций сравнения. Инструмент может выделять определенные закономерности в тексте, созданном моделями, обеспечивая четкую основу для понимания их различий.

Рисунок 1. Интерфейс LLM Comparator, показывающий сравнение модели Gemma Instruct 7B v1.1 с версией v1.0.

LLM Comparator помогает анализировать результаты параллельной оценки. Он визуально обобщает производительность модели с разных точек зрения, позволяя вам в интерактивном режиме проверять выходные данные отдельных моделей для более глубокого понимания.

Изучите LLM Comparator самостоятельно:

- В этой демонстрации сравнивается производительность Gemma Instruct 7B v1.1 с Gemma Instruct 7B v1.0 в наборе данных Chatbot Arena Conversations .

- Этот блокнот Colab использует библиотеку Python для выполнения небольшой параллельной оценки с использованием API Vertex AI и загружает результаты в ячейку приложения LLM Comparator.

Дополнительную информацию о LLM Comparator можно найти в исследовательской работе и репозитории GitHub .