L'évaluation côte à côte s'est imposée comme une stratégie courante d'évaluation des la qualité et la sécurité des réponses des grands modèles de langage (LLM). Les comparaisons côte à côte peuvent être utilisées pour choisir entre deux modèles différents, deux invites différentes pour un même modèle, ou même deux réglages différents d'un modèle. Toutefois, l'analyse manuelle des résultats de comparaison côte à côte peut s'avérer fastidieuse et fastidieux.

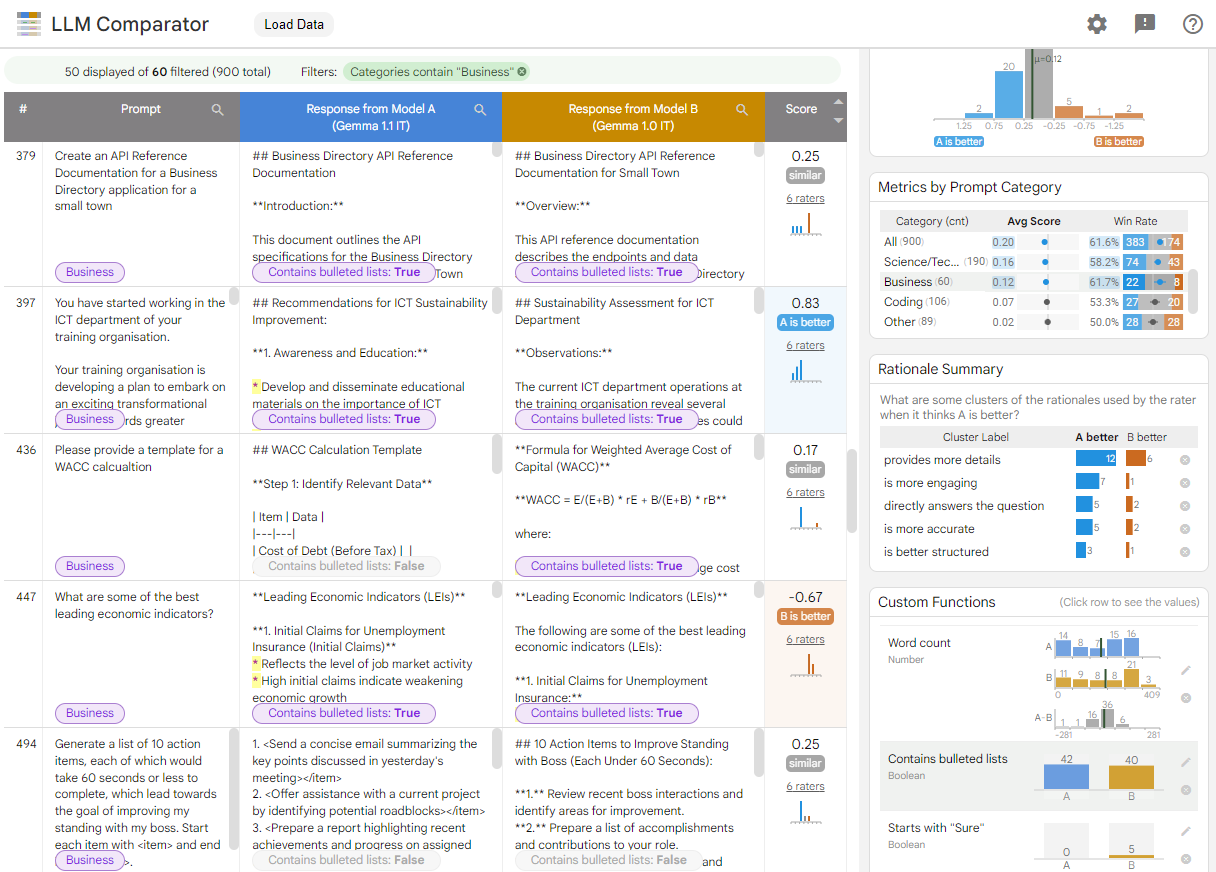

Le comparateur LLM est une application Web dotée d'un outil Bibliothèque Python permettant une analyse plus efficace et évolutive d'évaluations côte à côte avec des visualisations interactives. Le comparateur LLM vous aide à :

Identifier les points où les performances du modèle diffèrent : vous pouvez découper les réponses pour identifier les sous-ensembles des données d'évaluation où les sorties diffèrent de manière significative entre deux modèles.

Comprendre pourquoi il est différent : il est courant de disposer d'un règlement en fonction duquel les performances et la conformité du modèle sont évaluées. L'évaluation côte à côte permet d'automatiser les évaluations de conformité aux règles et de justifier le modèle le plus conforme. Le comparateur LLM résume ces raisons en plusieurs thèmes et met en évidence le modèle qui correspond le mieux à chaque thème.

Examinez en quoi les sorties du modèle diffèrent: vous pouvez examiner plus en détail en quoi les sorties des deux modèles diffèrent grâce à des fonctions intégrées et définies par l'utilisateur fonctions de comparaison. L'outil peut mettre en évidence des modèles spécifiques dans le texte les modèles générés, ce qui offre une base claire pour comprendre les différences.

Figure 1. Interface de comparaison LLM affichant une comparaison des modèles Gemma Tester le modèle 7B version 1.1 pour le comparer à la version 1.0

Le comparateur de LLM vous aide à analyser côte à côte les résultats d'évaluation. Il résume visuellement les performances du modèle sous plusieurs angles, tout en vous permettant inspecter de manière interactive les résultats de chaque modèle pour en savoir plus

Explorez le comparateur LLM par vous-même:

- Cette démo compare les performances de Gemma Instruct 7B v1.1 à celles de Gemma Instruct 7B v1.0 sur l'ensemble de données Chatbot Arena Conversations.

- Ce notebook Colab utilise la bibliothèque Python pour exécuter à l'aide de l'API Vertex AI et charge dans l'application de comparaison LLM dans une cellule.

Pour en savoir plus sur le comparateur LLM, consultez le document de recherche et Dépôt GitHub.