ارزیابی جانبی به عنوان یک استراتژی مشترک برای ارزیابی کیفیت و ایمنی پاسخها از مدلهای زبان بزرگ (LLM) پدیدار شده است. از مقایسه های کنار هم می توان برای انتخاب بین دو مدل مختلف، دو دستور مختلف برای یک مدل یا حتی دو تنظیم متفاوت از یک مدل استفاده کرد. با این حال، تجزیه و تحلیل دستی نتایج مقایسه کنار هم می تواند دست و پا گیر و خسته کننده باشد.

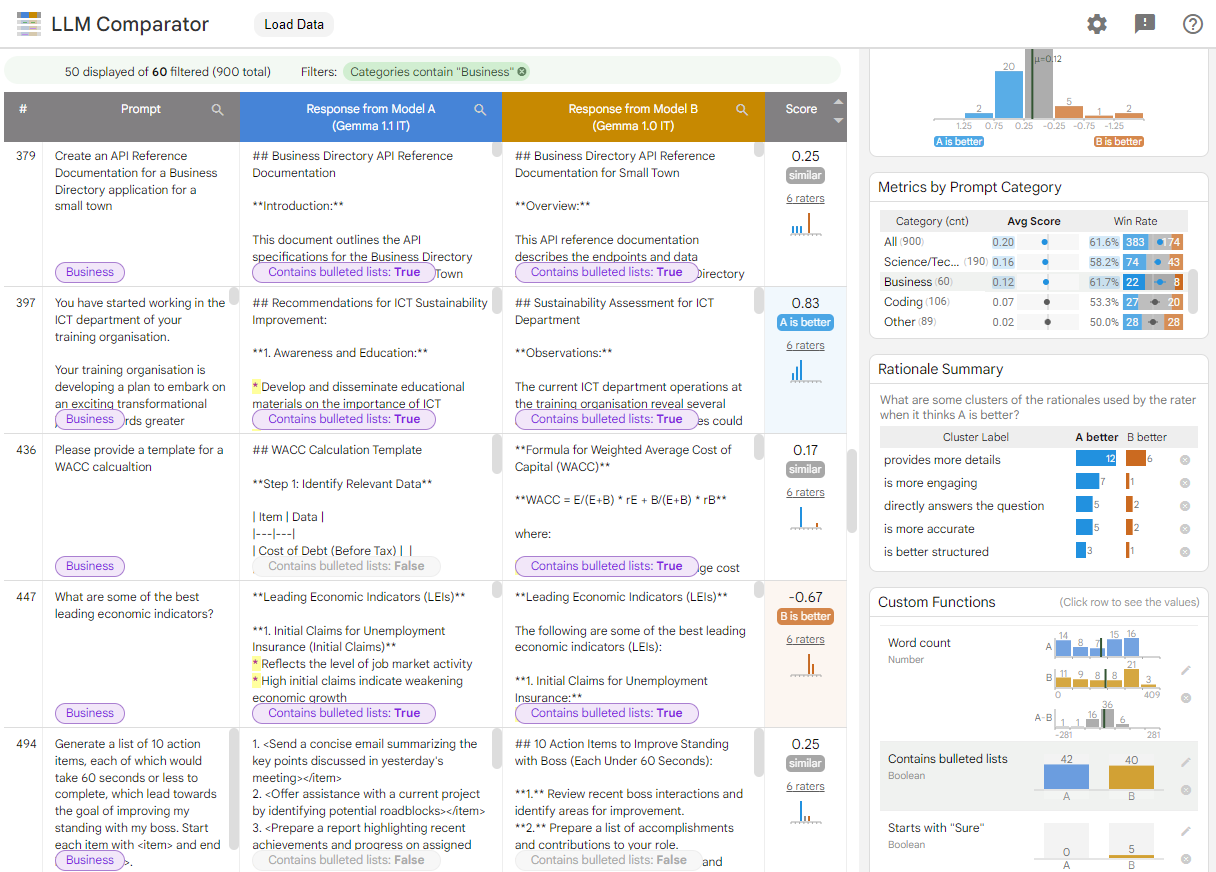

LLM Comparator یک برنامه وب با کتابخانه پایتون همراه است که تجزیه و تحلیل موثرتر و مقیاس پذیر ارزیابی های جانبی را با تجسم های تعاملی امکان پذیر می کند. LLM Comparator به شما کمک می کند:

ببینید عملکرد مدل در کجا متفاوت است : میتوانید پاسخها را برای شناسایی زیرمجموعههای دادههای ارزیابی که در آن خروجیها به طور معناداری بین دو مدل متفاوت است، تقسیم کنید.

درک چرایی تفاوت آن : داشتن خط مشی ای که بر اساس آن عملکرد و انطباق مدل ارزیابی می شود، امری رایج است. ارزیابی جانبی به خودکارسازی ارزیابیهای انطباق با خطمشی کمک میکند و دلایل منطقی را ارائه میکند که کدام مدل احتمالاً مطابقت بیشتری دارد. LLM Comparator این دلایل را در چندین موضوع خلاصه می کند و مشخص می کند که کدام مدل با هر موضوع هماهنگ تر است.

بررسی تفاوت خروجی های مدل : می توانید بیشتر بررسی کنید که چگونه خروجی های دو مدل از طریق توابع مقایسه داخلی و تعریف شده توسط کاربر متفاوت است. این ابزار میتواند الگوهای خاصی را در متنی که مدلها تولید میکنند برجسته کند و لنگر واضحی برای درک تفاوتهای آنها ارائه دهد.

شکل 1. رابط مقایسه کننده LLM که مقایسه مدل Gemma Instruct 7B v1.1 را در مقابل v1.0 نشان می دهد.

LLM Comparator به شما کمک می کند تا نتایج ارزیابی کنار هم را تجزیه و تحلیل کنید. به صورت بصری عملکرد مدل را از زوایای مختلف خلاصه میکند، در حالی که به شما امکان میدهد به صورت تعاملی خروجیهای مدل را برای درک عمیقتر بررسی کنید.

مقایسه کننده LLM را برای خودتان کاوش کنید:

- این نسخه نمایشی عملکرد Gemma Instruct 7B v1.1 را با Gemma Instruct 7B v1.0 در مجموعه داده Chatbot Arena Conversations مقایسه می کند.

- این نوت بوک Colab از کتابخانه Python برای اجرای یک ارزیابی کوچک کنار هم با استفاده از Vertex AI API استفاده می کند و نتایج را در برنامه LLM Comparator در یک سلول بارگیری می کند.

برای اطلاعات بیشتر درباره LLM Comparator، مقاله تحقیقاتی و مخزن GitHub را بررسی کنید.