Porównawcze testy stały się powszechną strategią oceny jakości i bezpieczeństwa odpowiedzi generowanych przez duże modele językowe (LLM). Obok siebie za pomocą porównania pozwala wybrać 2 różne modele, dla tego samego modelu, a nawet na dwa różne sposoby dostrajania modelu. Ręczne analizowanie wyników porównania może być jednak uciążliwe i żmudne.

LLM Comparator to aplikacja internetowa wraz z Biblioteka Pythona, która umożliwia skuteczniejszą, skalowalną analizę ocen bezpośrednich z interaktywnymi wizualizacjami. Porównywarka LLM pomaga:

Zobacz, gdzie różni się wydajność modelu: możesz posegmentować odpowiedzi aby identyfikować podzbiory danych oceny, z których uzyskujesz sensowne wyniki różnią się między 2 modelami.

Dowiedz się, dlaczego dane się różnią: często spotykają się z zasadami naruszającymi zasady który model jest oceniany pod kątem wydajności i zgodności. Ocena porównawcza pomaga zautomatyzować ocenę zgodności z zasadami i podaje uzasadnienie, dlaczego dany model jest bardziej zgodny z zasadami. Narzędzie LLM Comarator podsumowuje te przyczyny na kilka tematów i wyróżnia model, który lepiej pasuje do danego motywu.

Sprawdzanie, jak różnią się dane wyjściowe modelu: możesz dokładniej zbadać, dane wyjściowe 2 modeli różnią się wbudowanymi i zdefiniowanymi przez użytkownika za pomocą funkcji porównawczych. Narzędzie może wyróżniać konkretne wzorce w tekstach wygenerowanych przez modele, co ułatwia zrozumienie różnic między nimi.

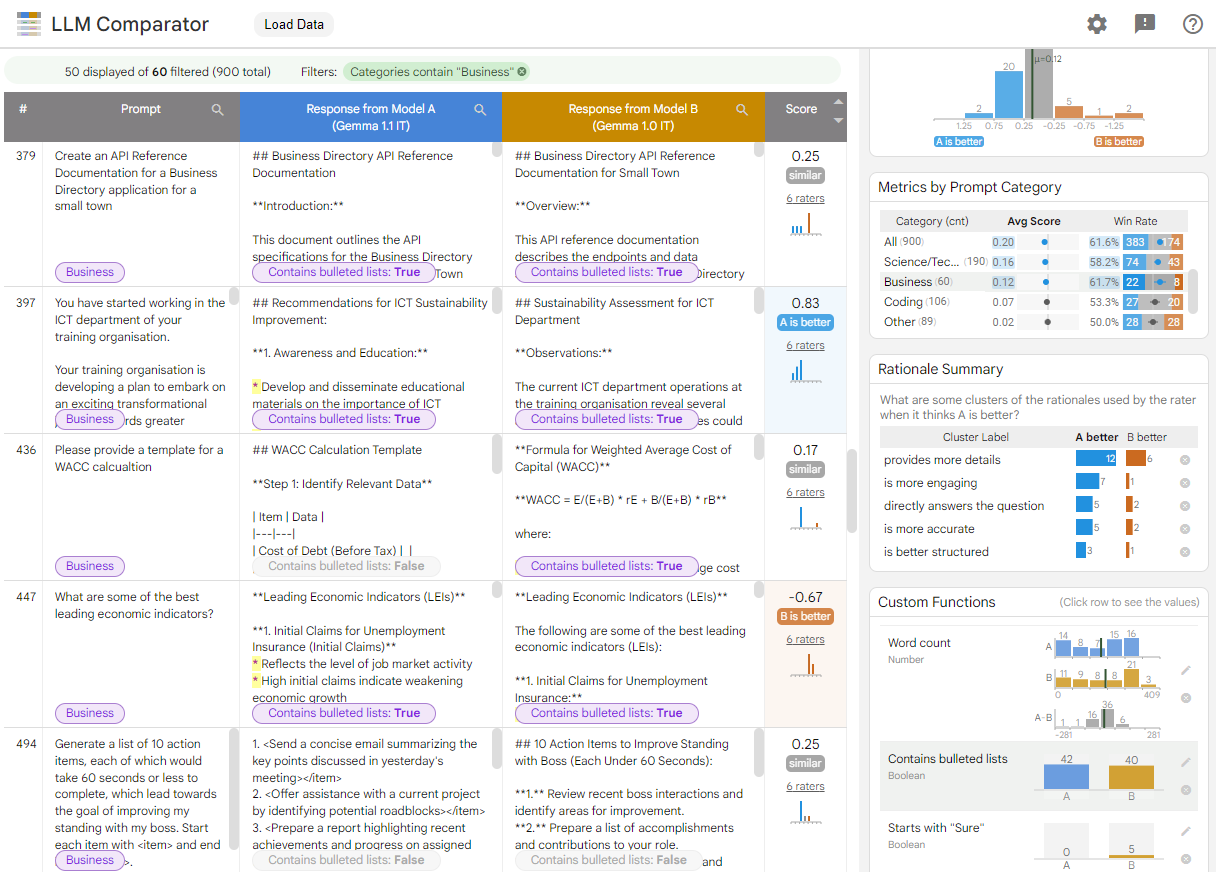

Rysunek 1. Interfejs porównania LLM przedstawiający porównanie Gemmy Pokazuj model 7B w wersji 1.1 w porównaniu z wersją 1.0

LLM Comarator pomaga analizować wyniki oceny równoległej. Podaje on wizualnie skuteczność modelu z różnych perspektyw i pozwala interaktywnie sprawdzać poszczególne dane wyjściowe modelu, aby lepiej zrozumieć jego działanie.

Poznaj komparator LLM:

- Ta prezentacja porównuje wydajność Gemma Instruct 7B w wersji 1.1 z wydajnością Gemma Instruct 7B w wersji 1.0 na zbiorze danych Chatbot Arena Conversations.

- Ten notatnik Colab używa biblioteki Pythona do uruchamiania do oceny równoległej za pomocą interfejsu Vertex AI API i wczytuje tag do aplikacji LLM Comarator w komórce.

Więcej informacji o LLM Comparator znajdziesz w artykule naukowym i repozytorium GitHub.