La valutazione affiancata è emersa come una strategia comune per valutare la qualità e la sicurezza delle risposte dei modelli linguistici di grandi dimensioni (LLM). I confronti affiancati possono essere utilizzati per scegliere tra due modelli diversi, due prompt diversi per lo stesso modello o anche due ottimizzazioni diverse di un modello. Tuttavia, l'analisi manuale dei risultati del confronto fianco a fianco può essere laboriosa e tediosa.

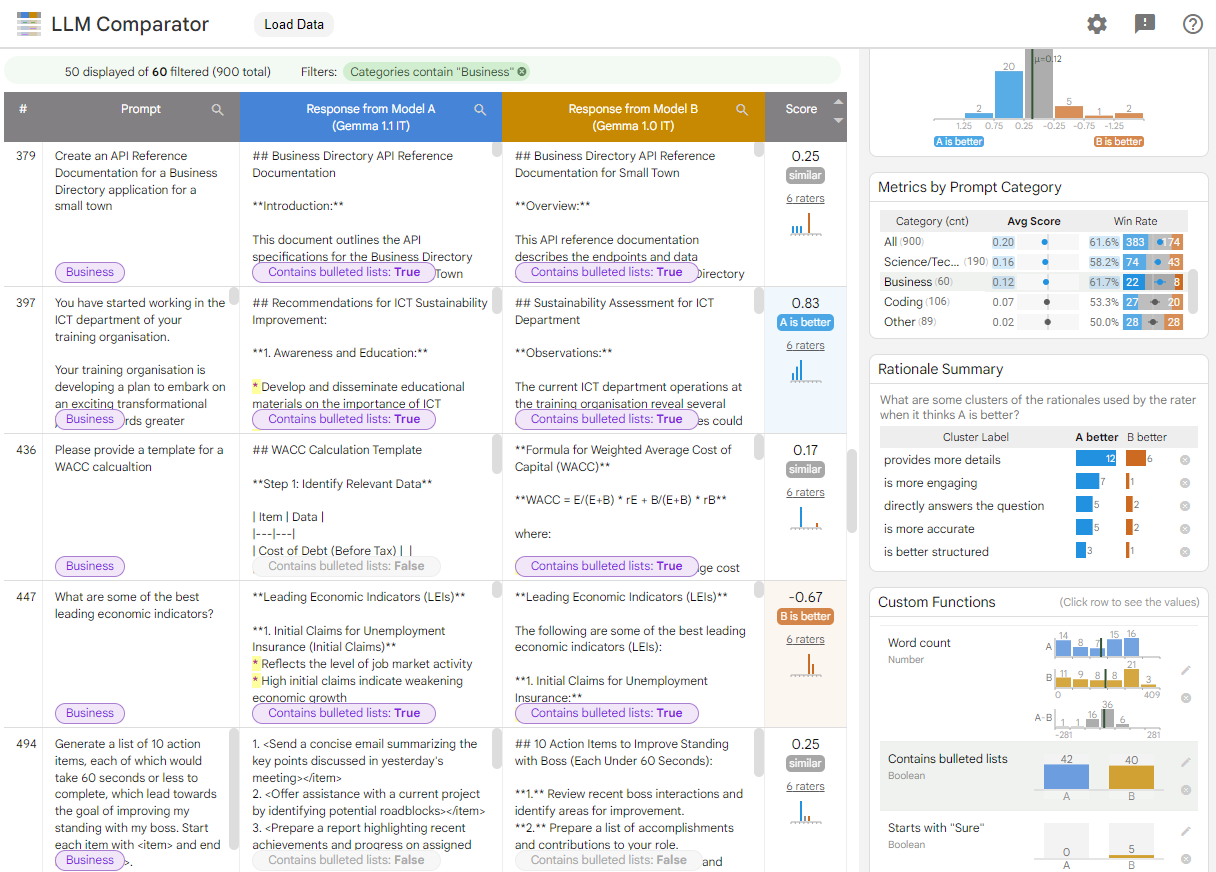

Il comparatore LLM è un'app web con una libreria Python complementare che consente un'analisi più efficace e scalabile delle valutazioni affiancate con visualizzazioni interattive. LLM Comparator ti aiuta a:

Scopri dove differiscono le prestazioni del modello: puoi suddividere le risposte per identificare sottoinsiemi di dati di valutazione in cui genera risultati differiscono tra i due modelli.

Scopri perché è diverso: è comune avere delle norme in base alle quali vengono valutate le prestazioni e la conformità del modello. La valutazione affiancata consente di automatizzare la conformità ai criteri di valutazione e fornisce le motivazioni per cui è più probabile che si tratti di un modello conforme. LLM Comparator riassume questi motivi in diversi temi e evidenzia quale modello è più in linea con ogni tema.

Esamina in che modo gli output dei modelli differiscono: puoi esaminare ulteriormente le differenze tra gli output di due modelli tramite funzioni di confronto predefinite e integrate. Lo strumento può evidenziare pattern specifici nel testo generati, fornendo un chiaro ancoraggio per capire le differenze.

Figura 1. Interfaccia LLM Comparator che mostra un confronto dei modelli Istruisci il modello 7B v1.1 rispetto alla versione v1.0

LLM Comparator ti aiuta ad analizzare i risultati della valutazione affiancata. it riassume visivamente le prestazioni del modello da più angolazioni, consentendoti ispezionare in modo interattivo gli output dei singoli modelli per una comprensione più approfondita.

Esplora LLM Comparator in prima persona:

- Questa demo confronta le prestazioni di Gemma Instruct 7B v1.1 con quelle di Gemma Instruct 7B v1.0 sul set di dati Chatbot Arena Conversations.

- Questo blocco note di Colab utilizza la libreria Python per eseguire una la valutazione affiancata utilizzando l'API Vertex AI e carica restituisce l'app LLM Comparator in una cella.

Per saperne di più su LLM Comparator, consulta il paper di ricerca e il repository GitHub.