La tâche MediaPipe Hand Landmarker vous permet de détecter les points de repère des mains dans une image. Ces instructions vous expliquent comment utiliser le repère de la main avec des applications iOS. L'exemple de code décrit dans ces instructions est disponible sur GitHub.

Pour en savoir plus sur les fonctionnalités, les modèles et les options de configuration de cette tâche, consultez la section Présentation.

Exemple de code

L'exemple de code MediaPipe Tasks est une implémentation de base d'une application de repère de main pour iOS. L'exemple utilise l'appareil photo d'un appareil iOS physique pour détecter des repères de la main dans un flux vidéo continu. L'application peut également détecter des repères de la main dans les images et les vidéos de la galerie de l'appareil.

Vous pouvez utiliser l'application comme point de départ pour votre propre application iOS ou vous y référer lorsque vous modifiez une application existante. L'exemple de code du repère manuel est hébergé sur GitHub.

Télécharger le code

Les instructions suivantes vous expliquent comment créer une copie locale de l'exemple de code à l'aide de l'outil de ligne de commande git.

Pour télécharger l'exemple de code:

Clonez le dépôt Git à l'aide de la commande suivante:

git clone https://github.com/google-ai-edge/mediapipe-samplesVous pouvez éventuellement configurer votre instance git pour qu'elle utilise un "checkout" clairsemé afin de n'avoir que les fichiers de l'application exemple Hand Landmarker:

cd mediapipe-samples git sparse-checkout init --cone git sparse-checkout set examples/hand_landmarker/ios/

Après avoir créé une version locale de l'exemple de code, vous pouvez installer la bibliothèque de tâches MediaPipe, ouvrir le projet à l'aide de Xcode et exécuter l'application. Pour obtenir des instructions, consultez le guide de configuration pour iOS.

Composants clés

Les fichiers suivants contiennent le code essentiel de l'application exemple Hand Landmarker:

- HandLandmarkerService.swift : initialise le repère manuel, gère la sélection du modèle et exécute l'inférence sur les données d'entrée.

- CameraViewController.swift : implémente l'UI pour le mode d'entrée du flux vidéo en direct de la caméra et visualise les résultats.

- MediaLibraryViewController.swift : implémente l'UI pour le mode d'importation d'images fixes et de fichiers vidéo, et visualise les résultats.

Configuration

Cette section décrit les étapes clés à suivre pour configurer votre environnement de développement et vos projets de code afin d'utiliser Hand Landmarker. Pour obtenir des informations générales sur la configuration de votre environnement de développement pour utiliser les tâches MediaPipe, y compris les exigences concernant les versions de la plate-forme, consultez le guide de configuration pour iOS.

Dépendances

Hand Landmarker utilise la bibliothèque MediaPipeTasksVision, qui doit être installée à l'aide de CocoaPods. La bibliothèque est compatible avec les applications Swift et Objective-C, et ne nécessite aucune configuration supplémentaire spécifique à la langue.

Pour savoir comment installer CocoaPods sur macOS, consultez le guide d'installation de CocoaPods.

Pour savoir comment créer un Podfile avec les pods nécessaires à votre application, consultez la section Utiliser CocoaPods.

Ajoutez le pod MediaPipeTasksVision dans Podfile à l'aide du code suivant:

target 'MyHandLandmarkerApp' do

use_frameworks!

pod 'MediaPipeTasksVision'

end

Si votre application inclut des cibles de test unitaire, consultez le guide de configuration pour iOS pour en savoir plus sur la configuration de votre Podfile.

Modèle

La tâche de repère de la main MediaPipe nécessite un modèle entraîné compatible avec cette tâche. Pour en savoir plus sur les modèles entraînés disponibles pour Hand Landmarker, consultez la section Modèles de la présentation de la tâche.

Sélectionnez et téléchargez un modèle, puis ajoutez-le au répertoire de votre projet à l'aide de Xcode. Pour savoir comment ajouter des fichiers à votre projet Xcode, consultez Gérer les fichiers et les dossiers dans votre projet Xcode.

Utilisez la propriété BaseOptions.modelAssetPath pour spécifier le chemin d'accès au modèle dans votre app bundle. Pour obtenir un exemple de code, consultez la section suivante.

Créer la tâche

Vous pouvez créer la tâche de repère de la main en appelant l'un de ses initialiseurs. L'initialiseur HandLandmarker(options:) accepte les valeurs des options de configuration.

Si vous n'avez pas besoin d'un repère manuel initialisé avec des options de configuration personnalisées, vous pouvez utiliser l'initialiseur HandLandmarker(modelPath:) pour créer un repère manuel avec les options par défaut. Pour en savoir plus sur les options de configuration, consultez la section Présentation de la configuration.

La tâche de repère de la main accepte trois types de données d'entrée: les images fixes, les fichiers vidéo et les flux vidéo en direct. Par défaut, HandLandmarker(modelPath:) initialise une tâche pour les images fixes. Si vous souhaitez que votre tâche soit initialisée pour traiter des fichiers vidéo ou des flux vidéo en direct, utilisez HandLandmarker(options:) pour spécifier le mode d'exécution de la vidéo ou de la diffusion en direct. Le mode de diffusion en direct nécessite également l'option de configuration handLandmarkerLiveStreamDelegate supplémentaire, qui permet au repère manuel de transmettre les résultats du repère manuel au délégué de manière asynchrone.

Sélectionnez l'onglet correspondant à votre mode d'exécution pour découvrir comment créer la tâche et exécuter l'inférence.

Swift

Image

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .image options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands let handLandmarker = try HandLandmarker(options: options)

Vidéo

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .video options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands let handLandmarker = try HandLandmarker(options: options)

Diffusion en direct

import MediaPipeTasksVision // Class that conforms to the `HandLandmarkerLiveStreamDelegate` protocol and // implements the method that the hand landmarker calls once it finishes // performing landmarks detection in each input frame. class HandLandmarkerResultProcessor: NSObject, HandLandmarkerLiveStreamDelegate { func handLandmarker( _ handLandmarker: HandLandmarker, didFinishDetection result: HandLandmarkerResult?, timestampInMilliseconds: Int, error: Error?) { // Process the hand landmarker result or errors here. } } let modelPath = Bundle.main.path( forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .liveStream options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands // Assign an object of the class to the `handLandmarkerLiveStreamDelegate` // property. let processor = HandLandmarkerResultProcessor() options.handLandmarkerLiveStreamDelegate = processor let handLandmarker = try HandLandmarker(options: options)

Objective-C

Image

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeImage; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Vidéo

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeVideo; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Diffusion en direct

@import MediaPipeTasksVision; // Class that conforms to the `MPPHandLandmarkerLiveStreamDelegate` protocol // and implements the method that the hand landmarker calls once it finishes // performing landmarks detection in each input frame. @interface APPHandLandmarkerResultProcessor : NSObject@end @implementation APPHandLandmarkerResultProcessor - (void)handLandmarker:(MPPHandLandmarker *)handLandmarker didFinishDetectionWithResult:(MPPHandLandmarkerResult *)handLandmarkerResult timestampInMilliseconds:(NSInteger)timestampInMilliseconds error:(NSError *)error { // Process the hand landmarker result or errors here. } @end NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeLiveStream; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; // Assign an object of the class to the `handLandmarkerLiveStreamDelegate` // property. APPHandLandmarkerResultProcessor *processor = [APPHandLandmarkerResultProcessor new]; options.handLandmarkerLiveStreamDelegate = processor; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Options de configuration

Cette tâche propose les options de configuration suivantes pour les applications iOS:

| Nom de l'option | Description | Plage de valeurs | Valeur par défaut |

|---|---|---|---|

running_mode |

Définit le mode d'exécution de la tâche. Il existe trois modes: IMAGE: mode pour les entrées d'une seule image. VIDEO: mode des images décodées d'une vidéo. LIVE_STREAM: mode de diffusion en direct des données d'entrée, par exemple à partir d'une caméra. Dans ce mode, resultListener doit être appelé pour configurer un écouteur afin de recevoir les résultats de manière asynchrone. Dans ce mode, handLandmarkerLiveStreamDelegate doit être défini sur une instance d'une classe qui implémente HandLandmarkerLiveStreamDelegate pour recevoir les résultats de la détection des repères de la main de manière asynchrone.

|

{RunningMode.image, RunningMode.video, RunningMode.liveStream} |

RunningMode.image |

numHands |

Nombre maximal de mains détectées par le détecteur de repères de main. | Any integer > 0 |

1 |

minHandDetectionConfidence |

Score de confiance minimal pour que la détection de la main soit considérée comme réussie dans le modèle de détection de la paume de la main. | 0.0 - 1.0 |

0.5 |

minHandPresenceConfidence |

Score de confiance minimal pour le score de présence de la main dans le modèle de détection des repères de la main. En mode Vidéo et en mode Diffusion en direct, si le score de confiance de la présence de la main du modèle de repères de la main est inférieur à ce seuil, le repère de la main déclenche le modèle de détection de la paume. Sinon, un algorithme de suivi des mains léger détermine l'emplacement de la ou des mains pour les détections de repères ultérieures. | 0.0 - 1.0 |

0.5 |

minTrackingConfidence |

Score de confiance minimal pour que le suivi des mains soit considéré comme réussi. Il s'agit du seuil d'IoU du cadre de délimitation entre les mains dans le frame actuel et le dernier frame. En mode Vidéo et en mode Flux de Hand Landmarker, si le suivi échoue, Hand Landmarker déclenche la détection de la main. Dans le cas contraire, la détection de la main est ignorée. | 0.0 - 1.0 |

0.5 |

result_listener |

Définit l'écouteur de résultats pour qu'il reçoive les résultats de détection de manière asynchrone lorsque le repère de la main est en mode diffusion en direct.

Uniquement applicable lorsque le mode d'exécution est défini sur LIVE_STREAM |

N/A | N/A |

Lorsque le mode d'exécution est défini sur "Streaming en direct", le repère manuel nécessite l'option de configuration handLandmarkerLiveStreamDelegate supplémentaire, qui permet au repère manuel de fournir des résultats de détection de repères manuels de manière asynchrone. Le délégué doit implémenter la méthode handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:), que le détecteur de repères manuels appelle après avoir traité les résultats de détection des repères manuels pour chaque frame.

| Nom de l'option | Description | Plage de valeurs | Valeur par défaut |

|---|---|---|---|

handLandmarkerLiveStreamDelegate |

Permet à Hand Landmarker de recevoir les résultats de la détection des repères manuels de manière asynchrone en mode diffusion en direct. La classe dont l'instance est définie sur cette propriété doit implémenter la méthode handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:). |

Non applicable | Non défini |

Préparer les données

Vous devez convertir l'image ou le frame d'entrée en objet MPImage avant de le transmettre au repère manuel. MPImage est compatible avec différents types de formats d'images iOS et peut les utiliser dans n'importe quel mode d'exécution pour l'inférence. Pour en savoir plus sur MPImage, consultez l'API MPImage.

Choisissez un format d'image iOS en fonction de votre cas d'utilisation et du mode d'exécution requis par votre application.MPImage accepte les formats d'image iOS UIImage, CVPixelBuffer et CMSampleBuffer.

UIImage

Le format UIImage est adapté aux modes d'exécution suivants:

Images: les images d'un bundle d'application, d'une galerie utilisateur ou d'un système de fichiers au format

UIImagepeuvent être converties en objetMPImage.Vidéos: utilisez AVAssetImageGenerator pour extraire les images vidéo au format CGImage, puis les convertir en images

UIImage.

Swift

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(uiImage: image)

Objective-C

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

L'exemple initialise un MPImage avec l'orientation par défaut UIImage.Orientation.Up. Vous pouvez initialiser un MPImage avec l'une des valeurs UIImage.Orientation acceptées. Le repère de la main n'est pas compatible avec les orientations en miroir telles que .upMirrored, .downMirrored, .leftMirrored et .rightMirrored.

Pour en savoir plus sur UIImage, consultez la documentation pour les développeurs Apple sur UIImage.

CVPixelBuffer

Le format CVPixelBuffer est adapté aux applications qui génèrent des frames et utilisent le framework CoreImage iOS pour le traitement.

Le format CVPixelBuffer est adapté aux modes d'exécution suivants:

Images: les applications qui génèrent des images

CVPixelBufferaprès un traitement à l'aide du frameworkCoreImaged'iOS peuvent être envoyées au repère manuel en mode d'exécution de l'image.Vidéos: les images vidéo peuvent être converties au format

CVPixelBufferpour le traitement, puis envoyées au repère manuel en mode vidéo.streaming en direct: les applications qui utilisent une caméra iOS pour générer des images peuvent être converties au format

CVPixelBufferpour le traitement avant d'être envoyées au repère de la main en mode streaming en direct.

Swift

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(pixelBuffer: pixelBuffer)

Objective-C

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

Pour en savoir plus sur CVPixelBuffer, consultez la documentation pour les développeurs Apple sur CVPixelBuffer.

CMSampleBuffer

Le format CMSampleBuffer stocke des échantillons multimédias d'un type multimédia uniforme et est adapté au mode d'exécution de la diffusion en direct. Les images en direct des caméras iOS sont transmises de manière asynchrone au format CMSampleBuffer par AVCaptureVideoDataOutput sur iOS.

Swift

// Obtain a CMSampleBuffer. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(sampleBuffer: sampleBuffer)

Objective-C

// Obtain a `CMSampleBuffer`. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithSampleBuffer:sampleBuffer error:nil];

Pour en savoir plus sur CMSampleBuffer, consultez la documentation pour les développeurs Apple sur CMSampleBuffer.

Exécuter la tâche

Pour exécuter le repère de la main, utilisez la méthode detect() spécifique au mode d'exécution attribué:

- Image fixe:

detect(image:) - Vidéo :

detect(videoFrame:timestampInMilliseconds:) - Diffusion en direct :

detectAsync(image:timestampInMilliseconds:)

Swift

Image

let result = try handLandmarker.detect(image: image)

Vidéo

let result = try handLandmarker.detect(

videoFrame: image,

timestampInMilliseconds: timestamp)

Diffusion en direct

try handLandmarker.detectAsync(

image: image,

timestampInMilliseconds: timestamp)

Objective-C

Image

MPPHandLandmarkerResult *result = [handLandmarker detectInImage:image error:nil];

Vidéo

MPPHandLandmarkerResult *result = [handLandmarker detectInVideoFrame:image timestampInMilliseconds:timestamp error:nil];

Diffusion en direct

BOOL success = [handLandmarker detectAsyncInImage:image timestampInMilliseconds:timestamp error:nil];

L'exemple de code du repère de main montre plus en détail les implémentations de chacun de ces modes. L'exemple de code permet à l'utilisateur de basculer entre les modes de traitement, ce qui n'est peut-être pas nécessaire pour votre cas d'utilisation.

Veuillez noter les points suivants :

Lorsque vous exécutez le mode vidéo ou le mode diffusion en direct, vous devez également fournir le code temporel du frame d'entrée à la tâche de repère de la main.

Lorsqu'elle s'exécute en mode image ou vidéo, la tâche de repère de la main bloque le thread actuel jusqu'à ce qu'elle ait terminé de traiter l'image ou le frame d'entrée. Pour éviter de bloquer le thread actuel, exécutez le traitement dans un thread en arrière-plan à l'aide des frameworks iOS Dispatch ou NSOperation.

En mode diffusion en direct, la tâche de repère de la main renvoie immédiatement et ne bloque pas le thread en cours. Il appelle la méthode

handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:)avec le résultat du repère de la main après avoir traité chaque frame d'entrée. Le repère de la main appelle cette méthode de manière asynchrone sur une file d'attente de distribution série dédiée. Pour afficher les résultats dans l'interface utilisateur, distribuez-les dans la file d'attente principale après les avoir traités. Si la fonctiondetectAsyncest appelée lorsque la tâche de repère manuel est occupée à traiter un autre frame, le repère manuel ignore le nouveau frame d'entrée.

Gérer et afficher les résultats

Lors de l'exécution de l'inférence, la tâche de repère de la main renvoie un HandLandmarkerResult contenant des repères de la main en coordonnées d'image, des repères de la main en coordonnées mondiales et la latéralité(main gauche/droite) des mains détectées.

Voici un exemple des données de sortie de cette tâche:

La sortie HandLandmarkerResult contient trois composants. Chaque composant est un tableau, où chaque élément contient les résultats suivants pour une seule main détectée:

Main dominante

La maniabilité indique si les mains détectées sont des mains gauches ou droites.

Points de repère

Il existe 21 repères de la main, chacun composé de coordonnées

x,yetz. Les coordonnéesxetysont normalisées à [0,0, 1,0] par la largeur et la hauteur de l'image, respectivement. La coordonnéezreprésente la profondeur du repère, la profondeur au poignet étant l'origine. Plus la valeur est faible, plus le repère est proche de la caméra. L'ampleur dezutilise à peu près la même échelle quex.Monuments du monde

Les 21 repères de la main sont également présentés en coordonnées mondiales. Chaque repère est composé de

x,yetz, qui représentent des coordonnées 3D réelles en mètres, avec l'origine au centre géométrique de la main.

HandLandmarkerResult:

Handedness:

Categories #0:

index : 0

score : 0.98396

categoryName : Left

Landmarks:

Landmark #0:

x : 0.638852

y : 0.671197

z : -3.41E-7

Landmark #1:

x : 0.634599

y : 0.536441

z : -0.06984

... (21 landmarks for a hand)

WorldLandmarks:

Landmark #0:

x : 0.067485

y : 0.031084

z : 0.055223

Landmark #1:

x : 0.063209

y : -0.00382

z : 0.020920

... (21 world landmarks for a hand)

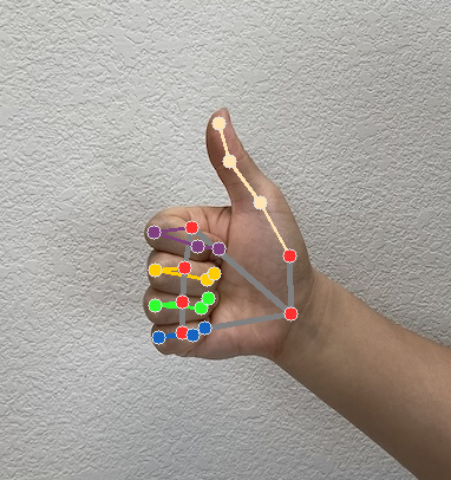

L'image suivante présente une visualisation du résultat de la tâche: