Задача MediaPipe Hand Landmarker позволяет обнаруживать ориентиры рук на изображении. В этих инструкциях показано, как использовать Hand Landmarker с приложениями iOS. Пример кода, описанный в этой инструкции, доступен на GitHub .

Дополнительные сведения о возможностях, моделях и параметрах конфигурации этой задачи см. в разделе Обзор .

Пример кода

Пример кода задач MediaPipe — это базовая реализация приложения Hand Landmarker для iOS. В примере используется камера на физическом устройстве iOS для обнаружения ориентиров в виде рук в непрерывном видеопотоке. Приложение также может обнаруживать ориентиры рук на изображениях и видео из галереи устройства.

Вы можете использовать это приложение в качестве отправной точки для своего собственного приложения для iOS или обращаться к нему при изменении существующего приложения. Пример кода Hand Landmarker размещен на GitHub .

Загрузите код

Следующие инструкции показывают, как создать локальную копию кода примера с помощью инструмента командной строки git .

Чтобы загрузить пример кода:

Клонируйте репозиторий git, используя следующую команду:

git clone https://github.com/google-ai-edge/mediapipe-samplesПри желании настройте свой экземпляр git на использование разреженной проверки, чтобы у вас были только файлы для примера приложения Hand Landmarker:

cd mediapipe-samples git sparse-checkout init --cone git sparse-checkout set examples/hand_landmarker/ios/

После создания локальной версии примера кода вы можете установить библиотеку задач MediaPipe, открыть проект с помощью Xcode и запустить приложение. Инструкции см. в Руководстве по установке для iOS .

Ключевые компоненты

Следующие файлы содержат ключевой код для примера приложения Hand Landmarker:

- HandLandmarkerService.swift : инициализирует Hand Landmarker, обрабатывает выбор модели и выполняет логический вывод на основе входных данных.

- CameraViewController.swift : реализует пользовательский интерфейс для режима ввода изображения с камеры в реальном времени и визуализирует результаты.

- MediaLibraryViewController.swift : реализует пользовательский интерфейс для режима ввода неподвижных изображений и видеофайлов и визуализирует результаты.

Настраивать

В этом разделе описаны ключевые шаги по настройке среды разработки и проектов кода для использования Hand Landmarker. Общие сведения о настройке среды разработки для использования задач MediaPipe, включая требования к версии платформы, см. в руководстве по настройке для iOS .

Зависимости

Hand Landmarker использует библиотеку MediaPipeTasksVision , которую необходимо установить с помощью CocoaPods. Библиотека совместима с приложениями Swift и Objective-C и не требует дополнительной настройки для конкретного языка.

Инструкции по установке CocoaPods на macOS см. в руководстве по установке CocoaPods . Инструкции о том, как создать Podfile с необходимыми модулями для вашего приложения, см. в разделе Использование CocoaPods .

Добавьте модуль MediaPipeTasksVision в Podfile используя следующий код:

target 'MyHandLandmarkerApp' do

use_frameworks!

pod 'MediaPipeTasksVision'

end

Если ваше приложение включает в себя цели модульного тестирования, обратитесь к Руководству по настройке для iOS для получения дополнительной информации о настройке вашего Podfile .

Модель

Для задачи MediaPipe Hand Landmarker требуется обученная модель, совместимая с этой задачей. Дополнительную информацию о доступных обученных моделях для Hand Landmarker смотрите в разделе «Модели обзора задач».

Выберите и загрузите модель и добавьте ее в каталог проекта с помощью Xcode. Инструкции по добавлению файлов в проект Xcode см. в разделе Управление файлами и папками в проекте Xcode .

Используйте свойство BaseOptions.modelAssetPath , чтобы указать путь к модели в вашем пакете приложений. Пример кода см. в следующем разделе.

Создать задачу

Вы можете создать задачу Hand Landmarker, вызвав один из ее инициализаторов. Инициализатор HandLandmarker(options:) принимает значения для параметров конфигурации.

Если вам не нужен Hand Landmarker, инициализированный с настраиваемыми параметрами конфигурации, вы можете использовать инициализатор HandLandmarker(modelPath:) для создания Hand Landmarker с параметрами по умолчанию. Дополнительные сведения о параметрах конфигурации см. в разделе Обзор конфигурации .

Задача Hand Landmarker поддерживает 3 типа входных данных: неподвижные изображения, видеофайлы и прямые видеопотоки. По умолчанию HandLandmarker(modelPath:) инициализирует задачу для неподвижных изображений. Если вы хотите, чтобы ваша задача была инициализирована для обработки видеофайлов или прямых видеопотоков, используйте HandLandmarker(options:) чтобы указать режим работы видео или прямой трансляции. Для режима прямой трансляции также требуется дополнительный параметр конфигурации handLandmarkerLiveStreamDelegate , который позволяет Hand Landmarker асинхронно доставлять делегату результаты ручного ориентира.

Выберите вкладку, соответствующую вашему режиму работы, чтобы узнать, как создать задачу и выполнить вывод.

Быстрый

Изображение

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .image options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands let handLandmarker = try HandLandmarker(options: options)

Видео

import MediaPipeTasksVision let modelPath = Bundle.main.path(forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .video options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands let handLandmarker = try HandLandmarker(options: options)

Прямая трансляция

import MediaPipeTasksVision // Class that conforms to the `HandLandmarkerLiveStreamDelegate` protocol and // implements the method that the hand landmarker calls once it finishes // performing landmarks detection in each input frame. class HandLandmarkerResultProcessor: NSObject, HandLandmarkerLiveStreamDelegate { func handLandmarker( _ handLandmarker: HandLandmarker, didFinishDetection result: HandLandmarkerResult?, timestampInMilliseconds: Int, error: Error?) { // Process the hand landmarker result or errors here. } } let modelPath = Bundle.main.path( forResource: "hand_landmarker", ofType: "task") let options = HandLandmarkerOptions() options.baseOptions.modelAssetPath = modelPath options.runningMode = .liveStream options.minHandDetectionConfidence = minHandDetectionConfidence options.minHandPresenceConfidence = minHandPresenceConfidence options.minTrackingConfidence = minHandTrackingConfidence options.numHands = numHands // Assign an object of the class to the `handLandmarkerLiveStreamDelegate` // property. let processor = HandLandmarkerResultProcessor() options.handLandmarkerLiveStreamDelegate = processor let handLandmarker = try HandLandmarker(options: options)

Цель-C

Изображение

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeImage; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Видео

@import MediaPipeTasksVision; NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeVideo; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Прямая трансляция

@import MediaPipeTasksVision; // Class that conforms to the `MPPHandLandmarkerLiveStreamDelegate` protocol // and implements the method that the hand landmarker calls once it finishes // performing landmarks detection in each input frame. @interface APPHandLandmarkerResultProcessor : NSObject@end @implementation APPHandLandmarkerResultProcessor - (void)handLandmarker:(MPPHandLandmarker *)handLandmarker didFinishDetectionWithResult:(MPPHandLandmarkerResult *)handLandmarkerResult timestampInMilliseconds:(NSInteger)timestampInMilliseconds error:(NSError *)error { // Process the hand landmarker result or errors here. } @end NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"hand_landmarker" ofType:@"task"]; MPPHandLandmarkerOptions *options = [[MPPHandLandmarkerOptions alloc] init]; options.baseOptions.modelAssetPath = modelPath; options.runningMode = MPPRunningModeLiveStream; options.minHandDetectionConfidence = minHandDetectionConfidence; options.minHandPresenceConfidence = minHandPresenceConfidence; options.minTrackingConfidence = minHandTrackingConfidence; options.numHands = numHands; // Assign an object of the class to the `handLandmarkerLiveStreamDelegate` // property. APPHandLandmarkerResultProcessor *processor = [APPHandLandmarkerResultProcessor new]; options.handLandmarkerLiveStreamDelegate = processor; MPPHandLandmarker *handLandmarker = [[MPPHandLandmarker alloc] initWithOptions:options error:nil];

Варианты конфигурации

Эта задача имеет следующие параметры конфигурации для приложений iOS:

| Название опции | Описание | Диапазон значений | Значение по умолчанию |

|---|---|---|---|

running_mode | Устанавливает режим выполнения задачи. Есть три режима: ИЗОБРАЖЕНИЕ: Режим для ввода одного изображения. ВИДЕО: Режим декодированных кадров видео. LIVE_STREAM: режим прямой трансляции входных данных, например, с камеры. В этом режиме необходимо вызвать resultListener, чтобы настроить прослушиватель на асинхронное получение результатов. В этом режиме handLandmarkerLiveStreamDelegate должен быть установлен экземпляр класса, который реализует HandLandmarkerLiveStreamDelegate , чтобы асинхронно получать результаты обнаружения ориентиров руки. | { RunningMode.image, RunningMode.video, RunningMode.liveStream } | RunningMode.image |

numHands | Максимальное количество рук, обнаруженных детектором ориентиров рук. | Any integer > 0 | 1 |

minHandDetectionConfidence | Минимальный показатель достоверности, позволяющий считать обнаружение рук успешным в модели обнаружения ладоней. | 0.0 - 1.0 | 0.5 |

minHandPresenceConfidence | Минимальная оценка достоверности для оценки присутствия руки в модели обнаружения ориентиров руки. В режиме «Видео» и режиме прямой трансляции, если показатель достоверности присутствия руки из модели ориентира руки ниже этого порога, Hand Landmarker запускает модель обнаружения ладони. В противном случае упрощенный алгоритм отслеживания рук определяет местоположение руки (рук) для последующего обнаружения ориентиров. | 0.0 - 1.0 | 0.5 |

minTrackingConfidence | Минимальный показатель достоверности, позволяющий считать отслеживание рук успешным. Это порог IoU ограничивающей рамки между руками в текущем кадре и последнем кадре. В режиме видео и потоковом режиме Hand Landmarker, если отслеживание не удается, Hand Landmarker запускает обнаружение руки. В противном случае обнаружение руки будет пропущено. | 0.0 - 1.0 | 0.5 |

result_listener | Настраивает прослушиватель результатов на асинхронное получение результатов обнаружения, когда ручной ориентир находится в режиме прямой трансляции. Применимо только в том случае, если для режима работы установлено значение LIVE_STREAM | Н/Д | Н/Д |

Если в качестве режима работы выбрана прямая трансляция, для Hand Landmarker требуется дополнительный параметр конфигурации handLandmarkerLiveStreamDelegate , который позволяет Hand Landmarker асинхронно доставлять результаты обнаружения ориентиров вручную. Делегат должен реализовать метод handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:) , который Hand Landmarker вызывает после обработки результатов обнаружения ориентиров рук для каждого кадра.

| Название опции | Описание | Диапазон значений | Значение по умолчанию |

|---|---|---|---|

handLandmarkerLiveStreamDelegate | Позволяет Hand Landmarker асинхронно получать результаты обнаружения ориентиров в режиме прямой трансляции. Класс, экземпляру которого присвоено это свойство, должен реализовать handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:) . | Непригодный | Не установлено |

Подготовьте данные

Вам необходимо преобразовать входное изображение или кадр в объект MPImage перед передачей его в Hand Landmarker. MPImage поддерживает различные типы форматов изображений iOS и может использовать их в любом рабочем режиме для вывода. Для получения дополнительной информации о MPImage обратитесь к MPImage API .

Выберите формат изображения iOS в зависимости от вашего варианта использования и режима работы, который требуется вашему приложению. MPImage принимает форматы изображений iOS UIImage , CVPixelBuffer и CMSampleBuffer .

UIImage

Формат UIImage хорошо подходит для следующих режимов работы:

Изображения: изображения из пакета приложения, пользовательской галереи или файловой системы, отформатированные как изображения

UIImageможно преобразовать в объектMPImage.Видео: используйте AVAssetImageGenerator для извлечения видеокадров в формат CGImage , а затем преобразуйте их в изображения

UIImage.

Быстрый

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(uiImage: image)

Цель-C

// Load an image on the user's device as an iOS `UIImage` object. // Convert the `UIImage` object to a MediaPipe's Image object having the default // orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

В примере инициализируется MPImage с ориентацией UIImage.Orientation.Up по умолчанию. Вы можете инициализировать MPImage любым из поддерживаемых значений UIImage.Orientation . Hand Landmarker не поддерживает зеркальные ориентации, такие как .upMirrored , .downMirrored , .leftMirrored , .rightMirrored .

Для получения дополнительной информации о UIImage обратитесь к документации UIImage Apple Developer Documentation .

CVPixelBuffer

Формат CVPixelBuffer хорошо подходит для приложений, генерирующих кадры и использующих для обработки платформу iOS CoreImage .

Формат CVPixelBuffer хорошо подходит для следующих режимов работы:

Изображения: приложения, которые генерируют изображения

CVPixelBufferпосле некоторой обработки с использованием платформы iOSCoreImage, могут быть отправлены в Hand Landmarker в режиме работы изображения.Видео: видеокадры можно конвертировать в формат

CVPixelBufferдля обработки, а затем отправлять в Hand Landmarker в видеорежиме.прямая трансляция: приложения, использующие камеру iOS для создания кадров, могут быть преобразованы в формат

CVPixelBufferдля обработки перед отправкой на Hand Landmarker в режиме прямой трансляции.

Быстрый

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(pixelBuffer: pixelBuffer)

Цель-C

// Obtain a CVPixelBuffer. // Convert the `CVPixelBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithUIImage:image error:nil];

Дополнительные сведения о CVPixelBuffer см. в документации разработчика Apple CVPixelBuffer .

CMSampleBuffer

Формат CMSampleBuffer хранит образцы мультимедиа единого типа и хорошо подходит для режима прямой трансляции. Кадры в реальном времени с камер iOS асинхронно доставляются в формате CMSampleBuffer с помощью iOS AVCaptureVideoDataOutput .

Быстрый

// Obtain a CMSampleBuffer. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the default // orientation `UIImage.Orientation.up`. let image = try MPImage(sampleBuffer: sampleBuffer)

Цель-C

// Obtain a `CMSampleBuffer`. // Convert the `CMSampleBuffer` object to a MediaPipe's Image object having the // default orientation `UIImageOrientationUp`. MPImage *image = [[MPPImage alloc] initWithSampleBuffer:sampleBuffer error:nil];

Дополнительные сведения о CMSampleBuffer см. в документации CMSampleBuffer Apple для разработчиков .

Запустить задачу

Чтобы запустить Hand Landmarker, используйте метод detect() специфичный для назначенного режима бега:

- Неподвижное изображение:

detect(image:) - Видео:

detect(videoFrame:timestampInMilliseconds:) - Прямая трансляция:

detectAsync(image:timestampInMilliseconds:)

Быстрый

Изображение

let result = try handLandmarker.detect(image: image)

Видео

let result = try handLandmarker.detect(

videoFrame: image,

timestampInMilliseconds: timestamp)

Прямая трансляция

try handLandmarker.detectAsync(

image: image,

timestampInMilliseconds: timestamp)

Цель-C

Изображение

MPPHandLandmarkerResult *result = [handLandmarker detectInImage:image error:nil];

Видео

MPPHandLandmarkerResult *result = [handLandmarker detectInVideoFrame:image timestampInMilliseconds:timestamp error:nil];

Прямая трансляция

BOOL success = [handLandmarker detectAsyncInImage:image timestampInMilliseconds:timestamp error:nil];

В примере кода Hand Landmarker более подробно показаны реализации каждого из этих режимов. Пример кода позволяет пользователю переключаться между режимами обработки, что может не потребоваться для вашего варианта использования.

Обратите внимание на следующее:

При работе в режиме видео или в режиме прямой трансляции вы также должны предоставить метку времени входного кадра задаче Hand Landmarker.

При работе в режиме изображения или видео задача Hand Landmarker блокирует текущий поток до тех пор, пока не завершит обработку входного изображения или кадра. Чтобы избежать блокировки текущего потока, выполните обработку в фоновом потоке с помощью платформ iOS Dispatch или NSOperation .

При работе в режиме прямой трансляции задача Hand Landmarker немедленно возвращается и не блокирует текущий поток. Он вызывает метод

handLandmarker(_:didFinishDetection:timestampInMilliseconds:error:)с результатом маркера руки после обработки каждого входного кадра. Hand Landmarker вызывает этот метод асинхронно в выделенной последовательной очереди отправки. Для отображения результатов в пользовательском интерфейсе отправьте результаты в основную очередь после обработки результатов. Если функцияdetectAsyncвызывается, когда задача Hand Landmarker занята обработкой другого кадра, Hand Landmarker игнорирует новый входной кадр.

Обработка и отображение результатов

После выполнения вывода задача Hand Landmarker возвращает HandLandmarkerResult , который содержит ориентиры рук в координатах изображения, ориентиры рук в мировых координатах и направление руки (левая/правая рука) обнаруженных рук.

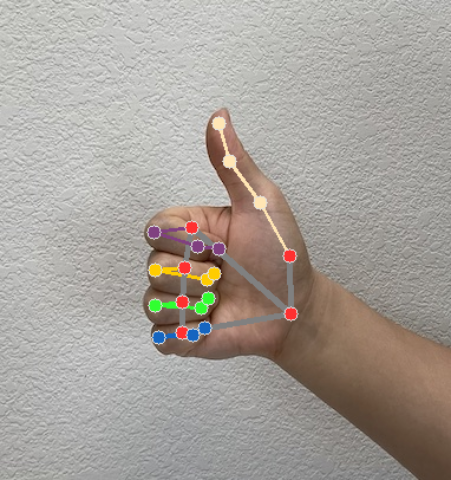

Ниже показан пример выходных данных этой задачи:

Выходные данные HandLandmarkerResult содержат три компонента. Каждый компонент представляет собой массив, где каждый элемент содержит следующие результаты для одной обнаруженной руки:

Рукава

Handedness показывает, являются ли обнаруженные руки левыми или правыми.

Достопримечательности

Имеется 21 ручной ориентир, каждый из которых состоит из координат

x,yиz. Координатыxиyнормализуются на [0,0, 1,0] по ширине и высоте изображения соответственно. Координатаzпредставляет глубину ориентира, при этом глубина на запястье является началом координат. Чем меньше значение, тем ближе ориентир к камере. Величинаzиспользует примерно тот же масштаб, что иx.Достопримечательности мира

21 ориентир также представлен в мировых координатах. Каждый ориентир состоит из

x,yиz, представляющих реальные трехмерные координаты в метрах с началом координат в геометрическом центре руки.

HandLandmarkerResult:

Handedness:

Categories #0:

index : 0

score : 0.98396

categoryName : Left

Landmarks:

Landmark #0:

x : 0.638852

y : 0.671197

z : -3.41E-7

Landmark #1:

x : 0.634599

y : 0.536441

z : -0.06984

... (21 landmarks for a hand)

WorldLandmarks:

Landmark #0:

x : 0.067485

y : 0.031084

z : 0.055223

Landmark #1:

x : 0.063209

y : -0.00382

z : 0.020920

... (21 world landmarks for a hand)

На следующем изображении показана визуализация результатов задачи: