در گوگل کولب اجرا کنید در گوگل کولب اجرا کنید |  مشاهده منبع در گیتهاب مشاهده منبع در گیتهاب |

نمای کلی

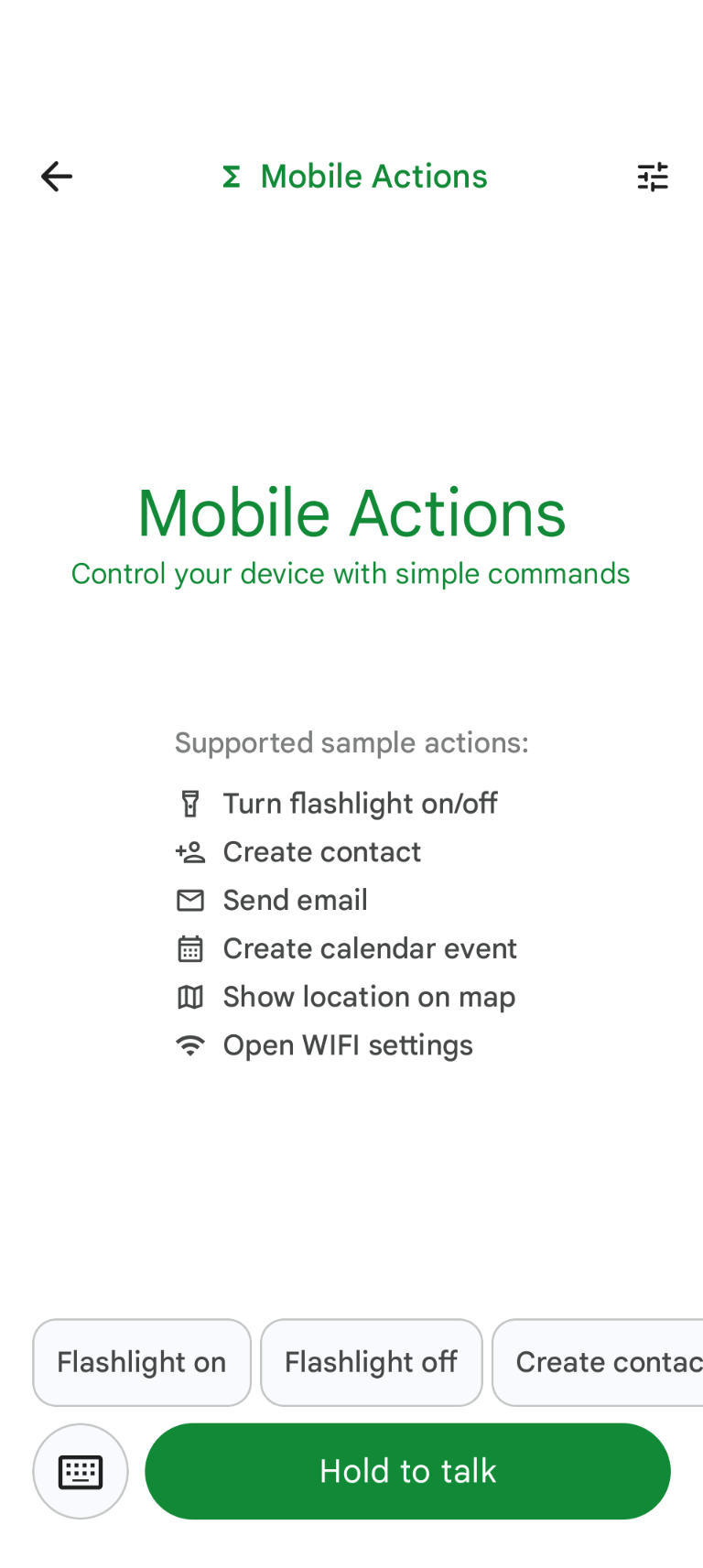

Mobile Actions یک اپلیکیشن آزمایشی است که در آن کاربران میتوانند از طریق ورودی صوتی یا متنی، اقداماتی را روی دستگاه خود انجام دهند. این اپلیکیشن، تعامل با دستیار را به عنوان یک قابلیت کاملاً آفلاین بازطراحی میکند. چه «ایجاد یک رویداد تقویم برای ناهار فردا»، «افزودن جان به مخاطبین من» یا «روشن کردن چراغ قوه» باشد، مدل، زبان طبیعی را تجزیه و تحلیل کرده و ابزار صحیح سیستم عامل را برای اجرای دستور شناسایی میکند.

این راهنما به شما نشان میدهد که چگونه:

- تنظیم دقیق مدل FunctionGemma 270M با استفاده از مجموعه داده Mobile Actions

- استقرار مدل سفارشی در گالری Google AI Edge

شما قادر خواهید بود از تنظیم دقیق یک مدل تا استقرار آن بر روی دستگاه، از ابتدا تا انتها را یاد بگیرید.

مرحله ۱: تنظیم دقیق FunctionGemma با مجموعه داده Mobile Actions

FunctionGemma یک مدل ۲۷۰ میلیون پارامتری مبتنی بر معماری Gemma 3 است. این مدل به طور خاص برای فراخوانی تابع آموزش دیده است و آن را قادر میسازد تا درخواستهای زبان طبیعی را به فراخوانیهای تابع تبدیل کند.

این مدل به اندازه کافی کوچک و کارآمد است که بتواند روی یک تلفن همراه اجرا شود، اما همانطور که برای مدلهایی با این اندازه رایج است، برای تخصصی شدن آن برای کاری که قرار است انجام دهد، نیاز به تنظیم دقیق دارد.

برای تنظیم دقیق FunctionGemma، از مجموعه داده Mobile Actions استفاده میکنیم که به صورت عمومی در Hugging Face در دسترس است. هر ورودی در این مجموعه داده موارد زیر را ارائه میدهد:

- مجموعه ابزارها (توابع) که مدل میتواند استفاده کند:

- چراغ قوه را روشن میکند

- چراغ قوه را خاموش میکند

- یک مخاطب در لیست مخاطبین تلفن ایجاد میکند

- ایمیل ارسال میکند

- یک مکان را روی نقشه نشان میدهد

- تنظیمات وایفای را باز میکند

- یک رویداد تقویم جدید ایجاد میکند

- اعلان سیستم، زمینهای مانند تاریخ و زمان فعلی را ارائه میدهد.

- درخواست کاربر، مانند

turn on the flashlight. - پاسخ مدل مورد انتظار، شامل فراخوانیهای تابع مناسب.

تابع show map به صورت زیر نمایش داده میشود:

{

"function": {

"name": "show_map",

"description": "Shows a location on the map.",

"parameters": {

"type": "OBJECT",

"properties": {

"query": {

"type": "STRING",

"description": "The location to search for. May be the name of a place, a business, or an address."

}

},

"required": [

"query"

]

}

}

}

دفترچه یادداشت colab تمام مراحل لازم، از جمله موارد زیر را پوشش میدهد:

- راهاندازی محیط

- بارگیری و پیشپردازش مجموعه دادههای Mobile Actions

- تنظیم دقیق مدل با استفاده از TRL در آغوش گرفتن چهره

- تبدیل مدل به فرمت

.litertlmبرای استقرار

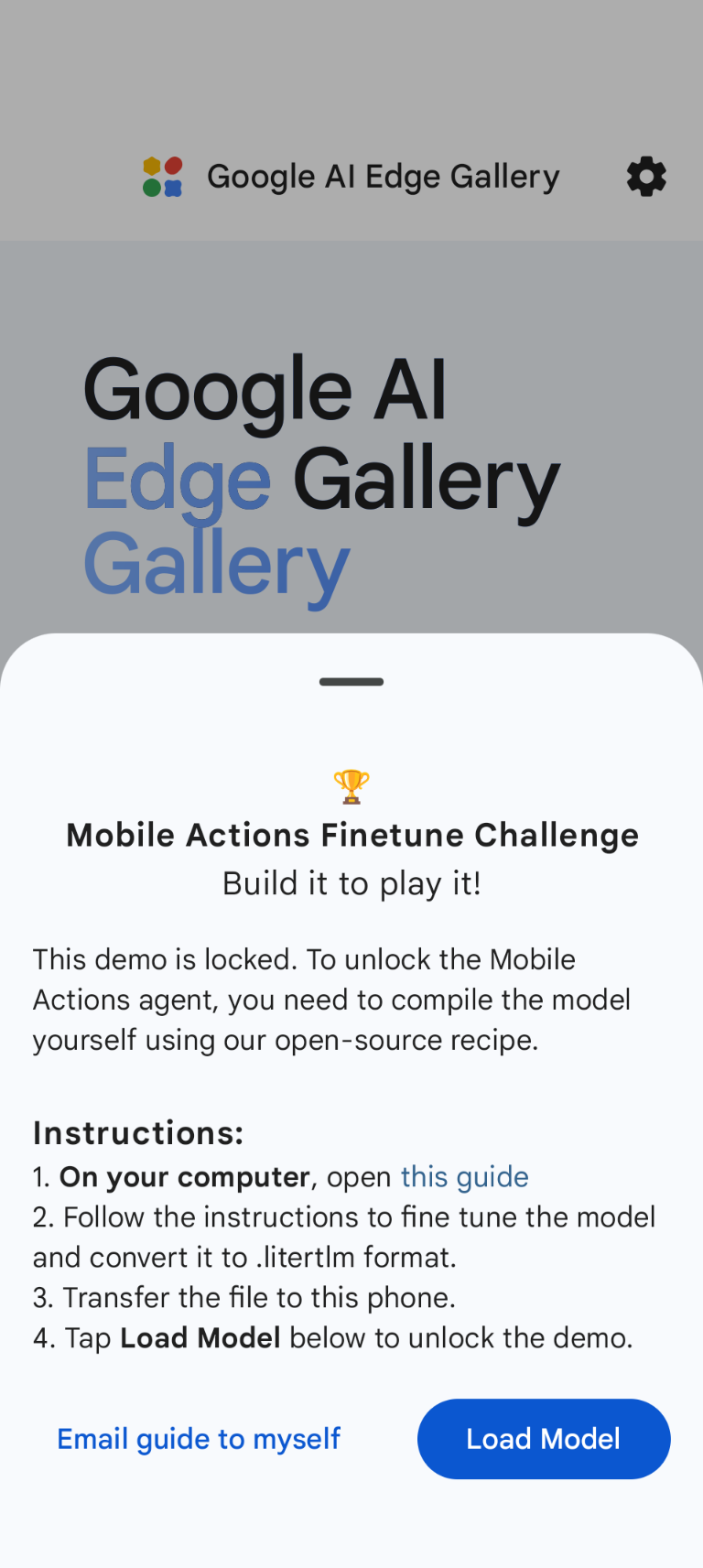

مرحله ۲: استقرار در گالری Google AI Edge

پیشنیاز : شما به همان حساب گوگلی که برای ذخیره فایل .litertlm در مرحله ۱ استفاده کردید و همچنین به همان حساب گوگلی که در گوشی اندروید خود با آن وارد شدهاید، نیاز دارید.

پس از تنظیم دقیق، وزنهای مدل را به فرمت .litertlm تبدیل و کوانتیزه میکنیم.

شما میتوانید با انتخاب Load Model و انتخاب آن از گوگل درایو (یا روش توزیع جایگزین)، مدل را در گزینه Google AI Edge Gallery - Mobile Actions مستقر کنید. گالری Google AI Edge در فروشگاه گوگل پلی موجود است.

حالا میتوانید یک فرمان صوتی بدهید یا در برنامه تایپ کنید تا ببینید مدل جدید و تنظیمشدهتان چقدر در فراخوانی عملکردهای موجود خوب عمل میکند.

مراحل بعدی

تبریک! حالا شما میدانید که چگونه یک مدل را با Hugging Face تنظیم دقیق کنید و آن را با LiteRT-LM روی دستگاه مستقر کنید.