استقرار ML و GenAI با کارایی بالا در پلتفرمهای لبهای

تبدیل، زمان اجرا و بهینهسازی کارآمد برای یادگیری ماشینی روی دستگاه.

ساخته شده بر پایه TensorFlow Lite که در نبردها آزمایش شده است

LiteRT فقط یک پلتفرم جدید نیست؛ بلکه نسل بعدیِ گستردهترین محیط اجرای یادگیری ماشین در جهان است. این پلتفرم، برنامههایی را که هر روز استفاده میکنید، قدرتمند میکند و تأخیر کم و حریم خصوصی بالایی را در میلیاردها دستگاه ارائه میدهد.

مورد اعتماد مهمترین برنامههای گوگل

بیش از ۱۰۰ هزار برنامه، میلیاردها کاربر جهانی

نکات برجسته LiteRT

آماده برای پلتفرمهای مختلف

genAI را آزاد کنید

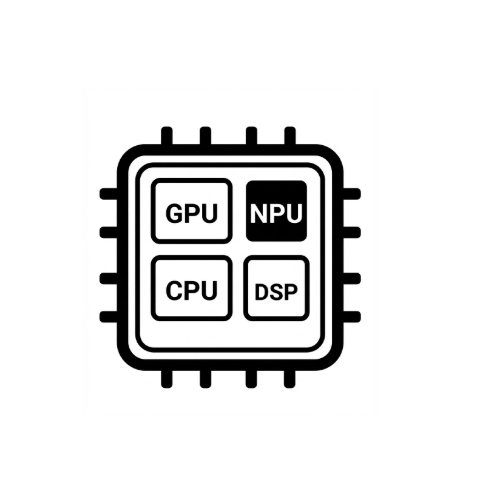

شتاب سختافزاری سادهشده

پشتیبانی از چند فریمورک

استقرار از طریق LiteRT

یک مدل دریافت کنید

از مدلهای از پیش آموزشدیدهی .tflite استفاده کنید یا مدلهای PyTorch، JAX یا TensorFlow را به .tflite تبدیل کنید.

بهینه سازی مدل

به صورت اختیاری، مدل را کوانتیزه کنید.

اجرا کن

شتابدهنده مورد نظر را انتخاب کنید و روی LiteRT اجرا کنید

نمونهها، مدلها و نسخههای نمایشی

نمونه برنامه را ببینید

آموزشها نحوه استفاده از LiteRT را با مثالهای کامل و جامع به شما نشان میدهند.

مدلهای genAI را ببینید

مدلهای هوش مصنوعی نسل جدید از پیش آموزشدیده و آماده.

مشاهده دموها - برنامه گالری Google AI Edge

گالری که موارد استفاده از ML/GenAI روی دستگاه را نشان میدهد